कर्नेल प्रधान घटक विश्लेषण: Difference between revisions

(→उदाहरण) |

No edit summary |

||

| Line 13: | Line 13: | ||

== पीसीए के लिए कर्नेल का परिचय == | == पीसीए के लिए कर्नेल का परिचय == | ||

कर्नेल पीसीए की उपयोगिता को समझने के लिए, विशेष रूप से क्लस्टरिंग के लिए, निरीक्षण करें कि, जबकि एन अंक सामान्य रूप से [[रैखिक पृथक्करण|रैखिक पृथक्करणीयता]] नहीं हो सकते हैं <math>d < N</math> आयाम, वे [[लगभग हमेशा]] रैखिक रूप से अलग हो सकते हैं <math>d \geq N</math> आयाम। | कर्नेल पीसीए की उपयोगिता को समझने के लिए, विशेष रूप से क्लस्टरिंग के लिए, निरीक्षण करें कि, जबकि एन अंक सामान्य रूप से [[रैखिक पृथक्करण|रैखिक पृथक्करणीयता]] नहीं हो सकते हैं <math>d < N</math> आयाम, वे [[लगभग हमेशा]] रैखिक रूप से अलग हो सकते हैं <math>d \geq N</math> आयाम। अर्थात एन अंक दिए गए हैं, <math>\mathbf{x}_i</math>, यदि हम उन्हें एन-डायमेंशनल स्थान के साथ मैप करते हैं | ||

:<math>\Phi(\mathbf{x}_i)</math> कहाँ <math>\Phi : \mathbb{R}^d \to \mathbb{R}^N</math>, | :<math>\Phi(\mathbf{x}_i)</math> कहाँ <math>\Phi : \mathbb{R}^d \to \mathbb{R}^N</math>, | ||

एक [[ hyperplane |हाइपरप्लेन]] का निर्माण करना आसान है जो बिंदुओं को मनमाना समूहों में विभाजित करता है। बेशक, यह <math>\Phi</math> रैखिक रूप से स्वतंत्र वैक्टर बनाता है, इसलिए ऐसा कोई सहप्रसरण नहीं है जिस पर स्पष्ट रूप से आइगेनडीकंपोजिशन किया जा सके जैसा कि हम रैखिक पीसीए में करते हैं। | एक [[ hyperplane |हाइपरप्लेन]] का निर्माण करना आसान है जो बिंदुओं को मनमाना समूहों में विभाजित करता है। बेशक, यह <math>\Phi</math> रैखिक रूप से स्वतंत्र वैक्टर बनाता है, इसलिए ऐसा कोई सहप्रसरण नहीं है जिस पर स्पष्ट रूप से आइगेनडीकंपोजिशन किया जा सके जैसा कि हम रैखिक पीसीए में करते हैं। | ||

इसके | इसके अतिरिक्त, कर्नेल पीसीए में, एक गैर-तुच्छ, मनमाना <math>\Phi</math> फ़ंक्शन 'चयनित' है जिसकी कभी भी स्पष्ट रूप से गणना नहीं की जाती है, जिससे संभावना को बहुत उच्च-आयामी उपयोग करने की अनुमति मिलती है <math>\Phi</math> यदि हमें वास्तव में उस स्थान में डेटा का मूल्यांकन नहीं करना है। चूंकि हम सामान्यतः काम करने से बचने की प्रयास करते हैं <math>\Phi</math>-स्पेस, जिसे हम 'फीचर स्पेस' कहेंगे, हम एन-बाय-एन कर्नेल बना सकते हैं | ||

:<math>K = k(\mathbf{x},\mathbf{y}) = (\Phi(\mathbf{x}),\Phi(\mathbf{y})) = \Phi(\mathbf{x})^T\Phi(\mathbf{y})</math> | :<math>K = k(\mathbf{x},\mathbf{y}) = (\Phi(\mathbf{x}),\Phi(\mathbf{y})) = \Phi(\mathbf{x})^T\Phi(\mathbf{y})</math> | ||

| Line 35: | Line 35: | ||

कहाँ <math>\mathbf{1_N}</math> एन-बाय-एन मैट्रिक्स को दर्शाता है जिसके लिए प्रत्येक तत्व मान लेता है <math>1/N</math>. हम उपयोग करते हैं <math>K'</math> ऊपर वर्णित कर्नेल पीसीए एल्गोरिथम को निष्पादित करने के लिए। | कहाँ <math>\mathbf{1_N}</math> एन-बाय-एन मैट्रिक्स को दर्शाता है जिसके लिए प्रत्येक तत्व मान लेता है <math>1/N</math>. हम उपयोग करते हैं <math>K'</math> ऊपर वर्णित कर्नेल पीसीए एल्गोरिथम को निष्पादित करने के लिए। | ||

कर्नेल पीसीए की एक चेतावनी को यहाँ उदाहरण से स्पष्ट किया जाना चाहिए। रैखिक पीसीए में, हम प्रत्येक प्रमुख घटक द्वारा डेटा की कितनी भिन्नता पर आधारित अभिलक्षणिक सदिशों को रैंक करने के लिए अभिलक्षणिक मान का उपयोग कर सकते हैं। यह डेटा आयाम में कमी के लिए उपयोगी है और इसे केपीसीए पर भी लागू किया जा सकता है। हालाँकि, व्यवहार में ऐसे | कर्नेल पीसीए की एक चेतावनी को यहाँ उदाहरण से स्पष्ट किया जाना चाहिए। रैखिक पीसीए में, हम प्रत्येक प्रमुख घटक द्वारा डेटा की कितनी भिन्नता पर आधारित अभिलक्षणिक सदिशों को रैंक करने के लिए अभिलक्षणिक मान का उपयोग कर सकते हैं। यह डेटा आयाम में कमी के लिए उपयोगी है और इसे केपीसीए पर भी लागू किया जा सकता है। हालाँकि, व्यवहार में ऐसे स्थितियों होते हैं कि डेटा की सभी विविधताएँ समान होती हैं। यह सामान्यतः कर्नेल स्केल के गलत चुनाव के कारण होता है। | ||

== बड़े डेटासेट == | == बड़े डेटासेट == | ||

| Line 42: | Line 42: | ||

== उदाहरण == | == उदाहरण == | ||

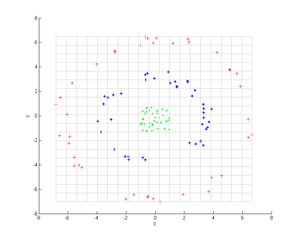

[[Image:Kernel pca input.png|thumb|300px|कर्नेल पीसीए से पहले इनपुट बिंदु]]बिंदुओं के तीन संकेंद्रित समूहों पर विचार करें (दिखाया गया है); हम इन समूहों की पहचान करने के लिए कर्नेल पीसीए का उपयोग करना चाहते हैं। बिंदुओं का रंग एल्गोरिथम में | [[Image:Kernel pca input.png|thumb|300px|कर्नेल पीसीए से पहले इनपुट बिंदु]]बिंदुओं के तीन संकेंद्रित समूहों पर विचार करें (दिखाया गया है); हम इन समूहों की पहचान करने के लिए कर्नेल पीसीए का उपयोग करना चाहते हैं। बिंदुओं का रंग एल्गोरिथम में सम्मलित जानकारी का प्रतिनिधित्व नहीं करता है, लेकिन केवल यह दर्शाता है कि परिवर्तन डेटा बिंदुओं को कैसे स्थानांतरित करता है। | ||

पहले कर्नेल पर विचार करें | पहले कर्नेल पर विचार करें | ||

| Line 49: | Line 49: | ||

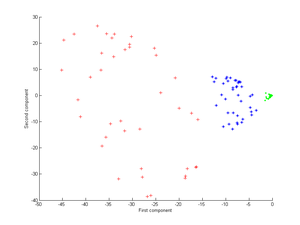

इसे कर्नेल पीसीए पर लागू करने से अगली छवि प्राप्त होती है। | इसे कर्नेल पीसीए पर लागू करने से अगली छवि प्राप्त होती है। | ||

[[Image:Kernel pca output.png|thumb|300px|कर्नेल पीसीए के | [[Image:Kernel pca output.png|thumb|300px|कर्नेल पीसीए के पश्चात आउटपुट <math>k(\boldsymbol{x},\boldsymbol{y}) = (\boldsymbol{x}^\mathrm{T}\boldsymbol{y} + 1)^2</math>. तीन समूहों को केवल पहले घटक का उपयोग करके पहचाना जा सकता है।]]अब गॉसियन कर्नेल पर विचार करें: | ||

: <math>k(\boldsymbol{x},\boldsymbol{y}) = e^\frac{-||\boldsymbol{x} - \boldsymbol{y}||^2}{2\sigma^2},</math> | : <math>k(\boldsymbol{x},\boldsymbol{y}) = e^\frac{-||\boldsymbol{x} - \boldsymbol{y}||^2}{2\sigma^2},</math> | ||

Revision as of 17:48, 28 May 2023

बहुभिन्नरूपी सांख्यिकी के क्षेत्र में, कर्नेल प्रिंसिपल कंपोनेंट एनालिसिस (कर्नेल पीसीए)[1] कर्नेल विधियों की तकनीकों का उपयोग करके प्रिंसिपल कंपोनेंट एनालिसिस (पीसीए) का एक विस्तार है। कर्नेल का उपयोग करते हुए, पीसीए का मूल रूप से रैखिक संचालन एक पुनरुत्पादित कर्नेल हिल्बर्ट स्पेस में किया जाता है।

पृष्ठभूमि: रैखिक पीसीए

याद रखें कि पारंपरिक पीसीए शून्य-केंद्रित डेटा पर काम करता है; वह है,

- ,

कहाँ इनमें से एक है बहुभिन्नरूपी अवलोकन। यह सहप्रसरण मैट्रिक्स को विकर्ण करके संचालित होता है,

दूसरे शब्दों में, यह सहप्रसरण मैट्रिक्स का एक आइगेनडीकंपोजिशन देता है:

जिसे फिर से लिखा जा सकता है

- .[2]

(यह भी देखें: सहप्रसरण मैट्रिक्स एक रैखिक ऑपरेटर के रूप में)

पीसीए के लिए कर्नेल का परिचय

कर्नेल पीसीए की उपयोगिता को समझने के लिए, विशेष रूप से क्लस्टरिंग के लिए, निरीक्षण करें कि, जबकि एन अंक सामान्य रूप से रैखिक पृथक्करणीयता नहीं हो सकते हैं आयाम, वे लगभग हमेशा रैखिक रूप से अलग हो सकते हैं आयाम। अर्थात एन अंक दिए गए हैं, , यदि हम उन्हें एन-डायमेंशनल स्थान के साथ मैप करते हैं

- कहाँ ,

एक हाइपरप्लेन का निर्माण करना आसान है जो बिंदुओं को मनमाना समूहों में विभाजित करता है। बेशक, यह रैखिक रूप से स्वतंत्र वैक्टर बनाता है, इसलिए ऐसा कोई सहप्रसरण नहीं है जिस पर स्पष्ट रूप से आइगेनडीकंपोजिशन किया जा सके जैसा कि हम रैखिक पीसीए में करते हैं।

इसके अतिरिक्त, कर्नेल पीसीए में, एक गैर-तुच्छ, मनमाना फ़ंक्शन 'चयनित' है जिसकी कभी भी स्पष्ट रूप से गणना नहीं की जाती है, जिससे संभावना को बहुत उच्च-आयामी उपयोग करने की अनुमति मिलती है यदि हमें वास्तव में उस स्थान में डेटा का मूल्यांकन नहीं करना है। चूंकि हम सामान्यतः काम करने से बचने की प्रयास करते हैं -स्पेस, जिसे हम 'फीचर स्पेस' कहेंगे, हम एन-बाय-एन कर्नेल बना सकते हैं

जो आंतरिक उत्पाद स्थान (ग्रामियन मैट्रिक्स देखें) का प्रतिनिधित्व करता है। एक कर्नेल के निर्माण में उत्पन्न होने वाला दोहरा रूप हमें गणितीय रूप से पीसीए के एक संस्करण को तैयार करने की अनुमति देता है जिसमें हम वास्तव में सहप्रसरण मैट्रिक्स के अभिलक्षणिक सदिश और अभिलक्षणिक मान को हल नहीं करते हैं। -स्पेस (कर्नेल चाल देखें)। K के प्रत्येक स्तंभ में N-तत्व सभी रूपांतरित बिंदुओं (N बिंदुओं) के संबंध में रूपांतरित डेटा के एक बिंदु के डॉट उत्पाद का प्रतिनिधित्व करते हैं। नीचे दिए गए उदाहरण में कुछ जाने-माने कर्नेल दिखाए गए हैं।

क्योंकि हम कभी भी फीचर स्पेस में सीधे काम नहीं कर रहे हैं, पीसीए का कर्नेल-फॉर्मूलेशन प्रतिबंधित है, क्योंकि यह स्वयं प्रमुख घटकों की गणना नहीं करता है, बल्कि उन घटकों पर हमारे डेटा के अनुमानों की गणना करता है। फीचर स्पेस में एक बिंदु से प्रक्षेपण का मूल्यांकन करने के लिए kवें प्रमुख घटक पर (जहाँ सुपरस्क्रिप्ट k का अर्थ है घटक k, k की शक्तियाँ नहीं)

हमने ध्यान दिया कि डॉट उत्पाद को दर्शाता है, जो केवल कर्नेल के तत्व हैं है। ऐसा लगता है कि जो कुछ बचा है, उसकी गणना और सामान्यीकरण करना है , जो अभिलक्षणिक सदिश समीकरण को हल करके किया जा सकता है

कहाँ सेट में डेटा बिंदुओं की संख्या है, और और के अभिलक्षणिक मान और अभिलक्षणिक सदिश हैं . फिर अभिलक्षणिक सदिश को सामान्य करने के लिए ,की हमें आवश्यकता होती है

इस बात का ध्यान रखा जाना चाहिए कि अपने मूल स्थान में शून्य-माध्य है या नहीं है, यह सुविधा स्थान में केंद्रित होने की गारंटी नहीं है (जिसे हम कभी भी स्पष्ट रूप से गणना नहीं करते हैं)। चूंकि एक प्रभावी प्रमुख घटक विश्लेषण करने के लिए केंद्रित डेटा की आवश्यकता होती है, इसलिए हमें 'केंद्रित मैट्रिक्स' बनना है

कहाँ एन-बाय-एन मैट्रिक्स को दर्शाता है जिसके लिए प्रत्येक तत्व मान लेता है . हम उपयोग करते हैं ऊपर वर्णित कर्नेल पीसीए एल्गोरिथम को निष्पादित करने के लिए।

कर्नेल पीसीए की एक चेतावनी को यहाँ उदाहरण से स्पष्ट किया जाना चाहिए। रैखिक पीसीए में, हम प्रत्येक प्रमुख घटक द्वारा डेटा की कितनी भिन्नता पर आधारित अभिलक्षणिक सदिशों को रैंक करने के लिए अभिलक्षणिक मान का उपयोग कर सकते हैं। यह डेटा आयाम में कमी के लिए उपयोगी है और इसे केपीसीए पर भी लागू किया जा सकता है। हालाँकि, व्यवहार में ऐसे स्थितियों होते हैं कि डेटा की सभी विविधताएँ समान होती हैं। यह सामान्यतः कर्नेल स्केल के गलत चुनाव के कारण होता है।

बड़े डेटासेट

व्यवहार में, एक बड़ा डेटा सेट एक बड़े K की ओर ले जाता है, और K को स्टोर करना एक समस्या बन सकता है। इससे निपटने का एक उपाय डेटासेट पर क्लस्टरिंग करना है, और उन क्लस्टर्स के माध्यम से कर्नेल को पॉप्युलेट करना है। चूँकि यह विधि भी अपेक्षाकृत बड़ा K उत्पन्न कर सकती है, केवल शीर्ष पी अभिलक्षणिक मान की गणना करना सामान्य है और अभिलक्षणिक मान के अभिलक्षणिक सदिश की गणना इस तरह से की जाती है।

उदाहरण

बिंदुओं के तीन संकेंद्रित समूहों पर विचार करें (दिखाया गया है); हम इन समूहों की पहचान करने के लिए कर्नेल पीसीए का उपयोग करना चाहते हैं। बिंदुओं का रंग एल्गोरिथम में सम्मलित जानकारी का प्रतिनिधित्व नहीं करता है, लेकिन केवल यह दर्शाता है कि परिवर्तन डेटा बिंदुओं को कैसे स्थानांतरित करता है।

पहले कर्नेल पर विचार करें

इसे कर्नेल पीसीए पर लागू करने से अगली छवि प्राप्त होती है।

अब गॉसियन कर्नेल पर विचार करें:

यही है, यह कर्नेल निकटता का माप है, 1 के बराबर जब अंक मिलते हैं और अनंत पर तब 0 के बराबर होते हैं।

विशेष रूप से ध्यान दें कि पहला प्रमुख घटक तीन अलग-अलग समूहों को अलग करने के लिए पर्याप्त है, जब कि केवल रैखिक पीसीए का उपयोग करना असंभव है, क्योंकि रैखिक पीसीए केवल दिए गए (इस मामले में द्वि-आयामी) स्थान में संचालित होता है, जिसमें ये बिंदुओं के तीन संकेंद्रित समूह हैं रैखिक रूप से वियोज्य नहीं।

अनुप्रयोग

कर्नेल पीसीए को नवीनता का पता लगाना[3] और इमेज डी-नॉइज़िंग के लिए उपयोगी दिखाया गया है।[4]

यह भी देखें

- क्लस्टर विश्लेषण

- गैर रेखीय आयामीता में कमी

- स्पेक्ट्रल क्लस्टरिंग

संदर्भ

- ↑ Schölkopf, Bernhard; Smola, Alex; Müller, Klaus-Robert (1998). "कर्नेल आइगेनवैल्यू प्रॉब्लम के रूप में नॉनलाइनियर कंपोनेंट एनालिसिस". Neural Computation. 10 (5): 1299–1319. CiteSeerX 10.1.1.100.3636. doi:10.1162/089976698300017467. S2CID 6674407.

- ↑ Scholkopf, Bernhard; Smola, Alexander; Müller, Klaus-Robert (December 1996). कर्नेल आइगेनवैल्यू प्रॉब्लम के रूप में नॉनलाइनियर कंपोनेंट एनालिसिस (PDF) (Technical report). Max-Planck-Institut für biologische Kybernetik. 44.

- ↑ Hoffmann, Heiko (2007). "नॉवेल्टी डिटेक्शन के लिए कर्नेल पीसीए". Pattern Recognition. 40 (3): 863–874. doi:10.1016/j.patcog.2006.07.009.

- ↑ Kernel PCA and De-Noising in Feature Spaces. NIPS, 1999