पुनरावर्ती न्यूनतम वर्ग फ़िल्टर: Difference between revisions

(Created page with "पुनरावर्ती न्यूनतम वर्ग (आरएलएस) एक अनुकूली फ़िल्टर एल्गोरिदम ह...") |

No edit summary |

||

| Line 1: | Line 1: | ||

पुनरावर्ती न्यूनतम वर्ग (आरएलएस) एक [[अनुकूली फ़िल्टर]] | '''पुनरावर्ती न्यूनतम वर्ग (आरएलएस)''' एक [[अनुकूली फ़िल्टर]] एल्गोरिथ्म है जो पुनरावर्ती रूप से उन गुणांकों को ढूंढता है जो इनपुट संकेत से संबंधित भारित रैखिक न्यूनतम वर्ग लागत फ़ंक्शन को कम करते हैं। यह दृष्टिकोण अन्य एल्गोरिदम जैसे कि [[न्यूनतम माध्य वर्ग]] (एलएमएस) के विपरीत है जिसका लक्ष्य माध्य वर्ग त्रुटि को कम करना है। आरएलएस की व्युत्पत्ति में, इनपुट संकेतों को नियतात्मक माना जाता है, जबकि एलएमएस और इसी तरह के एल्गोरिदम के लिए उन्हें [[स्टोकेस्टिक]] माना जाता है। अपने अधिकांश प्रतिस्पर्धियों की तुलना में, आरएलएस अत्यंत तीव्र अभिसरण प्रदर्शित करता है। हालाँकि, यह लाभ उच्च कम्प्यूटेशनल सम्मिश्रता की कीमत पर मिलता है। | ||

==प्रेरणा== | ==प्रेरणा== | ||

आरएलएस की खोज | आरएलएस की खोज गॉस ने की थी, लेकिन 1950 तक अप्रयुक्त या नजरअंदाज कर दिया गया था, जब प्लैकेट ने 1821 में गॉस के मूल कार्य को फिर से खोजा था। सामान्य तौर पर, आरएलएस का उपयोग किसी भी समस्या को हल करने के लिए किया जा सकता है जिसे अनुकूली फिल्टर द्वारा हल किया जा सकता है। उदाहरण के लिए, मान लीजिए कि एक संकेत <math>d(n)</math> एक प्रतिध्वनि वाले, ध्वनि वाले चैनल पर प्रसारित होता है जिसके कारण इसे प्राप्त किया जाता है | ||

:<math>x(n)=\sum_{k=0}^q b_n(k) d(n-k)+v(n)</math> | :<math>x(n)=\sum_{k=0}^q b_n(k) d(n-k)+v(n)</math> | ||

जहां <math>v(n)</math> योगात्मक शोर का प्रतिनिधित्व करता है। आरएलएस फ़िल्टर का उद्देश्य <math>p+1</math>-टैप FIR फ़िल्टर के उपयोग से वांछित संकेत <math>d(n)</math> को पुनर्प्राप्त करना है, <math>\mathbf{w}</math>: | |||

:<math>d(n) \approx \sum_{k=0}^{p} w(k)x(n-k)=\mathbf{w}^\mathit{T} \mathbf{x}_n</math> | :<math>d(n) \approx \sum_{k=0}^{p} w(k)x(n-k)=\mathbf{w}^\mathit{T} \mathbf{x}_n</math> | ||

जहां <math>\mathbf{x}_n = [x(n)\quad x(n-1)\quad\ldots\quad x(n-p)]^T</math> कॉलम वेक्टर है जिसमें <math>x(n)</math> के सबसे हाल के नमूने <math>p+1</math> शामिल हैं। प्राप्त वांछित संकेत का अनुमान है | |||

:<math>\hat{d}(n) = \sum_{k=0}^{p} w_n(k)x(n-k)=\mathbf{w}_n^\mathit{T} \mathbf{x}_n</math> | :<math>\hat{d}(n) = \sum_{k=0}^{p} w_n(k)x(n-k)=\mathbf{w}_n^\mathit{T} \mathbf{x}_n</math> | ||

| Line 25: | Line 25: | ||

भारित न्यूनतम वर्ग त्रुटि फ़ंक्शन <math>C</math>- जिस लागत फ़ंक्शन को हम कम करना चाहते हैं - वह एक फ़ंक्शन है <math>e(n)</math> इसलिए फ़िल्टर गुणांक पर भी निर्भर है: | भारित न्यूनतम वर्ग त्रुटि फ़ंक्शन <math>C</math>- जिस लागत फ़ंक्शन को हम कम करना चाहते हैं - वह एक फ़ंक्शन है <math>e(n)</math> इसलिए फ़िल्टर गुणांक पर भी निर्भर है: | ||

:<math>C(\mathbf{w}_n)=\sum_{i=0}^n\lambda^{n-i}e^2(i)</math> | :<math>C(\mathbf{w}_n)=\sum_{i=0}^n\lambda^{n-i}e^2(i)</math> | ||

जहाँ <math>0<\lambda\le 1</math> भूलने वाला कारक है जो पुराने त्रुटि नमूनों को तेजी से कम महत्व देता है। | |||

सभी प्रविष्टियों के लिए आंशिक व्युत्पन्न लेकर लागत फ़ंक्शन को कम किया जाता है <math>k</math> गुणांक वेक्टर का <math>\mathbf{w}_{n}</math> और परिणामों को शून्य पर सेट करना | सभी प्रविष्टियों के लिए आंशिक व्युत्पन्न लेकर लागत फ़ंक्शन को कम किया जाता है <math>k</math> गुणांक वेक्टर का <math>\mathbf{w}_{n}</math> और परिणामों को शून्य पर सेट करना | ||

| Line 35: | Line 35: | ||

इस रूप को मैट्रिक्स के संदर्भ में व्यक्त किया जा सकता है | इस रूप को मैट्रिक्स के संदर्भ में व्यक्त किया जा सकता है | ||

:<math>\mathbf{R}_{x}(n)\,\mathbf{w}_{n}=\mathbf{r}_{dx}(n)</math> | :<math>\mathbf{R}_{x}(n)\,\mathbf{w}_{n}=\mathbf{r}_{dx}(n)</math> | ||

जहाँ <math>\mathbf{R}_{x}(n)</math> के लिए भारित [[नमूना माध्य और नमूना सहप्रसरण]] मैट्रिक्स है <math>x(n)</math>, और <math>\mathbf{r}_{dx}(n)</math> के बीच [[ क्रॉस-सहप्रसरण ]] के लिए समतुल्य अनुमान है <math>d(n)</math> और <math>x(n)</math>. इस अभिव्यक्ति के आधार पर हम ऐसे गुणांक पाते हैं जो लागत फ़ंक्शन को कम करते हैं | |||

:<math>\mathbf{w}_{n}=\mathbf{R}_{x}^{-1}(n)\,\mathbf{r}_{dx}(n)</math> | :<math>\mathbf{w}_{n}=\mathbf{R}_{x}^{-1}(n)\,\mathbf{r}_{dx}(n)</math> | ||

यह चर्चा का मुख्य परिणाम है. | यह चर्चा का मुख्य परिणाम है. | ||

| Line 47: | Line 47: | ||

चर्चा के परिणामस्वरूप गुणांक वेक्टर निर्धारित करने के लिए एक एकल समीकरण तैयार हुआ जो लागत फ़ंक्शन को न्यूनतम करता है। इस अनुभाग में हम प्रपत्र का पुनरावर्ती समाधान प्राप्त करना चाहते हैं | चर्चा के परिणामस्वरूप गुणांक वेक्टर निर्धारित करने के लिए एक एकल समीकरण तैयार हुआ जो लागत फ़ंक्शन को न्यूनतम करता है। इस अनुभाग में हम प्रपत्र का पुनरावर्ती समाधान प्राप्त करना चाहते हैं | ||

:<math>\mathbf{w}_{n}=\mathbf{w}_{n-1}+\Delta\mathbf{w}_{n-1}</math> | :<math>\mathbf{w}_{n}=\mathbf{w}_{n-1}+\Delta\mathbf{w}_{n-1}</math> | ||

जहाँ <math>\Delta\mathbf{w}_{n-1}</math> समय पर एक सुधार कारक है <math>{n-1}</math>. हम क्रॉस सहप्रसरण को व्यक्त करके पुनरावर्ती एल्गोरिदम की व्युत्पत्ति शुरू करते हैं <math>\mathbf{r}_{dx}(n)</math> के अनुसार <math>\mathbf{r}_{dx}(n-1)</math> | |||

:{| | :{| | ||

|- | |- | ||

| Line 59: | Line 59: | ||

|<math>=\lambda\mathbf{r}_{dx}(n-1)+d(n)\mathbf{x}(n)</math> | |<math>=\lambda\mathbf{r}_{dx}(n-1)+d(n)\mathbf{x}(n)</math> | ||

|} | |} | ||

जहाँ <math>\mathbf{x}(i)</math> है <math>{p+1}</math> आयामी डेटा वेक्टर | |||

:<math>\mathbf{x}(i)=[x(i), x(i-1), \dots , x(i-p) ]^{T}</math> | :<math>\mathbf{x}(i)=[x(i), x(i-1), \dots , x(i-p) ]^{T}</math> | ||

वैसे ही हम व्यक्त करते हैं <math>\mathbf{R}_{x}(n)</math> के अनुसार <math>\mathbf{R}_{x}(n-1)</math> द्वारा | वैसे ही हम व्यक्त करते हैं <math>\mathbf{R}_{x}(n)</math> के अनुसार <math>\mathbf{R}_{x}(n-1)</math> द्वारा | ||

| Line 172: | Line 172: | ||

|<math>=\mathbf{w}_{n-1}+\mathbf{g}(n)\alpha(n)</math> | |<math>=\mathbf{w}_{n-1}+\mathbf{g}(n)\alpha(n)</math> | ||

|} | |} | ||

जहाँ <math>\alpha(n)=d(n)-\mathbf{x}^{T}(n)\mathbf{w}_{n-1}</math> | |||

[[एक प्राथमिकता और एक पश्चवर्ती]] त्रुटि है। इसकी तुलना पिछली त्रुटि से करें; फ़िल्टर अद्यतन होने के बाद गणना की गई त्रुटि: | [[एक प्राथमिकता और एक पश्चवर्ती]] त्रुटि है। इसकी तुलना पिछली त्रुटि से करें; फ़िल्टर अद्यतन होने के बाद गणना की गई त्रुटि: | ||

| Line 224: | Line 224: | ||

==जाली पुनरावर्ती न्यूनतम वर्ग फ़िल्टर (एलआरएलएस)== | ==जाली पुनरावर्ती न्यूनतम वर्ग फ़िल्टर (एलआरएलएस)== | ||

जाली पुनरावर्ती न्यूनतम वर्ग अनुकूली फ़िल्टर मानक आरएलएस से संबंधित है, सिवाय इसके कि इसके लिए कम अंकगणितीय संचालन (आदेश ''एन'') की आवश्यकता होती है।<ref>Diniz, Paulo S.R., "Adaptive Filtering: Algorithms and Practical Implementation", Springer Nature Switzerland AG 2020, Chapter 7: Adaptive Lattice-Based RLS Algorithms. https://doi.org/10.1007/978-3-030-29057-3_7</ref> यह पारंपरिक एलएमएस एल्गोरिदम पर अतिरिक्त लाभ प्रदान करता है जैसे कि तेज अभिसरण दर, मॉड्यूलर संरचना, और इनपुट सहसंबंध मैट्रिक्स के ईजेनवैल्यू प्रसार में भिन्नता के प्रति असंवेदनशीलता। वर्णित एलआरएलएस एल्गोरिदम पिछली त्रुटियों पर आधारित है और इसमें सामान्यीकृत फॉर्म शामिल है। व्युत्पत्ति मानक आरएलएस एल्गोरिथ्म के समान है और की परिभाषा पर आधारित है <math>d(k)\,\!</math>. आगे की भविष्यवाणी के मामले में, हमारे पास है <math>d(k) = x(k)\,\!</math> इनपुट | जाली पुनरावर्ती न्यूनतम वर्ग अनुकूली फ़िल्टर मानक आरएलएस से संबंधित है, सिवाय इसके कि इसके लिए कम अंकगणितीय संचालन (आदेश ''एन'') की आवश्यकता होती है।<ref>Diniz, Paulo S.R., "Adaptive Filtering: Algorithms and Practical Implementation", Springer Nature Switzerland AG 2020, Chapter 7: Adaptive Lattice-Based RLS Algorithms. https://doi.org/10.1007/978-3-030-29057-3_7</ref> यह पारंपरिक एलएमएस एल्गोरिदम पर अतिरिक्त लाभ प्रदान करता है जैसे कि तेज अभिसरण दर, मॉड्यूलर संरचना, और इनपुट सहसंबंध मैट्रिक्स के ईजेनवैल्यू प्रसार में भिन्नता के प्रति असंवेदनशीलता। वर्णित एलआरएलएस एल्गोरिदम पिछली त्रुटियों पर आधारित है और इसमें सामान्यीकृत फॉर्म शामिल है। व्युत्पत्ति मानक आरएलएस एल्गोरिथ्म के समान है और की परिभाषा पर आधारित है <math>d(k)\,\!</math>. आगे की भविष्यवाणी के मामले में, हमारे पास है <math>d(k) = x(k)\,\!</math> इनपुट संकेत के साथ <math>x(k-1)\,\!</math> सबसे अद्यतित नमूने के रूप में। पिछड़ी भविष्यवाणी का मामला है <math>d(k) = x(k-i-1)\,\!</math>, जहां i अतीत में नमूने का सूचकांक है जिसकी हम भविष्यवाणी करना चाहते हैं, और इनपुट संकेत <math>x(k)\,\!</math> सबसे ताज़ा नमूना है.<ref>Albu, Kadlec, Softley, Matousek, Hermanek, Coleman, Fagan [http://wwwdsp.ucd.ie/dspfiles/main_files/pdf_files/hsla_fpl2001.pdf "Implementation of (Normalised) RLS Lattice on Virtex"], Digital Signal Processing, 2001, accessed December 24, 2011.</ref> | ||

Revision as of 08:11, 8 August 2023

पुनरावर्ती न्यूनतम वर्ग (आरएलएस) एक अनुकूली फ़िल्टर एल्गोरिथ्म है जो पुनरावर्ती रूप से उन गुणांकों को ढूंढता है जो इनपुट संकेत से संबंधित भारित रैखिक न्यूनतम वर्ग लागत फ़ंक्शन को कम करते हैं। यह दृष्टिकोण अन्य एल्गोरिदम जैसे कि न्यूनतम माध्य वर्ग (एलएमएस) के विपरीत है जिसका लक्ष्य माध्य वर्ग त्रुटि को कम करना है। आरएलएस की व्युत्पत्ति में, इनपुट संकेतों को नियतात्मक माना जाता है, जबकि एलएमएस और इसी तरह के एल्गोरिदम के लिए उन्हें स्टोकेस्टिक माना जाता है। अपने अधिकांश प्रतिस्पर्धियों की तुलना में, आरएलएस अत्यंत तीव्र अभिसरण प्रदर्शित करता है। हालाँकि, यह लाभ उच्च कम्प्यूटेशनल सम्मिश्रता की कीमत पर मिलता है।

प्रेरणा

आरएलएस की खोज गॉस ने की थी, लेकिन 1950 तक अप्रयुक्त या नजरअंदाज कर दिया गया था, जब प्लैकेट ने 1821 में गॉस के मूल कार्य को फिर से खोजा था। सामान्य तौर पर, आरएलएस का उपयोग किसी भी समस्या को हल करने के लिए किया जा सकता है जिसे अनुकूली फिल्टर द्वारा हल किया जा सकता है। उदाहरण के लिए, मान लीजिए कि एक संकेत एक प्रतिध्वनि वाले, ध्वनि वाले चैनल पर प्रसारित होता है जिसके कारण इसे प्राप्त किया जाता है

जहां योगात्मक शोर का प्रतिनिधित्व करता है। आरएलएस फ़िल्टर का उद्देश्य -टैप FIR फ़िल्टर के उपयोग से वांछित संकेत को पुनर्प्राप्त करना है, :

जहां कॉलम वेक्टर है जिसमें के सबसे हाल के नमूने शामिल हैं। प्राप्त वांछित संकेत का अनुमान है

लक्ष्य फ़िल्टर के मापदंडों का अनुमान लगाना है , और हर समय हम वर्तमान अनुमान को इस प्रकार संदर्भित करते हैं और द्वारा अनुकूलित न्यूनतम-वर्ग अनुमान . एक कॉलम वेक्टर भी है, जैसा कि नीचे दिखाया गया है, और खिसकाना , , एक पंक्ति सदिश है. मैट्रिक्स उत्पाद (जो कि डॉट उत्पाद है और ) है , एक अदिश राशि। अनुमान अच्छा है अगर कुछ न्यूनतम वर्ग अर्थों में परिमाण में छोटा है।

जैसे-जैसे समय विकसित होता है, नए अनुमान को खोजने के लिए न्यूनतम वर्ग एल्गोरिदम को पूरी तरह से दोबारा करने से बचना वांछित है , के अनुसार .

आरएलएस एल्गोरिदम का लाभ यह है कि मैट्रिक्स को उलटने की कोई आवश्यकता नहीं है, जिससे कम्प्यूटेशनल लागत बचती है। एक अन्य लाभ यह है कि यह कलमन फ़िल्टर जैसे परिणामों के पीछे अंतर्ज्ञान प्रदान करता है।

चर्चा

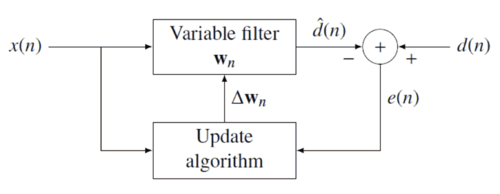

आरएलएस फ़िल्टर के पीछे का विचार हानि फ़ंक्शन को कम करना है फ़िल्टर गुणांकों का उचित चयन करके , नया डेटा आने पर फ़िल्टर को अपडेट करना। त्रुटि संकेत और वांछित संकेत नीचे नकारात्मक प्रतिक्रिया आरेख में परिभाषित किया गया है:

त्रुटि अनुमान के माध्यम से फ़िल्टर गुणांक पर परोक्ष रूप से निर्भर करती है :

त्रुटि अनुमान के माध्यम से फ़िल्टर गुणांक पर परोक्ष रूप से निर्भर करती है :

भारित न्यूनतम वर्ग त्रुटि फ़ंक्शन - जिस लागत फ़ंक्शन को हम कम करना चाहते हैं - वह एक फ़ंक्शन है इसलिए फ़िल्टर गुणांक पर भी निर्भर है:

जहाँ भूलने वाला कारक है जो पुराने त्रुटि नमूनों को तेजी से कम महत्व देता है।

सभी प्रविष्टियों के लिए आंशिक व्युत्पन्न लेकर लागत फ़ंक्शन को कम किया जाता है गुणांक वेक्टर का और परिणामों को शून्य पर सेट करना

अगला, बदलें त्रुटि संकेत की परिभाषा के साथ

समीकरण को पुनर्व्यवस्थित करने से परिणाम प्राप्त होते हैं

इस रूप को मैट्रिक्स के संदर्भ में व्यक्त किया जा सकता है

जहाँ के लिए भारित नमूना माध्य और नमूना सहप्रसरण मैट्रिक्स है , और के बीच क्रॉस-सहप्रसरण के लिए समतुल्य अनुमान है और . इस अभिव्यक्ति के आधार पर हम ऐसे गुणांक पाते हैं जो लागत फ़ंक्शन को कम करते हैं

यह चर्चा का मुख्य परिणाम है.

=== λ=== चुनना छोटे है, सहप्रसरण मैट्रिक्स में पिछले नमूनों का योगदान उतना ही छोटा है। यह फ़िल्टर को हाल के नमूनों के प्रति अधिक संवेदनशील बनाता है, जिसका अर्थ है फ़िल्टर गुणांक में अधिक उतार-चढ़ाव। h> केस को ग्रोइंग विंडो आरएलएस एल्गोरिदम के रूप में जाना जाता है। व्यवहार में, आमतौर पर 0.98 और 1 के बीच चुना जाता है।[1] टाइप- II अधिकतम संभावना अनुमान का उपयोग करके इष्टतम डेटा के एक सेट से अनुमान लगाया जा सकता है।[2]

पुनरावर्ती एल्गोरिथ्म

चर्चा के परिणामस्वरूप गुणांक वेक्टर निर्धारित करने के लिए एक एकल समीकरण तैयार हुआ जो लागत फ़ंक्शन को न्यूनतम करता है। इस अनुभाग में हम प्रपत्र का पुनरावर्ती समाधान प्राप्त करना चाहते हैं

जहाँ समय पर एक सुधार कारक है . हम क्रॉस सहप्रसरण को व्यक्त करके पुनरावर्ती एल्गोरिदम की व्युत्पत्ति शुरू करते हैं के अनुसार

जहाँ है आयामी डेटा वेक्टर

वैसे ही हम व्यक्त करते हैं के अनुसार द्वारा

गुणांक वेक्टर उत्पन्न करने के लिए हम नियतात्मक ऑटो-सहप्रसरण मैट्रिक्स के व्युत्क्रम में रुचि रखते हैं। उस कार्य के लिए वुडबरी मैट्रिक्स पहचान काम आती है। साथ

is -by- is -by-1 (column vector) is 1-by- (row vector) is the 1-by-1 identity matrix

वुडबरी मैट्रिक्स पहचान इस प्रकार है

मानक साहित्य के अनुरूप आने के लिए, हम परिभाषित करते हैं

जहां लाभ वेक्टर है

आगे बढ़ने से पहले ये लाना जरूरी है दूसरे रूप में

बायीं ओर का दूसरा पद घटाने पर प्राप्त होता है

की पुनरावर्ती परिभाषा के साथ वांछित प्रपत्र इस प्रकार है

अब हम रिकर्सन पूरा करने के लिए तैयार हैं। चर्चा के अनुसार

दूसरा चरण की पुनरावर्ती परिभाषा से अनुसरण करता है . आगे हम की पुनरावर्ती परिभाषा को शामिल करते हैं के वैकल्पिक रूप के साथ और पाओ

साथ हम अद्यतन समीकरण पर पहुँचते हैं

जहाँ एक प्राथमिकता और एक पश्चवर्ती त्रुटि है। इसकी तुलना पिछली त्रुटि से करें; फ़िल्टर अद्यतन होने के बाद गणना की गई त्रुटि:

इसका मतलब है कि हमें सुधार कारक मिल गया है

यह सहज रूप से संतोषजनक परिणाम इंगित करता है कि सुधार कारक त्रुटि और लाभ वेक्टर दोनों के लिए सीधे आनुपातिक है, जो भार कारक के माध्यम से नियंत्रित करता है कि कितनी संवेदनशीलता वांछित है, .

आरएलएस एल्गोरिदम सारांश

पी-वें ऑर्डर आरएलएस फ़िल्टर के लिए आरएलएस एल्गोरिदम को संक्षेप में प्रस्तुत किया जा सकता है

| Parameters: | filter order |

| forgetting factor | |

| value to initialize | |

| Initialization: | , |

| , | |

| where is the identity matrix of rank | |

| Computation: | For |

|

| |

| . |

के लिए प्रत्यावर्तन बीजगणितीय रिकाटी समीकरण का अनुसरण करता है और इस प्रकार कलमन फिल्टर के समानांतर खींचता है।[3]

जाली पुनरावर्ती न्यूनतम वर्ग फ़िल्टर (एलआरएलएस)

जाली पुनरावर्ती न्यूनतम वर्ग अनुकूली फ़िल्टर मानक आरएलएस से संबंधित है, सिवाय इसके कि इसके लिए कम अंकगणितीय संचालन (आदेश एन) की आवश्यकता होती है।[4] यह पारंपरिक एलएमएस एल्गोरिदम पर अतिरिक्त लाभ प्रदान करता है जैसे कि तेज अभिसरण दर, मॉड्यूलर संरचना, और इनपुट सहसंबंध मैट्रिक्स के ईजेनवैल्यू प्रसार में भिन्नता के प्रति असंवेदनशीलता। वर्णित एलआरएलएस एल्गोरिदम पिछली त्रुटियों पर आधारित है और इसमें सामान्यीकृत फॉर्म शामिल है। व्युत्पत्ति मानक आरएलएस एल्गोरिथ्म के समान है और की परिभाषा पर आधारित है . आगे की भविष्यवाणी के मामले में, हमारे पास है इनपुट संकेत के साथ सबसे अद्यतित नमूने के रूप में। पिछड़ी भविष्यवाणी का मामला है , जहां i अतीत में नमूने का सूचकांक है जिसकी हम भविष्यवाणी करना चाहते हैं, और इनपुट संकेत सबसे ताज़ा नमूना है.[5]

पैरामीटर सारांश

- अग्र परावर्तन गुणांक है

- पश्चगामी परावर्तन गुणांक है

- तात्कालिक पूर्ववर्ती अग्रगामी भविष्यवाणी त्रुटि का प्रतिनिधित्व करता है

- तात्कालिक पश्चगामी पूर्वानुमान त्रुटि का प्रतिनिधित्व करता है

- न्यूनतम न्यूनतम-वर्ग पिछड़ा पूर्वानुमान त्रुटि है

- न्यूनतम न्यूनतम-वर्ग अग्रेषित पूर्वानुमान त्रुटि है

- प्राथमिक और पश्चवर्ती त्रुटियों के बीच एक रूपांतरण कारक है

- फीडफॉरवर्ड गुणक गुणांक हैं।

- एक छोटा धनात्मक स्थिरांक है जो 0.01 हो सकता है

एलआरएलएस एल्गोरिदम सारांश

एलआरएलएस फ़िल्टर के लिए एल्गोरिदम को संक्षेप में प्रस्तुत किया जा सकता है

| Initialization: | |

| For | |

| (if for ) | |

| End | |

| Computation: | |

| For | |

| For | |

| Feedforward filtering | |

| End | |

| End | |

सामान्यीकृत जाली पुनरावर्ती न्यूनतम वर्ग फ़िल्टर (एनएलआरएलएस)

एलआरएलएस के सामान्यीकृत रूप में कम पुनरावृत्ति और चर होते हैं। इसकी गणना एल्गोरिदम के आंतरिक चर में सामान्यीकरण लागू करके की जा सकती है जो उनके परिमाण को एक से सीमित रखेगा। इसका उपयोग आम तौर पर वास्तविक समय के अनुप्रयोगों में नहीं किया जाता है क्योंकि विभाजन और वर्ग-रूट संचालन की संख्या उच्च कम्प्यूटेशनल लोड के साथ आती है।

एनएलआरएलएस एल्गोरिदम सारांश

एनएलआरएलएस फ़िल्टर के लिए एल्गोरिदम को संक्षेप में प्रस्तुत किया जा सकता है

| Initialization: | |

| For | |

| (if for ) | |

| End | |

| Computation: | |

| For | |

| (Input signal energy) | |

| (Reference signal energy) | |

| For | |

| Feedforward filter | |

| End | |

| End | |

यह भी देखें

- अनुकूली फ़िल्टर

- कर्नेल अनुकूली फ़िल्टर

- न्यूनतम माध्य वर्ग फ़िल्टर

- शून्य-बल तुल्यकारक

संदर्भ

- Hayes, Monson H. (1996). "9.4: Recursive Least Squares". Statistical Digital Signal Processing and Modeling. Wiley. p. 541. ISBN 0-471-59431-8.

- Simon Haykin, Adaptive Filter Theory, Prentice Hall, 2002, ISBN 0-13-048434-2

- M.H.A Davis, R.B. Vinter, Stochastic Modelling and Control, Springer, 1985, ISBN 0-412-16200-8

- Weifeng Liu, Jose Principe and Simon Haykin, Kernel Adaptive Filtering: A Comprehensive Introduction, John Wiley, 2010, ISBN 0-470-44753-2

- R.L.Plackett, Some Theorems in Least Squares, Biometrika, 1950, 37, 149–157, ISSN 0006-3444

- C.F.Gauss, Theoria combinationis observationum erroribus minimis obnoxiae, 1821, Werke, 4. Gottinge

टिप्पणियाँ

- ↑ Emannual C. Ifeacor, Barrie W. Jervis. Digital signal processing: a practical approach, second edition. Indianapolis: Pearson Education Limited, 2002, p. 718

- ↑ Steven Van Vaerenbergh, Ignacio Santamaría, Miguel Lázaro-Gredilla "Estimation of the forgetting factor in kernel recursive least squares", 2012 IEEE International Workshop on Machine Learning for Signal Processing, 2012, accessed June 23, 2016.

- ↑ Welch, Greg and Bishop, Gary "An Introduction to the Kalman Filter", Department of Computer Science, University of North Carolina at Chapel Hill, September 17, 1997, accessed July 19, 2011.

- ↑ Diniz, Paulo S.R., "Adaptive Filtering: Algorithms and Practical Implementation", Springer Nature Switzerland AG 2020, Chapter 7: Adaptive Lattice-Based RLS Algorithms. https://doi.org/10.1007/978-3-030-29057-3_7

- ↑ Albu, Kadlec, Softley, Matousek, Hermanek, Coleman, Fagan "Implementation of (Normalised) RLS Lattice on Virtex", Digital Signal Processing, 2001, accessed December 24, 2011.

[Category:Statistical signal processi