कम से कम औसत वर्ग फ़िल्टर: Difference between revisions

No edit summary |

No edit summary |

||

| Line 1: | Line 1: | ||

{{Short description|Statistical algorithm}}कम से कम औसत वर्ग (एलएमएस) एल्गोरिदम अनुकूली फ़िल्टर का वर्ग है जो फ़िल्टर गुणांक | {{Short description|Statistical algorithm}}'''कम से कम औसत वर्ग''' (एलएमएस) एल्गोरिदम अनुकूली फ़िल्टर का वर्ग है जो फ़िल्टर गुणांक खोजकर वांछित फ़िल्टर की प्रतिलिपि करने के लिए उपयोग किया जाता है जो त्रुटि संकेत (वांछित और वास्तविक संकेत के बीच अंतर) के कम से कम औसत वर्ग का उत्पादन करने से संबंधित है। यह स्टोकास्टिक ग्रेडियेंट डिसेंट विधि है जिसमें फ़िल्टर केवल वर्तमान समय में त्रुटि के आधार पर अनुकूलित किया जाता है। इसका आविष्कार 1960 में [[ स्टैनफोर्ड विश्वविद्यालय |स्टैनफोर्ड विश्वविद्यालय]] के प्रोफेसर [[बर्नार्ड विड्रो]] और उनके पहले पीएच.डी. छात्र, [[टेड हॉफ]] द्वारा किया गया था। | ||

== समस्या निर्माण == | == समस्या निर्माण == | ||

| Line 5: | Line 5: | ||

=== [[ विनीज़ फ़िल्टर | विनीज़ फ़िल्टर]] से संबंध === | === [[ विनीज़ फ़िल्टर | विनीज़ फ़िल्टर]] से संबंध === | ||

सिग्नल प्रोसेसिंग डोमेन को छोड़कर | सिग्नल प्रोसेसिंग डोमेन को छोड़कर कारण वीनर फ़िल्टर की प्राप्ति कम से कम वर्गों के अनुमान के समाधान की तरह दिखती है। इनपुट आव्यूह के लिए कम से कम वर्ग समाधान <math> | ||

\mathbf{X}</math> और आउटपुट | \mathbf{X}</math> और आउटपुट सदिश <math>\boldsymbol y </math> है | ||

है | |||

: <math> | : <math> | ||

\boldsymbol{\hat\beta} = (\mathbf{X} ^\mathbf{T}\mathbf{X})^{-1}\mathbf{X}^{\mathbf{T}}\boldsymbol y . | \boldsymbol{\hat\beta} = (\mathbf{X} ^\mathbf{T}\mathbf{X})^{-1}\mathbf{X}^{\mathbf{T}}\boldsymbol y . | ||

</math> | </math> | ||

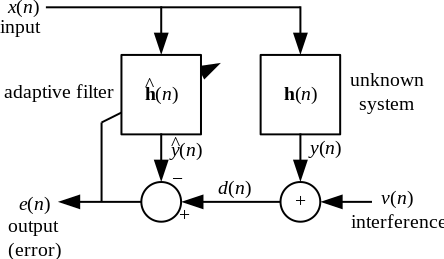

एफआईआर | एफआईआर न्यूनतम माध्य वर्ग फ़िल्टर वीनर फ़िल्टर से संबंधित है, किंतु पूर्व के त्रुटि मानदंड को न्यूनतम करना क्रॉस-सहसंबंध या ऑटो-सहसंबंध पर निर्भर नहीं करता है। इसका समाधान वीनर फ़िल्टर समाधान में परिवर्तित हो जाता है। अधिकांश रैखिक अनुकूली फ़िल्टरिंग समस्याओं को उपरोक्त ब्लॉक आरेख का उपयोग करके तैयार किया जा सकता है। अर्थात्, एक अज्ञात प्रणाली <math>\mathbf{h}(n)</math> की पहचान की जानी है और अनुकूली फ़िल्टर <math>\hat{\mathbf{h}}(n)</math> को यथासंभव <math>\mathbf{h}(n)</math> के समीप बनाने के लिए इसे अनुकूलित करने का प्रयास करता है। केवल अवलोकन योग्य संकेतों <math>x(n)</math>, <math>d(n)</math> और <math>e(n)</math> का उपयोग करते समय; किंतु <math>y(n)</math>, <math>v(n)</math>और <math>h(n)</math>सीधे देखने योग्य नहीं हैं। इसका समाधान वीनर फ़िल्टर से निकटता से संबंधित है। | ||

उपरोक्त ब्लॉक आरेख का उपयोग करके | |||

=== प्रतीकों की परिभाषा === | === प्रतीकों की परिभाषा === | ||

:<math>n</math> वर्तमान इनपुट नमूने की संख्या है | :<math>n</math> वर्तमान इनपुट नमूने की संख्या है | ||

:<math>p</math> फिल्टर | :<math>p</math> फिल्टर टेप्स की संख्या है | ||

:<math> \{\cdot\}^H </math> ([[हर्मिटियन ट्रांसपोज़]] या [[ संयुग्मी स्थानान्तरण |संयुग्मी स्थानान्तरण]] ) | :<math> \{\cdot\}^H </math> ([[हर्मिटियन ट्रांसपोज़]] या [[ संयुग्मी स्थानान्तरण |संयुग्मी स्थानान्तरण]] ) | ||

:<math> | :<math> | ||

| Line 29: | Line 27: | ||

:<math> | :<math> | ||

d(n) = y(n) + \nu(n) | d(n) = y(n) + \nu(n) | ||

</math> :<math>\hat{\mathbf{h}}(n)</math> अनुमानित फ़िल्टर; | </math> :<math>\hat{\mathbf{h}}(n)</math> अनुमानित फ़िल्टर; {{math|''n''}} नमूनों के बाद फ़िल्टर गुणांक के अनुमान के रूप में व्याख्या करें | ||

:<math> | :<math> | ||

e(n) = d(n) - \hat{y}(n) = d(n) - \hat{\mathbf{h}}^H(n) \cdot \mathbf{x}(n) | e(n) = d(n) - \hat{y}(n) = d(n) - \hat{\mathbf{h}}^H(n) \cdot \mathbf{x}(n) | ||

| Line 36: | Line 34: | ||

== विचार == | == विचार == | ||

एलएमएस फिल्टर के पीछे मूल विचार इष्टतम फिल्टर वजन | एलएमएस फिल्टर के पीछे मूल विचार इष्टतम फिल्टर वजन <math>(R^{-1}P)</math> तक पहुंचना है, फिल्टर वजन को इष्टतम फिल्टर वजन में परिवर्तित करने के विधि से अपडेट करके यह ग्रेडिएंट डिसेंट एल्गोरिदम पर आधारित है। एल्गोरिथ्म छोटे वजन (अधिकत्तर स्थिति में शून्य) मानकर प्रारंभ होता है और, प्रत्येक चरण पर, माध्य वर्ग त्रुटि के ग्रेडिएंट को खोजकर वजन अपडेट किया जाता है। अर्थात्, यदि एमएसई-ग्रेडिएंट सकारात्मक है, तो इसका अर्थ है कि यदि उसी वजन का उपयोग आगे की पुनरावृत्तियों के लिए किया जाता है, तो त्रुटि सकारात्मक रूप से बढ़ती रहेगी, जिसका अर्थ है कि हमें वजन कम करने की आवश्यकता है। उसी तरह, यदि ग्रेडिएंट नकारात्मक है, तो हमें वज़न बढ़ाने की ज़रूरत है। वजन अद्यतन समीकरण है | ||

: <math> W_{n+1} = W_n - \mu\nabla \varepsilon [n], </math> | : <math> W_{n+1} = W_n - \mu\nabla \varepsilon [n], </math> | ||

जहाँ <math> \varepsilon </math> माध्य-वर्ग त्रुटि का प्रतिनिधित्व करता है और <math> \mu </math> अभिसरण गुणांक है। | |||

ऋणात्मक चिह्न दर्शाता है कि हम | ऋणात्मक चिह्न दर्शाता है कि हम फ़िल्टर भार <math> W_i </math> को खोजने के लिए त्रुटि <math> \varepsilon </math> के ढलान से नीचे जाते हैं, जो त्रुटि को कम करता है। | ||

फिल्टर भार के | फिल्टर भार के कार्य के रूप में माध्य-स्क्वायर त्रुटि द्विघात कार्य है जिसका अर्थ है कि इसका केवल चरम है, जो औसत-वर्ग त्रुटि को कम करता है, जो कि इष्टतम वजन है। एलएमएस इस प्रकार, माध्य-स्क्वायर-त्रुटि या फ़िल्टर भार वक्र के आरोही/अवरोही द्वारा इस इष्टतम भार की ओर पहुंचता है। | ||

== व्युत्पत्ति == | == व्युत्पत्ति == | ||

एलएमएस फिल्टर के पीछे का विचार फ़िल्टर वजन | एलएमएस फिल्टर के पीछे का विचार फ़िल्टर वजन <math> \hat{\mathbf{h}}(n)</math> खोजने के लिए सबसे तेज गिरावट का उपयोग करना है जो हानि कार्य को कम करता है। हम व्यय फलन को इस रूप में परिभाषित करते हुए प्रारंभ करते हैं | ||

हम | |||

:<math> C(n) = E\left\{|e(n)|^{2}\right\}</math> | :<math> C(n) = E\left\{|e(n)|^{2}\right\}</math> | ||

जहां <math>e(n)</math> वर्तमान नमूने n में त्रुटि है और <math>E\{\cdot\}</math>अपेक्षित मान को दर्शाता है। | |||

यह | यह व्यय फलन (<math>C(n)</math>) माध्य वर्ग त्रुटि है, और इसे एलएमएस द्वारा न्यूनतम किया जाता है। यहीं पर एलएमएस को इसका नाम मिला जिसे स्टीपेस्ट डिसेंट को प्रयुक्त करने का अर्थ फ़िल्टर गुणांक (वजन) सदिश की व्यक्तिगत प्रविष्टियों के संबंध में आंशिक डेरिवेटिव लेना है | ||

:<math> | :<math> | ||

\nabla_{\hat{\mathbf{h}}^H} C(n) = \nabla_{\hat{\mathbf{h}}^H} E\left\{e(n) \, e^{*}(n)\right\}=2E\left\{\nabla_{\hat{\mathbf{h}}^H} ( e(n)) \, e^{*}(n) \right\} | \nabla_{\hat{\mathbf{h}}^H} C(n) = \nabla_{\hat{\mathbf{h}}^H} E\left\{e(n) \, e^{*}(n)\right\}=2E\left\{\nabla_{\hat{\mathbf{h}}^H} ( e(n)) \, e^{*}(n) \right\} | ||

</math> | </math> | ||

जहाँ <math>\nabla</math> [[ ग्रेडियेंट |ग्रेडियेंट]] ऑपरेटर है | |||

:<math> | :<math> | ||

\nabla_{\hat{\mathbf{h}}^H} (e(n))= \nabla_{\hat{\mathbf{h}}^H} \left(d(n) - \hat{\mathbf{h}}^H \cdot \mathbf{x}(n)\right)=-\mathbf{x}(n) | \nabla_{\hat{\mathbf{h}}^H} (e(n))= \nabla_{\hat{\mathbf{h}}^H} \left(d(n) - \hat{\mathbf{h}}^H \cdot \mathbf{x}(n)\right)=-\mathbf{x}(n) | ||

| Line 63: | Line 60: | ||

\nabla C(n) = -2E\left\{\mathbf{x}(n) \, e^{*}(n)\right\} | \nabla C(n) = -2E\left\{\mathbf{x}(n) \, e^{*}(n)\right\} | ||

</math> | </math> | ||

अब | अब <math>\nabla C(n)</math> एक वेक्टर है जो व्यय फलन की सबसे तीव्र चढ़ाई की ओर संकेत करता है। न्यूनतम व्यय फलन ज्ञात करने के लिए हमें <math>\nabla C(n)</math> की विपरीत दिशा में एक कदम उठाना होगा। उसे गणितीय शब्दों में व्यक्त करना अहि | ||

:<math>\hat{\mathbf{h}}(n+1)=\hat{\mathbf{h}}(n)-\frac{\mu}{2} \nabla C(n)=\hat{\mathbf{h}}(n)+\mu \, E\left\{\mathbf{x}(n) \, e^{*}(n)\right\}</math> | :<math>\hat{\mathbf{h}}(n+1)=\hat{\mathbf{h}}(n)-\frac{\mu}{2} \nabla C(n)=\hat{\mathbf{h}}(n)+\mu \, E\left\{\mathbf{x}(n) \, e^{*}(n)\right\}</math> | ||

जहां <math>\frac{\mu}{2}</math>चरण आकार (अनुकूलन स्थिरांक) है। इसका अर्थ है कि हमें एक अनुक्रमिक अद्यतन एल्गोरिदम मिला है जो व्यय फलन को कम करता है। दुर्भाग्य से, यह एल्गोरिथम तब तक साकार नहीं हो सकता जब तक हम <math>E\left\{\mathbf{x}(n) \, e^{*}(n)\right\} </math> नहीं जानते है । | |||

सामान्यतः ऊपर की अपेक्षा की गणना नहीं की जाती है। इसके अतिरिक्त, एलएमएस को ऑनलाइन (प्रत्येक नए नमूने के प्राप्त होने के पश्चात् अद्यतन करना) वातावरण में चलाने के लिए, हम उस अपेक्षा के तात्कालिक अनुमान का उपयोग करते हैं। नीचे देखें। | |||

== सरलीकरण == | == सरलीकरण == | ||

| Line 73: | Line 70: | ||

:<math> | :<math> | ||

\hat{E}\left\{\mathbf{x}(n) \, e^{*}(n)\right\}=\frac{1}{N}\sum_{i=0}^{N-1}\mathbf{x}(n-i) \, e^{*}(n-i) | \hat{E}\left\{\mathbf{x}(n) \, e^{*}(n)\right\}=\frac{1}{N}\sum_{i=0}^{N-1}\mathbf{x}(n-i) \, e^{*}(n-i) | ||

</math> | </math> | ||

:जहाँ <math>N</math> उस अनुमान के लिए हमारे द्वारा उपयोग किए जाने वाले नमूनों की संख्या को इंगित करता है। सबसे सरल स्थिति <math>N=1</math> है | |||

:<math> | :<math> | ||

\hat{E}\left\{\mathbf{x}(n) \, e^{*}(n)\right\}=\mathbf{x}(n) \, e^{*}(n) | \hat{E}\left\{\mathbf{x}(n) \, e^{*}(n)\right\}=\mathbf{x}(n) \, e^{*}(n) | ||

</math> उस साधारण | </math> | ||

:उस साधारण स्थिति के लिए अद्यतन एल्गोरिथ्म इस प्रकार है | |||

:<math>\hat{\mathbf{h}}(n+1)=\hat{\mathbf{h}}(n)+\mu \mathbf{x}(n) \, e^{*}(n)</math> | :<math>\hat{\mathbf{h}}(n+1)=\hat{\mathbf{h}}(n)+\mu \mathbf{x}(n) \, e^{*}(n)</math> | ||

:वास्तव में यह एलएमएस फिल्टर के लिए अद्यतन एल्गोरिथ्म का गठन करता है। | |||

== एलएमएस एल्गोरिथम सारांश == | == एलएमएस एल्गोरिथम सारांश == | ||

<math>p</math>वें आदेश फ़िल्टर के लिए एलएमएस एल्गोरिदम को संक्षेप में प्रस्तुत किया जा सकता है | |||

{| | {| | ||

| Parameters: || <math>p=</math> filter order | | Parameters: || <math>p=</math> filter order | ||

| Line 102: | Line 100: | ||

== माध्य में अभिसरण और स्थिरता == | == माध्य में अभिसरण और स्थिरता == | ||

चूंकि एलएमएस एल्गोरिथ्म अपेक्षाओं के सटीक मूल्यों का उपयोग नहीं करता है, वजन कभी भी पूर्ण अर्थ में इष्टतम वजन तक नहीं पहुंचेगा, किंतु माध्य में एक अभिसरण संभव है। अर्थात् वजन थोड़ी मात्रा में बदल सकता है, यह इष्टतम वजन के बारे में बदलता है। चूँकि यदि भिन्नता जिसके साथ वजन बदलता है, बड़ा है, तो माध्य में अभिसरण अस्पष्ट होगा यदि चरण-आकार <math> \mu </math> का मान ठीक से नहीं चुना गया है तो यह समस्या उत्पन्न हो सकती है। | |||

यदि <math> \mu </math> को बड़ा चुना जाता है, तो भार में परिवर्तन की मात्रा ग्रेडिएंट अनुमान पर बहुत अधिक निर्भर करती है, और इसलिए वज़न बड़े मान से बदल सकता है जिससे ग्रेडिएंट जो पहले पल में नकारात्मक था वह अब सकारात्मक हो सकता है। और दूसरे क्षण में, नकारात्मक ढाल के कारण वजन विपरीत दिशा में बड़ी मात्रा में बदल सकता है और इस प्रकार इष्टतम वजन के बारे में एक बड़े बदलाव के साथ दोलन करता रहेगा। दूसरी ओर यदि <math> \mu </math> को बहुत छोटा चुना जाता है, तो इष्टतम वजन तक पहुंचने का समय बहुत बड़ा होगा। | |||

इस प्रकार, ऊपरी सीमा पर <math> \mu </math> की आवश्यकता होती है जो दिया जाता है | इस प्रकार, ऊपरी सीमा पर <math> \mu </math> की आवश्यकता होती है जो दिया जाता है | ||

<math> 0<\mu<\frac{2}{\lambda_{\mathrm{max}}} </math> | <math> 0<\mu<\frac{2}{\lambda_{\mathrm{max}}} </math> | ||

जहाँ <math>\lambda_{\max}</math> स्वतःसंबंध आव्यूह का सबसे बड़ा आइगेनवैल्यू है <math> {\mathbf{R}} = E\{{\mathbf{x}}(n){\mathbf{x}^H}(n)\}</math>. यदि यह स्थिति पूरी नहीं होती है, तो एल्गोरिथम अस्थिर हो जाता है और <math>\hat{h}(n)</math> विचलन। | |||

अधिकतम अभिसरण गति तब प्राप्त होती है जब | अधिकतम अभिसरण गति तब प्राप्त होती है जब | ||

| Line 114: | Line 112: | ||

\mu=\frac{2}{\lambda_{\mathrm{max}}+\lambda_{\mathrm{min}}}, | \mu=\frac{2}{\lambda_{\mathrm{max}}+\lambda_{\mathrm{min}}}, | ||

</math> | </math> | ||

जहां <math>\lambda_{\min}</math>, <math>{\mathbf{R}}</math> का सबसे छोटा आइगेनवैल्यू है। यह देखते हुए कि <math>\mu</math> इस इष्टतम से कम या इसके समान है अभिसरण गति <math>\lambda_{\min}</math> द्वारा निर्धारित की जाती है बड़े मूल्य के साथ तेजी से अभिसरण प्राप्त होता है। इसका अर्थ यह है कि तेजी से अभिसरण तब प्राप्त किया जा सकता है जब <math>\lambda_{\max}</math> , <math>\lambda_{\min}</math> के समीप हो, जिससे , अधिकतम प्राप्त करने योग्य अभिसरण गति <math>{\mathbf{R}}</math> के आइगेनवैल्यू प्रसार पर निर्भर करती है। | |||

एक सफेद | एक सफेद ध्वनि सिग्नल में ऑटोसहसंबंध आव्यूह होता है <math>{\mathbf{R}}=\sigma^2 {\mathbf{I}}</math> जहां <math>\sigma^2</math> सिग्नल का विचरण होता है। इस मामले में सभी आइगेनवैल्यू समान हैं, और सभी संभावित आव्यूहों पर आइगेनवैल्यू का प्रसार न्यूनतम है। इस परिणाम की सामान्य व्याख्या यह है कि एलएमएस सफेद इनपुट संकेतों के लिए तेजी से और रंगीन इनपुट संकेतों के लिए धीरे-धीरे परिवर्तित होता है, जैसे कम-पास या उच्च-पास विशेषताओं वाली प्रक्रियाएं है । | ||

यह ध्यान रखना महत्वपूर्ण है कि उपरोक्त ऊपरी सीमा पर <math>\mu</math> केवल माध्य में स्थिरता को | यह ध्यान रखना महत्वपूर्ण है कि उपरोक्त ऊपरी सीमा पर <math>\mu</math> केवल माध्य में स्थिरता को प्रयुक्त करता है, किंतु के गुणांक <math>\hat{h}(n)</math> अभी भी असीम रूप से बड़ा हो सकता है, अथार्त गुणांकों का विचलन अभी भी संभव है। अधिक व्यावहारिक सीमा है | ||

:<math> | :<math> | ||

0<\mu<\frac{2}{\mathrm{tr}\left[{\mathbf{R}}\right]}, | 0<\mu<\frac{2}{\mathrm{tr}\left[{\mathbf{R}}\right]}, | ||

</math> | </math> | ||

जहां <math>\mathrm{tr}[{\mathbf{R}}]</math> , <math>{\mathbf{R}}</math> के ट्रेस को दर्शाता है। यह सीमा आश्वासन देती है कि <math>\hat{h}(n)</math> के गुणांक अलग-अलग नहीं होते हैं (व्यवहार में,<math>\mu</math> का मान इस ऊपरी सीमा के समीप नहीं चुना जाना चाहिए, क्योंकि इसमें किए गए अनुमानों और धारणाओं के कारण यह कुछ सीमा तक आशावादी है। बाउंड की व्युत्पत्ति)। | |||

== सामान्यीकृत कम से कम वर्ग फ़िल्टर (एनएलएमएस) == | == सामान्यीकृत कम से कम वर्ग फ़िल्टर (एनएलएमएस) == | ||

शुद्ध एलएमएस | "शुद्ध" एलएमएस एल्गोरिदम का मुख्य दोष यह है कि यह अपने इनपुट <math>x(n)</math> की स्केलिंग के प्रति संवेदनशील है। इससे सीखने की दर <math>\mu</math> चुनना बहुत कठिन (यदि असंभव नहीं) हो जाता है जो एल्गोरिदम की स्थिरता की आश्वासन देता है (हेकिन 2002)। सामान्यीकृत न्यूनतम माध्य वर्ग फ़िल्टर (एनएलएमएस) एलएमएस एल्गोरिथ्म का एक प्रकार है जो इनपुट की शक्ति के साथ सामान्यीकरण करके इस समस्या को हल करता है। एनएलएमएस एल्गोरिदम को संक्षेप में प्रस्तुत किया जा सकता है: | ||

{| | {| | ||

| Line 149: | Line 145: | ||

=== इष्टतम सीखने की दर === | === इष्टतम सीखने की दर === | ||

यह दिखाया जा सकता है कि | यह दिखाया जा सकता है कि यदि कोई हस्तक्षेप नहीं है (<math>v(n)=0</math>), तो एनएलएमएस एल्गोरिथम के लिए इष्टतम सीखने की दर है | ||

:<math>\mu_{opt}=1</math> और इनपुट | :<math>\mu_{opt}=1</math> | ||

:और इनपुट <math>x(n)</math> और वास्तविक (अज्ञात) आवेग प्रतिक्रिया <math>\mathbf{h}(n)</math> से स्वतंत्र है। सामान्य स्थिति में हस्तक्षेप <math>v(n) \ne 0</math> के साथ सीखने की इष्टतम दर है | |||

:<math> | :<math> | ||

\mu_{opt}=\frac{E\left[\left|y(n)-\hat{y}(n)\right|^2\right]}{E\left[|e(n)|^2\right]} | \mu_{opt}=\frac{E\left[\left|y(n)-\hat{y}(n)\right|^2\right]}{E\left[|e(n)|^2\right]} | ||

</math> | </math> | ||

ऊपर दिए गए परिणाम मानते हैं कि सिग्नल <math>v(n)</math> और <math>x(n)</math> दूसरे से असंबद्ध हैं, जो | ऊपर दिए गए परिणाम मानते हैं कि सिग्नल <math>v(n)</math> और <math>x(n)</math> दूसरे से असंबद्ध हैं, जो सामान्यतः व्यवहार में होता है। | ||

=== प्रमाण === | === प्रमाण === | ||

मान लीजिए कि फ़िल्टर गलत संरेखण को <math>\Lambda(n) = \left| \mathbf{h}(n) - \hat{\mathbf{h}}(n) \right|^2</math>के रूप में परिभाषित किया गया है हम अगले नमूने के लिए अपेक्षित मिसलिग्न्मेंट इस प्रकार प्राप्त कर सकते हैं: | |||

: <math> E\left[ \Lambda(n+1) \right] = E\left[ \left| \hat{\mathbf{h}}(n) + \frac{\mu\,e^{*}(n)\mathbf{x}(n)}{\mathbf{x}^H(n)\mathbf{x}(n)} - \mathbf{h}(n) \right|^2 \right]</math> | : <math> E\left[ \Lambda(n+1) \right] = E\left[ \left| \hat{\mathbf{h}}(n) + \frac{\mu\,e^{*}(n)\mathbf{x}(n)}{\mathbf{x}^H(n)\mathbf{x}(n)} - \mathbf{h}(n) \right|^2 \right]</math> | ||

: <math> E\left[ \Lambda(n+1) \right] = E\left[ \left| \hat{\mathbf{h}}(n) + \frac{\mu\, \left( v^*(n)+y^*(n)-\hat{y}^*(n) \right) \mathbf{x}(n)}{\mathbf{x}^H(n)\mathbf{x}(n)} - \mathbf{h}(n) \right|^2 \right]</math> | : <math> E\left[ \Lambda(n+1) \right] = E\left[ \left| \hat{\mathbf{h}}(n) + \frac{\mu\, \left( v^*(n)+y^*(n)-\hat{y}^*(n) \right) \mathbf{x}(n)}{\mathbf{x}^H(n)\mathbf{x}(n)} - \mathbf{h}(n) \right|^2 \right]</math> | ||

| Line 173: | Line 170: | ||

== यह भी देखें == | == यह भी देखें == | ||

* [[रिकर्सिव कम से कम वर्ग]] | * [[रिकर्सिव कम से कम वर्ग]] | ||

* | * एलएमएस फ़िल्टर से संबंधित सांख्यिकीय तकनीकों के लिए कम से कम वर्ग देखें। | ||

* [[वीनर और एलएमएस के बीच समानताएं]] | * [[वीनर और एलएमएस के बीच समानताएं]] | ||

* [[बहुविलंब ब्लॉक आवृत्ति डोमेन अनुकूली फ़िल्टर]] | * [[बहुविलंब ब्लॉक आवृत्ति डोमेन अनुकूली फ़िल्टर]] | ||

| Line 191: | Line 188: | ||

== बाहरी संबंध == | == बाहरी संबंध == | ||

* [http://www.antenna-theory.com/arrays/weights/lms.php | * [http://www.antenna-theory.com/arrays/weights/lms.php एलएमएस Algorithm in Adaptive Antenna Arrays] www.antenna-theory.com | ||

* [http://www.advsolned.com/example_ale_nc.html | * [http://www.advsolned.com/example_ale_nc.html एलएमएस Noise cancellation demo] www.advsolned.com | ||

[[Category: अंकीय संकेत प्रक्रिया]] [[Category: फ़िल्टर सिद्धांत]] [[Category: सांख्यिकीय एल्गोरिदम]] | [[Category: अंकीय संकेत प्रक्रिया]] [[Category: फ़िल्टर सिद्धांत]] [[Category: सांख्यिकीय एल्गोरिदम]] | ||

Revision as of 12:51, 25 June 2023

कम से कम औसत वर्ग (एलएमएस) एल्गोरिदम अनुकूली फ़िल्टर का वर्ग है जो फ़िल्टर गुणांक खोजकर वांछित फ़िल्टर की प्रतिलिपि करने के लिए उपयोग किया जाता है जो त्रुटि संकेत (वांछित और वास्तविक संकेत के बीच अंतर) के कम से कम औसत वर्ग का उत्पादन करने से संबंधित है। यह स्टोकास्टिक ग्रेडियेंट डिसेंट विधि है जिसमें फ़िल्टर केवल वर्तमान समय में त्रुटि के आधार पर अनुकूलित किया जाता है। इसका आविष्कार 1960 में स्टैनफोर्ड विश्वविद्यालय के प्रोफेसर बर्नार्ड विड्रो और उनके पहले पीएच.डी. छात्र, टेड हॉफ द्वारा किया गया था।

समस्या निर्माण

विनीज़ फ़िल्टर से संबंध

सिग्नल प्रोसेसिंग डोमेन को छोड़कर कारण वीनर फ़िल्टर की प्राप्ति कम से कम वर्गों के अनुमान के समाधान की तरह दिखती है। इनपुट आव्यूह के लिए कम से कम वर्ग समाधान और आउटपुट सदिश है

एफआईआर न्यूनतम माध्य वर्ग फ़िल्टर वीनर फ़िल्टर से संबंधित है, किंतु पूर्व के त्रुटि मानदंड को न्यूनतम करना क्रॉस-सहसंबंध या ऑटो-सहसंबंध पर निर्भर नहीं करता है। इसका समाधान वीनर फ़िल्टर समाधान में परिवर्तित हो जाता है। अधिकांश रैखिक अनुकूली फ़िल्टरिंग समस्याओं को उपरोक्त ब्लॉक आरेख का उपयोग करके तैयार किया जा सकता है। अर्थात्, एक अज्ञात प्रणाली की पहचान की जानी है और अनुकूली फ़िल्टर को यथासंभव के समीप बनाने के लिए इसे अनुकूलित करने का प्रयास करता है। केवल अवलोकन योग्य संकेतों , और का उपयोग करते समय; किंतु , और सीधे देखने योग्य नहीं हैं। इसका समाधान वीनर फ़िल्टर से निकटता से संबंधित है।

प्रतीकों की परिभाषा

- वर्तमान इनपुट नमूने की संख्या है

- फिल्टर टेप्स की संख्या है

- (हर्मिटियन ट्रांसपोज़ या संयुग्मी स्थानान्तरण )

- :

- : अनुमानित फ़िल्टर; n नमूनों के बाद फ़िल्टर गुणांक के अनुमान के रूप में व्याख्या करें

विचार

एलएमएस फिल्टर के पीछे मूल विचार इष्टतम फिल्टर वजन तक पहुंचना है, फिल्टर वजन को इष्टतम फिल्टर वजन में परिवर्तित करने के विधि से अपडेट करके यह ग्रेडिएंट डिसेंट एल्गोरिदम पर आधारित है। एल्गोरिथ्म छोटे वजन (अधिकत्तर स्थिति में शून्य) मानकर प्रारंभ होता है और, प्रत्येक चरण पर, माध्य वर्ग त्रुटि के ग्रेडिएंट को खोजकर वजन अपडेट किया जाता है। अर्थात्, यदि एमएसई-ग्रेडिएंट सकारात्मक है, तो इसका अर्थ है कि यदि उसी वजन का उपयोग आगे की पुनरावृत्तियों के लिए किया जाता है, तो त्रुटि सकारात्मक रूप से बढ़ती रहेगी, जिसका अर्थ है कि हमें वजन कम करने की आवश्यकता है। उसी तरह, यदि ग्रेडिएंट नकारात्मक है, तो हमें वज़न बढ़ाने की ज़रूरत है। वजन अद्यतन समीकरण है

जहाँ माध्य-वर्ग त्रुटि का प्रतिनिधित्व करता है और अभिसरण गुणांक है।

ऋणात्मक चिह्न दर्शाता है कि हम फ़िल्टर भार को खोजने के लिए त्रुटि के ढलान से नीचे जाते हैं, जो त्रुटि को कम करता है।

फिल्टर भार के कार्य के रूप में माध्य-स्क्वायर त्रुटि द्विघात कार्य है जिसका अर्थ है कि इसका केवल चरम है, जो औसत-वर्ग त्रुटि को कम करता है, जो कि इष्टतम वजन है। एलएमएस इस प्रकार, माध्य-स्क्वायर-त्रुटि या फ़िल्टर भार वक्र के आरोही/अवरोही द्वारा इस इष्टतम भार की ओर पहुंचता है।

व्युत्पत्ति

एलएमएस फिल्टर के पीछे का विचार फ़िल्टर वजन खोजने के लिए सबसे तेज गिरावट का उपयोग करना है जो हानि कार्य को कम करता है। हम व्यय फलन को इस रूप में परिभाषित करते हुए प्रारंभ करते हैं

जहां वर्तमान नमूने n में त्रुटि है और अपेक्षित मान को दर्शाता है।

यह व्यय फलन () माध्य वर्ग त्रुटि है, और इसे एलएमएस द्वारा न्यूनतम किया जाता है। यहीं पर एलएमएस को इसका नाम मिला जिसे स्टीपेस्ट डिसेंट को प्रयुक्त करने का अर्थ फ़िल्टर गुणांक (वजन) सदिश की व्यक्तिगत प्रविष्टियों के संबंध में आंशिक डेरिवेटिव लेना है

जहाँ ग्रेडियेंट ऑपरेटर है

अब एक वेक्टर है जो व्यय फलन की सबसे तीव्र चढ़ाई की ओर संकेत करता है। न्यूनतम व्यय फलन ज्ञात करने के लिए हमें की विपरीत दिशा में एक कदम उठाना होगा। उसे गणितीय शब्दों में व्यक्त करना अहि

जहां चरण आकार (अनुकूलन स्थिरांक) है। इसका अर्थ है कि हमें एक अनुक्रमिक अद्यतन एल्गोरिदम मिला है जो व्यय फलन को कम करता है। दुर्भाग्य से, यह एल्गोरिथम तब तक साकार नहीं हो सकता जब तक हम नहीं जानते है ।

सामान्यतः ऊपर की अपेक्षा की गणना नहीं की जाती है। इसके अतिरिक्त, एलएमएस को ऑनलाइन (प्रत्येक नए नमूने के प्राप्त होने के पश्चात् अद्यतन करना) वातावरण में चलाने के लिए, हम उस अपेक्षा के तात्कालिक अनुमान का उपयोग करते हैं। नीचे देखें।

सरलीकरण

अधिकांश प्रणालियों के लिए अपेक्षा कार्य अनुमानित होना चाहिए। यह निम्नलिखित निष्पक्ष अनुमानक के साथ किया जा सकता है

- जहाँ उस अनुमान के लिए हमारे द्वारा उपयोग किए जाने वाले नमूनों की संख्या को इंगित करता है। सबसे सरल स्थिति है

- उस साधारण स्थिति के लिए अद्यतन एल्गोरिथ्म इस प्रकार है

- वास्तव में यह एलएमएस फिल्टर के लिए अद्यतन एल्गोरिथ्म का गठन करता है।

एलएमएस एल्गोरिथम सारांश

वें आदेश फ़िल्टर के लिए एलएमएस एल्गोरिदम को संक्षेप में प्रस्तुत किया जा सकता है

| Parameters: | filter order |

| step size | |

| Initialisation: | |

| Computation: | For |

|

| |

माध्य में अभिसरण और स्थिरता

चूंकि एलएमएस एल्गोरिथ्म अपेक्षाओं के सटीक मूल्यों का उपयोग नहीं करता है, वजन कभी भी पूर्ण अर्थ में इष्टतम वजन तक नहीं पहुंचेगा, किंतु माध्य में एक अभिसरण संभव है। अर्थात् वजन थोड़ी मात्रा में बदल सकता है, यह इष्टतम वजन के बारे में बदलता है। चूँकि यदि भिन्नता जिसके साथ वजन बदलता है, बड़ा है, तो माध्य में अभिसरण अस्पष्ट होगा यदि चरण-आकार का मान ठीक से नहीं चुना गया है तो यह समस्या उत्पन्न हो सकती है।

यदि को बड़ा चुना जाता है, तो भार में परिवर्तन की मात्रा ग्रेडिएंट अनुमान पर बहुत अधिक निर्भर करती है, और इसलिए वज़न बड़े मान से बदल सकता है जिससे ग्रेडिएंट जो पहले पल में नकारात्मक था वह अब सकारात्मक हो सकता है। और दूसरे क्षण में, नकारात्मक ढाल के कारण वजन विपरीत दिशा में बड़ी मात्रा में बदल सकता है और इस प्रकार इष्टतम वजन के बारे में एक बड़े बदलाव के साथ दोलन करता रहेगा। दूसरी ओर यदि को बहुत छोटा चुना जाता है, तो इष्टतम वजन तक पहुंचने का समय बहुत बड़ा होगा।

इस प्रकार, ऊपरी सीमा पर की आवश्यकता होती है जो दिया जाता है

जहाँ स्वतःसंबंध आव्यूह का सबसे बड़ा आइगेनवैल्यू है . यदि यह स्थिति पूरी नहीं होती है, तो एल्गोरिथम अस्थिर हो जाता है और विचलन।

अधिकतम अभिसरण गति तब प्राप्त होती है जब

जहां , का सबसे छोटा आइगेनवैल्यू है। यह देखते हुए कि इस इष्टतम से कम या इसके समान है अभिसरण गति द्वारा निर्धारित की जाती है बड़े मूल्य के साथ तेजी से अभिसरण प्राप्त होता है। इसका अर्थ यह है कि तेजी से अभिसरण तब प्राप्त किया जा सकता है जब , के समीप हो, जिससे , अधिकतम प्राप्त करने योग्य अभिसरण गति के आइगेनवैल्यू प्रसार पर निर्भर करती है।

एक सफेद ध्वनि सिग्नल में ऑटोसहसंबंध आव्यूह होता है जहां सिग्नल का विचरण होता है। इस मामले में सभी आइगेनवैल्यू समान हैं, और सभी संभावित आव्यूहों पर आइगेनवैल्यू का प्रसार न्यूनतम है। इस परिणाम की सामान्य व्याख्या यह है कि एलएमएस सफेद इनपुट संकेतों के लिए तेजी से और रंगीन इनपुट संकेतों के लिए धीरे-धीरे परिवर्तित होता है, जैसे कम-पास या उच्च-पास विशेषताओं वाली प्रक्रियाएं है ।

यह ध्यान रखना महत्वपूर्ण है कि उपरोक्त ऊपरी सीमा पर केवल माध्य में स्थिरता को प्रयुक्त करता है, किंतु के गुणांक अभी भी असीम रूप से बड़ा हो सकता है, अथार्त गुणांकों का विचलन अभी भी संभव है। अधिक व्यावहारिक सीमा है

जहां , के ट्रेस को दर्शाता है। यह सीमा आश्वासन देती है कि के गुणांक अलग-अलग नहीं होते हैं (व्यवहार में, का मान इस ऊपरी सीमा के समीप नहीं चुना जाना चाहिए, क्योंकि इसमें किए गए अनुमानों और धारणाओं के कारण यह कुछ सीमा तक आशावादी है। बाउंड की व्युत्पत्ति)।

सामान्यीकृत कम से कम वर्ग फ़िल्टर (एनएलएमएस)

"शुद्ध" एलएमएस एल्गोरिदम का मुख्य दोष यह है कि यह अपने इनपुट की स्केलिंग के प्रति संवेदनशील है। इससे सीखने की दर चुनना बहुत कठिन (यदि असंभव नहीं) हो जाता है जो एल्गोरिदम की स्थिरता की आश्वासन देता है (हेकिन 2002)। सामान्यीकृत न्यूनतम माध्य वर्ग फ़िल्टर (एनएलएमएस) एलएमएस एल्गोरिथ्म का एक प्रकार है जो इनपुट की शक्ति के साथ सामान्यीकरण करके इस समस्या को हल करता है। एनएलएमएस एल्गोरिदम को संक्षेप में प्रस्तुत किया जा सकता है:

| Parameters: | filter order |

| step size | |

| Initialization: | |

| Computation: | For |

|

| |

इष्टतम सीखने की दर

यह दिखाया जा सकता है कि यदि कोई हस्तक्षेप नहीं है (), तो एनएलएमएस एल्गोरिथम के लिए इष्टतम सीखने की दर है

- और इनपुट और वास्तविक (अज्ञात) आवेग प्रतिक्रिया से स्वतंत्र है। सामान्य स्थिति में हस्तक्षेप के साथ सीखने की इष्टतम दर है

ऊपर दिए गए परिणाम मानते हैं कि सिग्नल और दूसरे से असंबद्ध हैं, जो सामान्यतः व्यवहार में होता है।

प्रमाण

मान लीजिए कि फ़िल्टर गलत संरेखण को के रूप में परिभाषित किया गया है हम अगले नमूने के लिए अपेक्षित मिसलिग्न्मेंट इस प्रकार प्राप्त कर सकते हैं:

होने देना और

स्वतंत्रता मानकर, हमारे पास:

इष्टतम सीखने की दर पाई जाती है , जिससे होता है:

यह भी देखें

- रिकर्सिव कम से कम वर्ग

- एलएमएस फ़िल्टर से संबंधित सांख्यिकीय तकनीकों के लिए कम से कम वर्ग देखें।

- वीनर और एलएमएस के बीच समानताएं

- बहुविलंब ब्लॉक आवृत्ति डोमेन अनुकूली फ़िल्टर

- शून्य-बल तुल्यकारक

- कर्नेल अनुकूली फ़िल्टर

- मिलान फ़िल्टर

- वीनर फिल्टर

संदर्भ

- Monson H. Hayes: Statistical Digital Signal Processing and Modeling, Wiley, 1996, ISBN 0-471-59431-8

- Simon Haykin: Adaptive Filter Theory, Prentice Hall, 2002, ISBN 0-13-048434-2

- Simon S. Haykin, Bernard Widrow (Editor): Least-Mean-Square Adaptive Filters, Wiley, 2003, ISBN 0-471-21570-8

- Bernard Widrow, Samuel D. Stearns: Adaptive Signal Processing, Prentice Hall, 1985, ISBN 0-13-004029-0

- Weifeng Liu, Jose Principe and Simon Haykin: Kernel Adaptive Filtering: A Comprehensive Introduction, John Wiley, 2010, ISBN 0-470-44753-2

- Paulo S.R. Diniz: Adaptive Filtering: Algorithms and Practical Implementation, Kluwer Academic Publishers, 1997, ISBN 0-7923-9912-9

बाहरी संबंध

- एलएमएस Algorithm in Adaptive Antenna Arrays www.antenna-theory.com

- एलएमएस Noise cancellation demo www.advsolned.com