अपर्यवेक्षित अधिगम: Difference between revisions

No edit summary |

No edit summary |

||

| Line 18: | Line 18: | ||

=== ऊर्जा === | === ऊर्जा === | ||

एक ऊर्जा क्रिया किसी जालक्रम की सक्रियण स्थिति का एक स्थूल माप है। बोल्ट्ज़मैन यंत्रों में, यह लागत क्रिया की भूमिका निभाता है। भौतिकी के साथ यह सादृश्य कण गति | एक ऊर्जा क्रिया किसी जालक्रम की सक्रियण स्थिति का एक स्थूल माप है। बोल्ट्ज़मैन यंत्रों में, यह लागत क्रिया की भूमिका निभाता है। भौतिकी के साथ यह सादृश्य कण गति <math>p \propto e^{-E/kT}</math>की सूक्ष्म संभावनाओं से गैस की स्थूल ऊर्जा के लुडविग बोल्ट्जमैन के विश्लेषण से प्रेरित है, जहां k बोल्ट्जमैन स्थिरांक है और T तापमान है। आरबीएम जालक्रम में संबंध <math> p = e^{-E} / Z </math> है,<ref name="Hinton2010" />जहां <math>p</math> और <math>E</math> प्रत्येक संभावित सक्रियण प्रतिरुप में भिन्न और <math>\textstyle{Z = \sum_{\scriptscriptstyle{\text{All Patterns}}} e^{-E(\text{pattern})}}</math> होता है। अधिक स्पष्ट करने के लिए, <math>p(a) = e^{-E(a)} / Z</math>, जहां <math>a</math> सभी न्यूरॉन (दृश्यमान और गुप्त) का एक सक्रियण प्रतिरुप है। इसलिए, प्रारंभिक तन्त्रिका जालक्रम का नाम बोल्ट्ज़मैन यंत्र है। पॉल स्मोलेंस्की कॉल <math>-E\,</math> समानता है। एक जालक्रम कम ऊर्जा चाहता है जो उच्च समानता है। | ||

=== जालक्रम === | === जालक्रम === | ||

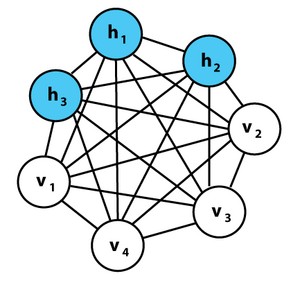

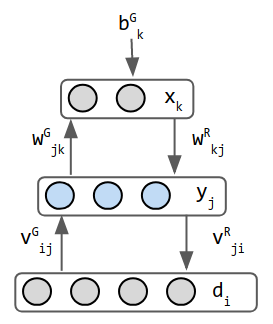

यह तालिका विभिन्न गैर-पर्यवेक्षित जालक्रमों के संयोजन आरेख | यह तालिका विभिन्न गैर-पर्यवेक्षित जालक्रमों के संयोजन आरेख दर्शाती है, जिनका विवरण जालक्रम की तुलना अनुभाग में दिया जाएगा। वृत्त न्यूरॉन हैं और उनके मध्य के किनारे संयोजन भार हैं। जैसे-जैसे जालक्रम प्रारुप परिवर्तित करता है, नई क्षमताओं को सक्षम करने के लिए सुविधाएँ जोड़ी जाती हैं या अधिगम को तीव्र बनाने के लिए हटा दी जाती हैं। उदाहरण के लिए, प्रबल बहिर्गत की अनुमति देने के लिए न्यूरॉन नियतात्मक (हॉपफील्ड) और स्टोकेस्टिक (बोल्ट्ज़मैन) के मध्य परिवर्तित होते हैं, अधिगम में तीव्रता लाने के लिए एक परत (RBM) के भीतर भार हटा दिया जाता है, या संयोजन को असममित (हेल्महोल्ट्ज़) बनने की अनुमति दी जाती है। | ||

{| class="wikitable" | {| class="wikitable" | ||

| Line 27: | Line 27: | ||

! हॉपफ़ील्ड !! बोल्ट्ज़मैन !! आरबीएम !! स्टैक्ड बोल्ट्ज़मैन | ! हॉपफ़ील्ड !! बोल्ट्ज़मैन !! आरबीएम !! स्टैक्ड बोल्ट्ज़मैन | ||

|- | |- | ||

| [[File:Hopfield-net-vector.svg |thumb|एकल स्व- | | [[File:Hopfield-net-vector.svg |thumb|एकल स्व-संबंधित परत के साथ लोहे में चुंबकीय कार्यक्षेत्र पर आधारित एक जालक्रम है। इसका उपयोग पता योग्य सामग्री स्मृति के रूप में किया जा सकता है।]] | ||

|| [[File:Boltzmannexamplev1.png |thumb|जालक्रम को 2 परतों ( | || [[File:Boltzmannexamplev1.png |thumb|जालक्रम को 2 परतों (गुप्त बनाम दृश्यमान) में विभाजित किया गया है, परन्तु फिर भी सममित 2-पंथ भार का उपयोग किया जाता है। बोल्ट्ज़मैन के ऊष्मागतिकी के बाद, व्यक्तिगत संभावनाएं स्थूल ऊर्जा की उत्पत्ति करती हैं।]] | ||

|| [[File:Restricted Boltzmann machine.svg|thumb|प्रतिबंधित बोल्ट्ज़मैन यंत्र। यह एक बोल्ट्ज़मैन यंत्र है जहां विश्लेषण को सुव्यवस्थित बनाने के लिए एक परत के भीतर पार्श्व संयोजन निषिद्ध है।]] | || [[File:Restricted Boltzmann machine.svg|thumb|प्रतिबंधित बोल्ट्ज़मैन यंत्र। यह एक बोल्ट्ज़मैन यंत्र है जहां विश्लेषण को सुव्यवस्थित बनाने के लिए एक परत के भीतर पार्श्व संयोजन निषिद्ध है।]] | ||

|| [[File:Stacked-boltzmann.png|thumb| इस जालक्रम में छिपी हुई विशेषताओं के पदानुक्रम को एनकोड करने के लिए कई आरबीएम हैं। एक आरबीएम को प्रशिक्षित करने के बाद, एक और नीली छिपी हुई परत (बाएं आरबीएम देखें) जोड़ी जाती है, और शीर्ष 2 परतों को लाल और नीले आरबीएम के रूप में प्रशिक्षित किया जाता है। इस प्रकार आरबीएम की मध्य परतें छिपी या दृश्यमान के रूप में कार्य करती हैं, यह इस बात पर निर्भर करता है कि यह किस प्रशिक्षण चरण में है।]] | || [[File:Stacked-boltzmann.png|thumb| इस जालक्रम में छिपी हुई विशेषताओं के पदानुक्रम को एनकोड करने के लिए कई आरबीएम हैं। एक आरबीएम को प्रशिक्षित करने के बाद, एक और नीली छिपी हुई परत (बाएं आरबीएम देखें) जोड़ी जाती है, और शीर्ष 2 परतों को लाल और नीले आरबीएम के रूप में प्रशिक्षित किया जाता है। इस प्रकार आरबीएम की मध्य परतें छिपी या दृश्यमान के रूप में कार्य करती हैं, यह इस बात पर निर्भर करता है कि यह किस प्रशिक्षण चरण में है।]] | ||

| Line 37: | Line 37: | ||

! Helmholtz !! Autoencoder !! VAE | ! Helmholtz !! Autoencoder !! VAE | ||

|- | |- | ||

|| [[File:Helmholtz Machine.png |thumb|स्टैक्ड बोल्ट्ज़मैन | || [[File:Helmholtz Machine.png |thumb|स्टैक्ड बोल्ट्ज़मैन यंत्रों के द्विदिश सममित संयोजन के बजाय, हमारे पास लूप बनाने के लिए अलग-अलग एक-तरफ़ा संयोजन हैं। यह पीढ़ी और भेदभाव दोनों करता है।]] | ||

|| [[File:Autoencoder_schema.png |thumb|एक फ़ीड फ़ॉरवर्ड नेटवर्क जिसका लक्ष्य अपने इनपुट जगत का एक अच्छा मध्य परत प्रतिनिधित्व खोजना है। यह नेटवर्क नियतिवादी है, इसलिए यह अपने उत्तराधिकारी VAE जितना मजबूत नहीं है।]] | || [[File:Autoencoder_schema.png |thumb|एक फ़ीड फ़ॉरवर्ड नेटवर्क जिसका लक्ष्य अपने इनपुट जगत का एक अच्छा मध्य परत प्रतिनिधित्व खोजना है। यह नेटवर्क नियतिवादी है, इसलिए यह अपने उत्तराधिकारी VAE जितना मजबूत नहीं है।]] | ||

|| [[File:VAE blocks.png |thumb|ऑटोएन्कोडर पर वैरिएशनल अनुमान लागू करता है। मध्य परत गॉसियन वितरण के लिए साधनों और भिन्नताओं का एक सेट है। स्टोकेस्टिक प्रकृति नियतात्मक ऑटोएनकोडर की तुलना में अधिक मजबूत कल्पना की अनुमति देती है। ]] | || [[File:VAE blocks.png |thumb|ऑटोएन्कोडर पर वैरिएशनल अनुमान लागू करता है। मध्य परत गॉसियन वितरण के लिए साधनों और भिन्नताओं का एक सेट है। स्टोकेस्टिक प्रकृति नियतात्मक ऑटोएनकोडर की तुलना में अधिक मजबूत कल्पना की अनुमति देती है। ]] | ||

| Line 112: | Line 112: | ||

| शीर्ष परत अप्रत्यक्ष, सममित है। अन्य परतें 2-तरफ़ा, असममित हैं। || 3-परतें: असममित भार। 2 नेटवर्क को मिलाकर 1 बनाया गया। || <!--AE-->3-परतें। इनपुट को एक परत माना जाता है, भले ही इसमें कोई इनबाउंड वेट न हो। एनएलपी के लिए आवर्ती परतें। दृष्टि के लिए फीडफॉरवर्ड कनवल्शन। इनपुट और आउटपुट में समान न्यूरॉन गिनती होती है। || 3-परतें: इनपुट, एनकोडर, वितरण नमूना डिकोडर। नमूना को एक परत नहीं माना जाता है (e) | | शीर्ष परत अप्रत्यक्ष, सममित है। अन्य परतें 2-तरफ़ा, असममित हैं। || 3-परतें: असममित भार। 2 नेटवर्क को मिलाकर 1 बनाया गया। || <!--AE-->3-परतें। इनपुट को एक परत माना जाता है, भले ही इसमें कोई इनबाउंड वेट न हो। एनएलपी के लिए आवर्ती परतें। दृष्टि के लिए फीडफॉरवर्ड कनवल्शन। इनपुट और आउटपुट में समान न्यूरॉन गिनती होती है। || 3-परतें: इनपुट, एनकोडर, वितरण नमूना डिकोडर। नमूना को एक परत नहीं माना जाता है (e) | ||

|- | |- | ||

| ''' | | '''अनुमान एवं ऊर्जा''' || ऊर्जा गिब्स संभाव्यता माप द्वारा दी गई है:<math>E = -\frac12\sum_{i,j}{w_{ij}{s_i}{s_j}}+\sum_i{\theta_i}{s_i}</math>|| ← समान || ← समान ||<!-- -->|| केएल विचलन को कम करें || अनुमान केवल फीड-फॉरवर्ड है। पिछले यूएल नेटवर्क आगे और पीछे चलते थे || त्रुटि न्यूनतम करें = पुनर्निर्माण त्रुटि - केएलडी | ||

|- | |- | ||

| ''' | | '''प्रशिक्षण''' || Δw<sub>ij</sub> = s<sub>i</sub>*s<sub>j</sub>, के लिए +1/-1 न्यूरॉन || Δw<sub>ij</sub> = e*(p<sub>ij</sub> - p'<sub>ij</sub>), यह केएलडी को न्यूनतम करने से प्राप्त हुआ है। | ||

|| Δw<sub>ij</sub> = e*( < v<sub>i</sub> h<sub>j</sub> ><sub>data</sub> - < v<sub>i</sub> h<sub>j</sub> ><sub>equilibrium</sub> ) | e = अधिगम दर, | ||

p' = अनुमानित और | |||

p = वास्तविक वितरण हैं। | |||

|| Δw<sub>ij</sub> = e*( < v<sub>i</sub> h<sub>j</sub> ><sub>data</sub> - < v<sub>i</sub> h<sub>j</sub> ><sub>equilibrium</sub> ), यह गिब्स प्रतिदर्शी के साथ विरोधाभासी विचलन का एक रूप है। "<>" अपेक्षाएं हैं। || ← के समान एक समय में 1-परत को प्रशिक्षित करें। 3- खंड पारित के साथ अनुमानित संतुलन स्थिति हैं। कोई पूर्व संचरण नहीं हैं। || जागो-नींद 2 चरण का प्रशिक्षण हैं। || <!--AE-->पुनर्निर्माण त्रुटि को वापस प्रचारित करें || बैकप्रॉप के लिए छिपी हुई स्थिति को दोबारा मापें | |||

|- | |- | ||

| ''' | | '''प्रबलता''' || भौतिक प्रणालियों के सदृश है इसलिए यह उनके समीकरणों को प्राप्त करता है। | ||

| ← के समान गुप्त न्यूरॉन्स बाहरी दुनिया के आंतरिक प्रतिनिधित्व के रूप में कार्य करते हैं। || बोल्ट्ज़मैन यंत्रों की तुलना में तीव्र और अधिक व्यावहारिक प्रशिक्षण योजना हैं। || तीव्रता से शृंखला सुविधाओं की श्रेणीबद्ध परत देता है। || हल्का शारीरिक. सूचना सिद्धांत और सांख्यिकीय यांत्रिकी के साथ विश्लेषण योग्य हैं। ||<!--AE-->|| <!--VAE--> | |||

|- | |- | ||

| ''' | | '''दुर्बलता''' || <!--hopfield--> || पार्श्व संयोजन के कारण प्रशिक्षित करना कठिन है। || <!--RBM-->संतुलन के लिए बहुत अधिक पुनरावृत्तियों की आवश्यकता होती है। || पूर्णांक और वास्तविक-मूल्यवान न्यूरॉन्स अधिक जटिल हैं। ||<!--Helmholtz-->|| <!--AE--> || <!--VAE--> | ||

|} | |} | ||

हेब्बियन अधिगम, एआरटी, एसओएम<br> | हेब्बियन अधिगम, एआरटी, एसओएम<br> | ||

तन्त्रिका जाल के अध्ययन में अपर्यवेक्षित शिक्षण का शास्त्रीय उदाहरण [[डोनाल्ड हेब्ब]] का सिद्धांत है, अर्थात, न्यूरॉन्स जो एक साथ तार से आग लगाते हैं।<ref name="Buhmann" />हेब्बियन सीखने में, किसी त्रुटि के बावजूद संयोजन को प्रबल किया जाता है, परन्तु यह विशेष रूप से दो न्यूरॉन्स के मध्य कार्रवाई क्षमता के मध्य संयोग का एक कार्य है।<ref name="Comesana" />एक समान संस्करण जो सिनैप्टिक भार को संशोधित करता है वह एक्शन पोटेंशिअल ([[ स्पाइक-टाइमिंग-निर्भर प्लास्टिसिटी ]] या एसटीडीपी) के मध्य के समय को ध्यान में रखता है। हेब्बियन अधिगम को प्रतिरुप पहचान और अनुभवात्मक शिक्षा जैसे संज्ञानात्मक कार्यों की एक श्रृंखला को रेखांकित करने के लिए परिकल्पित किया गया है। | तन्त्रिका जाल के अध्ययन में अपर्यवेक्षित शिक्षण का शास्त्रीय उदाहरण [[डोनाल्ड हेब्ब]] का सिद्धांत है, अर्थात, न्यूरॉन्स जो एक साथ तार से आग लगाते हैं।<ref name="Buhmann" />हेब्बियन सीखने में, किसी त्रुटि के बावजूद संयोजन को प्रबल किया जाता है, परन्तु यह विशेष रूप से दो न्यूरॉन्स के मध्य कार्रवाई क्षमता के मध्य संयोग का एक कार्य है।<ref name="Comesana" />एक समान संस्करण जो सिनैप्टिक भार को संशोधित करता है वह एक्शन पोटेंशिअल ([[ स्पाइक-टाइमिंग-निर्भर प्लास्टिसिटी ]] या एसटीडीपी) के मध्य के समय को ध्यान में रखता है। हेब्बियन अधिगम को प्रतिरुप पहचान और अनुभवात्मक शिक्षा जैसे संज्ञानात्मक कार्यों की एक श्रृंखला को रेखांकित करने के लिए परिकल्पित किया गया है। | ||

[[कृत्रिम तंत्रिका नेटवर्क|कृत्रिम तन्त्रिका जाल]] प्रतिरूप के मध्य, [[स्व-संगठित मानचित्र]] (एसओएम) और [[अनुकूली अनुनाद सिद्धांत]] (ART) का उपयोग सामान्यतः बिना पर्यवेक्षित शिक्षण कलन विधि में किया जाता है। एसओएम एक स्थलाकृतिक संगठन है जिसमें मानचित्र में आस-पास के स्थान समान गुणों वाले निविष्ट का प्रतिनिधित्व करते हैं। एआरटी प्रतिरूप समस्या के आकार के साथ समूहों की संख्या को अलग-अलग करने की अनुमति देता है और उपयोगकर्ता को सतर्कता मापदंड नामक उपयोगकर्ता-परिभाषित स्थिरांक के माध्यम से समान | [[कृत्रिम तंत्रिका नेटवर्क|कृत्रिम तन्त्रिका जाल]] प्रतिरूप के मध्य, [[स्व-संगठित मानचित्र]] (एसओएम) और [[अनुकूली अनुनाद सिद्धांत]] (ART) का उपयोग सामान्यतः बिना पर्यवेक्षित शिक्षण कलन विधि में किया जाता है। एसओएम एक स्थलाकृतिक संगठन है जिसमें मानचित्र में आस-पास के स्थान समान गुणों वाले निविष्ट का प्रतिनिधित्व करते हैं। एआरटी प्रतिरूप समस्या के आकार के साथ समूहों की संख्या को अलग-अलग करने की अनुमति देता है और उपयोगकर्ता को सतर्कता मापदंड नामक उपयोगकर्ता-परिभाषित स्थिरांक के माध्यम से समान गुच्छ के सदस्यों के मध्य समानता की डिग्री को नियंत्रित करने देता है। एआरटी जालक्रम का उपयोग कई प्रतिरुप पहचान कार्यों के लिए किया जाता है, जैसे [[स्वचालित लक्ष्य पहचान]] और भूकंपीय सिग्नल प्रोसेसिंग।<ref name="Carpenter" /> | ||

== संभाव्य विधियाँ == | == संभाव्य विधियाँ == | ||

बिना पर्यवेक्षित शिक्षण में उपयोग की जाने वाली दो मुख्य विधियाँ | बिना पर्यवेक्षित शिक्षण में उपयोग की जाने वाली दो मुख्य विधियाँ प्रमुख घटक और [[क्लस्टर विश्लेषण|गुच्छ विश्लेषण]] हैं। गुच्छ विश्लेषण के उपयोग के बिना पर्यवेक्षित शिक्षण में कलन विधि संबंधों को बहिर्वेशित करने के लिए साझा विशेषताओं वाले आंकड़े समुच्चय को समूह या खंड में करने के लिए किया जाता है।<ref name="tds-ul" />गुच्छ विश्लेषण [[ यंत्र अधिगम |यंत्र अधिगम]] की एक शाखा है जो उन आंकड़ों को समूहित करती है जिसे लेबल, या वर्गीकृत नहीं किया गया है। पुनर्निवेशन पर प्रतिक्रिया देने के बजाय, गुच्छ विश्लेषण प्रदत्त में समानताओं की पहचान करता है और प्रदत्त के प्रत्येक नए टुकड़े में ऐसी समानताओं की उपस्थिति या अनुपस्थिति के आधार पर प्रतिक्रिया करता है। यह दृष्टिकोण उन असंगत प्रदत्त बिंदुओं का पता लगाने में सहायता करता है जो किसी भी समूह में उपयुक्त नहीं होते हैं। | ||

अपर्यवेक्षित शिक्षण का एक केंद्रीय अनुप्रयोग सांख्यिकी में [[घनत्व अनुमान]] के क्षेत्र में है,<ref name="JordanBishop2004" />हालाँकि बिना पर्यवेक्षित शिक्षण में प्रदत्त सुविधाओं का सारांश और व्याख्या करने वाले कई अन्य डोमेन सम्मिलित हैं। इसकी तुलना पर्यवेक्षित शिक्षण से यह कहकर की जा सकती है कि जबकि पर्यवेक्षित शिक्षण का उद्देश्य निविष्ट प्रदत्त के लेबल पर [[सशर्त संभाव्यता वितरण]] का अनुमान लगाना है; अप्रशिक्षित शिक्षण का उद्देश्य एक प्राथमिक संभाव्यता वितरण का अनुमान लगाना है। | अपर्यवेक्षित शिक्षण का एक केंद्रीय अनुप्रयोग सांख्यिकी में [[घनत्व अनुमान]] के क्षेत्र में है,<ref name="JordanBishop2004" />हालाँकि बिना पर्यवेक्षित शिक्षण में प्रदत्त सुविधाओं का सारांश और व्याख्या करने वाले कई अन्य डोमेन सम्मिलित हैं। इसकी तुलना पर्यवेक्षित शिक्षण से यह कहकर की जा सकती है कि जबकि पर्यवेक्षित शिक्षण का उद्देश्य निविष्ट प्रदत्त के लेबल पर [[सशर्त संभाव्यता वितरण]] का अनुमान लगाना है; अप्रशिक्षित शिक्षण का उद्देश्य एक प्राथमिक संभाव्यता वितरण का अनुमान लगाना है। | ||

=== दृष्टिकोण === | === दृष्टिकोण === | ||

बिना पर्यवेक्षित शिक्षण में उपयोग किए जाने वाले कुछ सबसे | बिना पर्यवेक्षित शिक्षण में उपयोग किए जाने वाले कुछ सबसे सामान्य कलन विधियों में: (1) गुच्छन, (2) विसंगति संसूचन, (3) अव्यक्त चर प्रतिरूप अधिगम के लिए दृष्टिकोण सम्मिलित हैं। प्रत्येक दृष्टिकोण निम्नानुसार कई विधियों का उपयोग करता है: | ||

* [[डेटा क्लस्टरिंग| | * [[डेटा क्लस्टरिंग|गुच्छन]] विधियों में: [[पदानुक्रमित क्लस्टरिंग|पदानुक्रमित गुच्छन]],<ref name="Hastie" />k-माध्य,<ref name="tds-kmeans" />[[मिश्रण मॉडल|मिश्रण प्रतिरूप]], [[डीबीएससीएएन]], और [[प्रकाशिकी एल्गोरिथ्म|प्रकाशिकी कलन विधि]] सम्मिलित हैं। | ||

* विसंगति का पता लगाने के तरीकों में | * विसंगति का पता लगाने के तरीकों में: स्थानीय बाह्य कारक और [[अलगाव वन|वियोजन फॉरस्ट]] सम्मिलित हैं। | ||

* [[अव्यक्त चर मॉडल|अव्यक्त चर प्रतिरूप]] सीखने के लिए दृष्टिकोण जैसे कि अपेक्षा-अधिकतमकरण कलन विधि ( | * [[अव्यक्त चर मॉडल|अव्यक्त चर प्रतिरूप]] सीखने के लिए दृष्टिकोण जैसे कि अपेक्षा-अधिकतमकरण कलन विधि (EM), [[क्षणों की विधि (सांख्यिकी)|आघूर्णो की विधि]] और [[ब्लाइंड सिग्नल पृथक्करण|अंध संकेत पृथक्करण]] प्रविधि (प्रमुख घटक विश्लेषण, [[स्वतंत्र घटक विश्लेषण|स्वतंत्र घटक विश्लेषण,]] [[गैर-नकारात्मक मैट्रिक्स गुणनखंडन|गैर-ऋणात्मक आव्यूह गुणनखंडन]], अद्वितीय मान अपघटन) हैं। | ||

=== | === आघूर्णो की विधि === | ||

बिना पर्यवेक्षित शिक्षण के लिए सांख्यिकीय दृष्टिकोणों में से एक | बिना पर्यवेक्षित शिक्षण के लिए सांख्यिकीय दृष्टिकोणों में से एक आघूर्ण विधि है। आघूर्णो की विधि में, प्रतिरूप में अज्ञात मापदंड (रुचि के) एक या अधिक यादृच्छिक चर के आघूर्णो से संबंधित होते हैं और इस प्रकार, इन अज्ञात मापदंडों का अनुमान आघूर्णो को देखते हुए लगाया जा सकता है। आघूर्णो का अनुमान सामान्यतः अनुभवजन्य रूप से प्रतिरूपों से लगाया जाता है। मूल आघूर्ण प्रथम और द्वितीय क्रम के आघूर्ण हैं। एक यादृच्छिक सदिश के लिए, पहले क्रम का आघूर्ण माध्य सदिश है और दूसरे क्रम का आघूर्ण सहप्रसरण आव्यूह है (जब माध्य शून्य है)। उच्च क्रम के आघूर्णो को सामान्यतः [[टेंसर|प्रदिश]] का उपयोग करके दर्शाया जाता है जो कि बहु-आयामी सरणियों के रूप में उच्च क्रम के [[सहप्रसरण आव्यूह|आव्यूह]] का सामान्यीकरण है। | ||

विशेष रूप से, अव्यक्त चर प्रतिरूप के मापदंडों को सीखने में | विशेष रूप से, अव्यक्त चर प्रतिरूप के मापदंडों को सीखने में आघूर्णो की विधि को प्रभावी दर्शाया गया है। अव्यक्त चर प्रतिरूप सांख्यिकीय प्रतिरूप हैं जहां देखे गए चर के अतिरिक्त, अव्यक्त चर का एक समुच्चय भी उपस्थित होता है जो नहीं देखा जाता है। [[अर्थ|यंत्र]] अधिगम में अव्यक्त चर प्रतिरूप का एक अत्यधिक व्यावहारिक उदाहरण [[विषय मॉडलिंग]] है जो प्रपत्र के विषय (अव्यक्त चर) के आधार पर प्रपत्र में शब्द (अवलोकित चर) उत्पन्न करने के लिए एक सांख्यिकीय प्रतिरूप है। विषय मॉडलिंग में, प्रपत्र का विषय परिवर्तित करने पर प्रपत्र में शब्द विभिन्न सांख्यिकीय मापदंडों के अनुसार उत्पन्न होते हैं। यह दर्शाया गया है कि आघूर्णो की विधि (टेंसर अपघटन प्रविधि) कुछ मान्यताओं के अंतर्गत अव्यक्त चर प्रतिरूप के एक बड़े वर्ग के मापदंडों को निरंतर पुनर्प्राप्त करती है।<ref name="TensorLVMs" /> | ||

अपेक्षा-अधिकतमकरण कलन विधि (EM) भी अव्यक्त चर प्रतिरूप अधिगम के लिए सबसे व्यावहारिक तरीकों में से एक है। हालाँकि, यह स्थानीय ऑप्टिमा में फंस सकता है और यह प्रत्याभूति नहीं है कि कलन विधि प्रतिरूप के वास्तविक अज्ञात मापदंडों में परिवर्तित हो जाएगा। इसके विपरीत, आघूर्णो की विधि के लिए, कुछ प्रतिबंधों के अंतर्गत वैश्विक अभिसरण की प्रत्याभूति दी जाती है। | |||

== यह भी देखें == | == यह भी देखें == | ||

* [[स्वचालित मशीन लर्निंग|स्वचालित यंत्र अधिगम]] | * [[स्वचालित मशीन लर्निंग|स्वचालित यंत्र अधिगम]] | ||

* | * गुच्छ विश्लेषण | ||

* | * विसंगति संसूचन | ||

* अपेक्षा-अधिकतमीकरण कलन विधि | * अपेक्षा-अधिकतमीकरण कलन विधि | ||

* [[जनरेटिव स्थलाकृतिक मानचित्र]] | * [[जनरेटिव स्थलाकृतिक मानचित्र|प्रजनक स्थलाकृतिक मानचित्र]] | ||

* [[मेटा-लर्निंग (कंप्यूटर विज्ञान)|मेटा-अधिगम ( | * [[मेटा-लर्निंग (कंप्यूटर विज्ञान)|मेटा-अधिगम (अभिकलित्र विज्ञान)]] | ||

* [[बहुभिन्नरूपी विश्लेषण]] | * [[बहुभिन्नरूपी विश्लेषण]] | ||

* [[रेडियल आधार फ़ंक्शन नेटवर्क| | * [[रेडियल आधार फ़ंक्शन नेटवर्क|त्रिज्यीय आधार क्रिया जालक्रम]] | ||

* [[कमजोर पर्यवेक्षण]] | * [[कमजोर पर्यवेक्षण|दुर्बल पर्यवेक्षण]] | ||

== संदर्भ == | == संदर्भ == | ||

Revision as of 09:11, 2 July 2023

| Part of a series on |

| Machine learning and data mining |

|---|

|

अपर्यवेक्षित अधिगम उन कलन विधियों को संदर्भित करता है जो बिना लेबल वाले प्रदत्त से प्रतिरुप सीखते हैं।

पर्यवेक्षित शिक्षण के विपरीत, जहां प्रतिरूप निविष्ट को लक्ष्य बहिर्गत में मानचित्र करना सीखते हैं (उदाहरण के लिए "बिल्ली" या "मछली" के रूप में लेबल की गई छवियां), बिना पर्यवेक्षित तरीके निविष्ट प्रदत्तों का संक्षिप्त प्रतिनिधित्व सीखते हैं, जिसका उपयोग प्रदत्त अन्वेषण या विश्लेषण या नए प्रदत्त को उत्पन्न करने के लिए किया जा सकता है। पर्यवेक्षण वर्णक्रम में अन्य स्तर सुदृढीकरण शिक्षण हैं जहां यंत्र को मार्गदर्शन के रूप में केवल एक "प्रदर्शन प्राप्तांक" दिया जाता है और अर्ध-पर्यवेक्षित शिक्षण जहां प्रशिक्षण प्रदत्त का केवल एक भाग लेबल किया जाता है।

तन्त्रिका जालक्रम

कार्य बनाम विधियाँ

तन्त्रिका जालक्रम कार्यों को प्रायः भेदभावपूर्ण (मान्यता) या उत्पादक (कल्पना) के रूप में वर्गीकृत किया जाता है। परन्तु सदैव नहीं, भेदभावपूर्ण कार्यों में पर्यवेक्षित तरीकों का उपयोग किया जाता है और प्रजनक कार्यों में बिना पर्यवेक्षित तरीकों का उपयोग किया जाता है (वेन आरेख देखें); हालाँकि, पृथक्करण अस्पष्ट है। उदाहरण के लिए, वस्तु पहचान पर्यवेक्षित शिक्षण को बढ़ावा देती है परन्तु बिना पर्यवेक्षित शिक्षण भी वस्तुओं को समूहों में विभाजित कर सकता है। इसके अतिरिक्त, जैसे-जैसे प्रगति आगे बढ़ती है, कुछ कार्य दोनों तरीकों का उपयोग करते हैं और कुछ कार्य एक से दूसरे की ओर प्रदोलन करते हैं। उदाहरण के लिए, छवि पहचान का प्रारंभ अत्यधिक पर्यवेक्षित के साथ हुआ, परन्तु बिना पर्यवेक्षित पूर्व-प्रशिक्षण को नियोजित करने से यह संकरित हो गई, और फिर निर्गम पात, परिशोधक और अनुकूली अधिगम दर के आगमन के साथ पुनः पर्यवेक्षण की ओर बढ़ गई।

प्रशिक्षण

अधिगम चरण के पर्यन्त, एक अप्रशिक्षित जालक्रम दिए गए प्रदत्त की नकल करने का प्रयास करता है और स्वयं को सही करने के लिए अपने नकल किए गए बहिर्गत में त्रुटि का उपयोग करता है (अर्थात अपने भार और पूर्वाग्रहों को ठीक करता है)। कभी-कभी त्रुटि को गलत बहिर्गत होने की कम संभावना के रूप में व्यक्त किया जाता है, या इसे जालक्रम में अस्थिर उच्च ऊर्जा स्थिति के रूप में व्यक्त किया जा सकता है।

पर्यवेक्षित तरीकों के पश्चप्रचार के प्रमुख उपयोग के विपरीत, अपर्यवेक्षित अधिगम अन्य तरीकों को भी नियोजित करता है जिनमें, होपफील्ड अधिगम नियम, बोल्ट्जमैन अधिगम नियम, विरोधाभासी विचलन, वेक स्लीप, भिन्नात्मक अनुमान, अधिकतम संभावना, अधिकतम पोस्टीरियोरी, गिब्स प्रतिदर्शी और पश्चप्रचार, पुनर्निर्माण त्रुटियाँ या गुप्त स्थिति का पुनर्मूल्यांकन सम्मिलित हैं। अधिक विवरण के लिए नीचे दी गई तालिका देखें।

ऊर्जा

एक ऊर्जा क्रिया किसी जालक्रम की सक्रियण स्थिति का एक स्थूल माप है। बोल्ट्ज़मैन यंत्रों में, यह लागत क्रिया की भूमिका निभाता है। भौतिकी के साथ यह सादृश्य कण गति की सूक्ष्म संभावनाओं से गैस की स्थूल ऊर्जा के लुडविग बोल्ट्जमैन के विश्लेषण से प्रेरित है, जहां k बोल्ट्जमैन स्थिरांक है और T तापमान है। आरबीएम जालक्रम में संबंध है,[1]जहां और प्रत्येक संभावित सक्रियण प्रतिरुप में भिन्न और होता है। अधिक स्पष्ट करने के लिए, , जहां सभी न्यूरॉन (दृश्यमान और गुप्त) का एक सक्रियण प्रतिरुप है। इसलिए, प्रारंभिक तन्त्रिका जालक्रम का नाम बोल्ट्ज़मैन यंत्र है। पॉल स्मोलेंस्की कॉल समानता है। एक जालक्रम कम ऊर्जा चाहता है जो उच्च समानता है।

जालक्रम

यह तालिका विभिन्न गैर-पर्यवेक्षित जालक्रमों के संयोजन आरेख दर्शाती है, जिनका विवरण जालक्रम की तुलना अनुभाग में दिया जाएगा। वृत्त न्यूरॉन हैं और उनके मध्य के किनारे संयोजन भार हैं। जैसे-जैसे जालक्रम प्रारुप परिवर्तित करता है, नई क्षमताओं को सक्षम करने के लिए सुविधाएँ जोड़ी जाती हैं या अधिगम को तीव्र बनाने के लिए हटा दी जाती हैं। उदाहरण के लिए, प्रबल बहिर्गत की अनुमति देने के लिए न्यूरॉन नियतात्मक (हॉपफील्ड) और स्टोकेस्टिक (बोल्ट्ज़मैन) के मध्य परिवर्तित होते हैं, अधिगम में तीव्रता लाने के लिए एक परत (RBM) के भीतर भार हटा दिया जाता है, या संयोजन को असममित (हेल्महोल्ट्ज़) बनने की अनुमति दी जाती है।

| Helmholtz | Autoencoder | VAE |

|---|---|---|

लोगों के नाम वाले जालक्रम में से केवल होपफ़ील्ड ने सीधे तन्त्रिका जाल के साथ काम किया। बोल्ट्ज़मैन और हेल्महोल्ट्ज़ कृत्रिम तन्त्रिका जाल से पहले आए थे, परन्तु भौतिकी और शरीर विज्ञान में उनके काम ने इस्तेमाल की जाने वाली विश्लेषणात्मक विधियों को प्रेरित किया।

इतिहास

| 1969 | मिन्स्की और पैपर्ट द्वारा परसेप्ट्रॉन दिखाता है कि छिपी हुई परतों के बिना एक परसेप्ट्रॉन एक्सओआर पर विफल रहता है |

| 1970s | (अनुमानित तिथियां) पहली एआई सर्दी |

| 1974 | अनुभूति के लिए डब्ल्यूए लिटिल द्वारा प्रस्तावित आइसिंग चुंबकीय प्रतिरूप |

| 1980 | फुकुशिमा ने नियोकॉग्निट्रॉन की शुरुआत की, जिसे बाद में कन्वोल्यूशन न्यूरल नेटवर्क कहा गया। इसका उपयोग अधिकतर एसएल में किया जाता है, लेकिन यहां इसका उल्लेख आवश्यक है। |

| 1982 | आइसिंग वेरिएंट हॉपफील्ड नेट को जॉन हॉपफील्ड द्वारा सीएएम और क्लासिफायर के रूप में वर्णित किया गया है। |

| 1983 | शेरिंगटन और किर्कपैट्रिक के 1975 के काम के बाद हिंटन और सेजनोव्स्की द्वारा वर्णित संभाव्य न्यूरॉन्स के साथ आइसिंग वैरिएंट बोल्टज़मैन मशीन। |

| 1986 | पॉल स्मोलेंस्की ने हार्मनी थ्योरी प्रकाशित की, जो व्यावहारिक रूप से समान बोल्ट्ज़मान ऊर्जा फ़ंक्शन वाला एक आरबीएम है। स्मोलेंस्की ने कोई व्यावहारिक प्रशिक्षण योजना नहीं दी। हिंटन ने 2000 के दशक के मध्य में किया था |

| 1995 | श्मिटथुबर ने भाषाओं के लिए एलएसटीएम भाषाओं के लिए न्यूरॉन |

| 1995 | दयान और हिंटन ने हेल्महोल्ट्ज़ मशीन पेश की |

| 1995-2005 | (अनुमानित तिथियां) दूसरा एआई सर्दी |

| 2013 | किंग्मा, रेज़ेंडे, और कंपनी। घटकों के रूप में तंत्रिका जाल के साथ, बायेसियन ग्राफ़िकल संभाव्यता नेटवर्क के रूप में वेरिएशनल ऑटोएन्कोडर्स को पेश किया गया। |

विशिष्ट जालक्रम

यहां, हम चुनिंदा जालक्रम की कुछ विशेषताओं पर प्रकाश डालते हैं। प्रत्येक का विवरण नीचे तुलना तालिका में दिया गया है।

- हॉपफील्ड नेटवर्क

- लौहचुम्बकत्व ने हॉपफील्ड नेटवर्क को प्रेरित किया। एक न्यूरॉन ऊपर और नीचे द्विआधारी चुंबकीय क्षणों के साथ एक लौह डोमेन से मेल खाता है, और तंत्रिका कनेक्शन एक दूसरे पर डोमेन के प्रभाव से मेल खाते हैं। सममित कनेक्शन वैश्विक ऊर्जा निर्माण को सक्षम बनाते हैं। अनुमान के दौरान नेटवर्क मानक सक्रियण चरण फ़ंक्शन का उपयोग करके प्रत्येक स्थिति को अपडेट करता है। सममित भार और सही ऊर्जा कार्य एक स्थिर सक्रियण पैटर्न के अभिसरण की गारंटी देते हैं। असममित भार का विश्लेषण करना कठिन है। हॉपफील्ड नेट का उपयोग कंटेंट एड्रेसेबल मेमोरीज़ (सीएएम) के रूप में किया जाता है।

- बोल्ट्ज़मैन मशीन

- ये स्टोकेस्टिक हॉपफील्ड नेट हैं। उनका राज्य मान इस पीडीएफ से निम्नानुसार नमूना लिया गया है: मान लीजिए कि एक बाइनरी न्यूरॉन बर्नौली संभावना पी (1) = 1/3 के साथ सक्रिय होता है और पी (0) = 2/3 के साथ आराम करता है। इसमें से एक नमूना एक समान रूप से वितरित यादृच्छिक संख्या y लेकर, और इसे उल्टे संचयी वितरण फ़ंक्शन में प्लग करके, जो इस मामले में 2/3 पर थ्रेशोल्ड चरण फ़ंक्शन है। व्युत्क्रम फलन = { 0 यदि x <= 2/3, 1 यदि x > 2/3 }

- सिग्मॉइड विश्वास नेट

- 1992 में रैडफोर्ड नील द्वारा प्रस्तुत, यह नेटवर्क संभाव्य ग्राफिकल मॉडल से लेकर तंत्रिका नेटवर्क तक के विचारों को लागू करता है। एक महत्वपूर्ण अंतर यह है कि ग्राफिकल मॉडल में नोड्स के पूर्व-निर्धारित अर्थ होते हैं, जबकि बिलीफ नेट न्यूरॉन्स की विशेषताएं प्रशिक्षण के बाद निर्धारित की जाती हैं। नेटवर्क बाइनरी स्टोकेस्टिक न्यूरॉन्स से बना एक विरल रूप से जुड़ा हुआ निर्देशित एसाइक्लिक ग्राफ है। सीखने का नियम p(X) पर अधिकतम संभावना से आता है: Δwij sj * (si - pi), जहां pi = 1 / ( 1 + e न्यूरॉन में भारित इनपुट i ). sj's पश्च वितरण के एक निष्पक्ष नमूने से सक्रियण हैं और यह जूडिया पर्ल द्वारा उठाई गई एक्सप्लेनिंग अवे समस्या के कारण समस्याग्रस्त है। वैरिएशनल बायेसियन विधियां एक सरोगेट पोस्टीरियर का उपयोग करती हैं और इस जटिलता की स्पष्ट रूप से उपेक्षा करती हैं।

- गहन विश्वास नेटवर्क

- हिंटन द्वारा प्रस्तुत, यह नेटवर्क आरबीएम और सिग्मॉइड बिलीफ नेटवर्क का एक संकर है। शीर्ष 2 परतें एक आरबीएम हैं और दूसरी परत नीचे की ओर एक सिग्मॉइड विश्वास नेटवर्क बनाती है। कोई इसे स्टैक्ड आरबीएम विधि द्वारा प्रशिक्षित करता है और फिर शीर्ष आरबीएम के नीचे पहचान भार को फेंक देता है। 2009 तक, 3-4 परतें इष्टतम गहराई प्रतीत होती हैं। [2]

- हेल्महोल्त्ज़ मशीन

- ये वेरिएशनल ऑटो एनकोडर्स के लिए प्रारंभिक प्रेरणाएँ हैं। इसके 2 नेटवर्क एक में संयुक्त हैं - फॉरवर्ड वेट पहचान को संचालित करता है और बैकवर्ड वेट कल्पना को क्रियान्वित करता है। यह संभवतः दोनों कार्य करने वाला पहला नेटवर्क है। हेल्महोल्ट्ज़ ने मशीन लर्निंग में काम नहीं किया लेकिन उन्होंने "सांख्यिकीय अनुमान इंजन के दृष्टिकोण को प्रेरित किया जिसका कार्य संवेदी इनपुट के संभावित कारणों का अनुमान लगाना है" (3)। स्टोकेस्टिक बाइनरी न्यूरॉन एक संभावना को आउटपुट करता है कि इसकी स्थिति 0 या 1 है। डेटा इनपुट को आम तौर पर एक परत नहीं माना जाता है, लेकिन हेल्महोल्ट्ज़ मशीन जेनरेशन मोड में, डेटा परत मध्य परत से इनपुट प्राप्त करती है, इस उद्देश्य के लिए अलग-अलग वजन होता है, इसलिए इसे एक परत माना जाता है. इसलिए इस नेटवर्क में 3 परतें हैं।

- वैरिएशनल ऑटोएनकोडर

- ये हेल्महोल्त्ज़ मशीनों से प्रेरित हैं और संभाव्यता नेटवर्क को तंत्रिका नेटवर्क के साथ जोड़ते हैं। एक ऑटोएन्कोडर एक 3-लेयर CAM नेटवर्क है, जहां मध्य परत को इनपुट पैटर्न का कुछ आंतरिक प्रतिनिधित्व माना जाता है। एनकोडर तंत्रिका नेटवर्क एक संभाव्यता वितरण है qφ(z given x) और डिकोडर नेटवर्क है pθ(x given z). वज़न को हेल्महोल्ट्ज़ की तरह डब्ल्यू और वी के बजाय फी और थीटा नाम दिया गया है - एक कॉस्मेटिक अंतर। यहां ये 2 नेटवर्क पूरी तरह से कनेक्ट हो सकते हैं, या किसी अन्य एनएन योजना का उपयोग कर सकते हैं।

जालक्रम की तुलना

| Hopfield | Boltzmann | RBM | Stacked RBM | Helmholtz | Autoencoder | VAE | |

|---|---|---|---|---|---|---|---|

| उपयोग एवं उल्लेखनीय | सीएएम, ट्रैवलिंग सेल्समैन समस्या | सीएएम. संयोजन की स्वतंत्रता इस नेटवर्क का विश्लेषण करना कठिन बना देती है। | प्रतिरुप मान्यता। एमएनआईएसटी अंक और भाषण में उपयोग किया जाता है। | मान्यता एवं कल्पना. बिना पर्यवेक्षित पूर्व-प्रशिक्षण और/या पर्यवेक्षित फाइन ट्यूनिंग के साथ प्रशिक्षित। | कल्पना, नकल | भाषा: रचनात्मक लेखन, अनुवाद। दृष्टि: धुंधली छवियों को बढ़ाना | यथार्थवादी डेटा उत्पन्न करें |

| न्यूरॉन | नियतात्मक द्विआधारी अवस्था. सक्रियण = { 0 (या -1) यदि x ऋणात्मक है, 1 अन्यथा } | स्टोकेस्टिक बाइनरी हॉपफील्ड न्यूरॉन | ← समान (2000 के दशक के मध्य में वास्तविक-मूल्य तक विस्तारित) | ← समान | ← समान | भाषा: एलएसटीएम. दृष्टि: स्थानीय ग्रहणशील क्षेत्र। सामान्यतः वास्तविक मूल्यवान रिले सक्रियण। | मध्य परत के न्यूरॉन्स गाऊसी के लिए माध्य और भिन्नता को कूटबद्ध करते हैं। रन मोड (अनुमान) में, मध्य परत का आउटपुट गॉसियन से नमूना मान हैं। |

| संयोजन | सममित भार के साथ 1-परत। कोई स्व-संपर्क नहीं. | 2-परतें। 1-छिपा हुआ और 1-दिखाई देने वाला। सममित भार. | ← समान

एक परत के भीतर कोई पार्श्विक संबंध नहीं। |

शीर्ष परत अप्रत्यक्ष, सममित है। अन्य परतें 2-तरफ़ा, असममित हैं। | 3-परतें: असममित भार। 2 नेटवर्क को मिलाकर 1 बनाया गया। | 3-परतें। इनपुट को एक परत माना जाता है, भले ही इसमें कोई इनबाउंड वेट न हो। एनएलपी के लिए आवर्ती परतें। दृष्टि के लिए फीडफॉरवर्ड कनवल्शन। इनपुट और आउटपुट में समान न्यूरॉन गिनती होती है। | 3-परतें: इनपुट, एनकोडर, वितरण नमूना डिकोडर। नमूना को एक परत नहीं माना जाता है (e) |

| अनुमान एवं ऊर्जा | ऊर्जा गिब्स संभाव्यता माप द्वारा दी गई है: | ← समान | ← समान | केएल विचलन को कम करें | अनुमान केवल फीड-फॉरवर्ड है। पिछले यूएल नेटवर्क आगे और पीछे चलते थे | त्रुटि न्यूनतम करें = पुनर्निर्माण त्रुटि - केएलडी | |

| प्रशिक्षण | Δwij = si*sj, के लिए +1/-1 न्यूरॉन | Δwij = e*(pij - p'ij), यह केएलडी को न्यूनतम करने से प्राप्त हुआ है।

e = अधिगम दर, p' = अनुमानित और p = वास्तविक वितरण हैं। |

Δwij = e*( < vi hj >data - < vi hj >equilibrium ), यह गिब्स प्रतिदर्शी के साथ विरोधाभासी विचलन का एक रूप है। "<>" अपेक्षाएं हैं। | ← के समान एक समय में 1-परत को प्रशिक्षित करें। 3- खंड पारित के साथ अनुमानित संतुलन स्थिति हैं। कोई पूर्व संचरण नहीं हैं। | जागो-नींद 2 चरण का प्रशिक्षण हैं। | पुनर्निर्माण त्रुटि को वापस प्रचारित करें | बैकप्रॉप के लिए छिपी हुई स्थिति को दोबारा मापें |

| प्रबलता | भौतिक प्रणालियों के सदृश है इसलिए यह उनके समीकरणों को प्राप्त करता है। | ← के समान गुप्त न्यूरॉन्स बाहरी दुनिया के आंतरिक प्रतिनिधित्व के रूप में कार्य करते हैं। | बोल्ट्ज़मैन यंत्रों की तुलना में तीव्र और अधिक व्यावहारिक प्रशिक्षण योजना हैं। | तीव्रता से शृंखला सुविधाओं की श्रेणीबद्ध परत देता है। | हल्का शारीरिक. सूचना सिद्धांत और सांख्यिकीय यांत्रिकी के साथ विश्लेषण योग्य हैं। | ||

| दुर्बलता | पार्श्व संयोजन के कारण प्रशिक्षित करना कठिन है। | संतुलन के लिए बहुत अधिक पुनरावृत्तियों की आवश्यकता होती है। | पूर्णांक और वास्तविक-मूल्यवान न्यूरॉन्स अधिक जटिल हैं। |

हेब्बियन अधिगम, एआरटी, एसओएम

तन्त्रिका जाल के अध्ययन में अपर्यवेक्षित शिक्षण का शास्त्रीय उदाहरण डोनाल्ड हेब्ब का सिद्धांत है, अर्थात, न्यूरॉन्स जो एक साथ तार से आग लगाते हैं।[3]हेब्बियन सीखने में, किसी त्रुटि के बावजूद संयोजन को प्रबल किया जाता है, परन्तु यह विशेष रूप से दो न्यूरॉन्स के मध्य कार्रवाई क्षमता के मध्य संयोग का एक कार्य है।[4]एक समान संस्करण जो सिनैप्टिक भार को संशोधित करता है वह एक्शन पोटेंशिअल (स्पाइक-टाइमिंग-निर्भर प्लास्टिसिटी या एसटीडीपी) के मध्य के समय को ध्यान में रखता है। हेब्बियन अधिगम को प्रतिरुप पहचान और अनुभवात्मक शिक्षा जैसे संज्ञानात्मक कार्यों की एक श्रृंखला को रेखांकित करने के लिए परिकल्पित किया गया है।

कृत्रिम तन्त्रिका जाल प्रतिरूप के मध्य, स्व-संगठित मानचित्र (एसओएम) और अनुकूली अनुनाद सिद्धांत (ART) का उपयोग सामान्यतः बिना पर्यवेक्षित शिक्षण कलन विधि में किया जाता है। एसओएम एक स्थलाकृतिक संगठन है जिसमें मानचित्र में आस-पास के स्थान समान गुणों वाले निविष्ट का प्रतिनिधित्व करते हैं। एआरटी प्रतिरूप समस्या के आकार के साथ समूहों की संख्या को अलग-अलग करने की अनुमति देता है और उपयोगकर्ता को सतर्कता मापदंड नामक उपयोगकर्ता-परिभाषित स्थिरांक के माध्यम से समान गुच्छ के सदस्यों के मध्य समानता की डिग्री को नियंत्रित करने देता है। एआरटी जालक्रम का उपयोग कई प्रतिरुप पहचान कार्यों के लिए किया जाता है, जैसे स्वचालित लक्ष्य पहचान और भूकंपीय सिग्नल प्रोसेसिंग।[5]

संभाव्य विधियाँ

बिना पर्यवेक्षित शिक्षण में उपयोग की जाने वाली दो मुख्य विधियाँ प्रमुख घटक और गुच्छ विश्लेषण हैं। गुच्छ विश्लेषण के उपयोग के बिना पर्यवेक्षित शिक्षण में कलन विधि संबंधों को बहिर्वेशित करने के लिए साझा विशेषताओं वाले आंकड़े समुच्चय को समूह या खंड में करने के लिए किया जाता है।[6]गुच्छ विश्लेषण यंत्र अधिगम की एक शाखा है जो उन आंकड़ों को समूहित करती है जिसे लेबल, या वर्गीकृत नहीं किया गया है। पुनर्निवेशन पर प्रतिक्रिया देने के बजाय, गुच्छ विश्लेषण प्रदत्त में समानताओं की पहचान करता है और प्रदत्त के प्रत्येक नए टुकड़े में ऐसी समानताओं की उपस्थिति या अनुपस्थिति के आधार पर प्रतिक्रिया करता है। यह दृष्टिकोण उन असंगत प्रदत्त बिंदुओं का पता लगाने में सहायता करता है जो किसी भी समूह में उपयुक्त नहीं होते हैं।

अपर्यवेक्षित शिक्षण का एक केंद्रीय अनुप्रयोग सांख्यिकी में घनत्व अनुमान के क्षेत्र में है,[7]हालाँकि बिना पर्यवेक्षित शिक्षण में प्रदत्त सुविधाओं का सारांश और व्याख्या करने वाले कई अन्य डोमेन सम्मिलित हैं। इसकी तुलना पर्यवेक्षित शिक्षण से यह कहकर की जा सकती है कि जबकि पर्यवेक्षित शिक्षण का उद्देश्य निविष्ट प्रदत्त के लेबल पर सशर्त संभाव्यता वितरण का अनुमान लगाना है; अप्रशिक्षित शिक्षण का उद्देश्य एक प्राथमिक संभाव्यता वितरण का अनुमान लगाना है।

दृष्टिकोण

बिना पर्यवेक्षित शिक्षण में उपयोग किए जाने वाले कुछ सबसे सामान्य कलन विधियों में: (1) गुच्छन, (2) विसंगति संसूचन, (3) अव्यक्त चर प्रतिरूप अधिगम के लिए दृष्टिकोण सम्मिलित हैं। प्रत्येक दृष्टिकोण निम्नानुसार कई विधियों का उपयोग करता है:

- गुच्छन विधियों में: पदानुक्रमित गुच्छन,[8]k-माध्य,[9]मिश्रण प्रतिरूप, डीबीएससीएएन, और प्रकाशिकी कलन विधि सम्मिलित हैं।

- विसंगति का पता लगाने के तरीकों में: स्थानीय बाह्य कारक और वियोजन फॉरस्ट सम्मिलित हैं।

- अव्यक्त चर प्रतिरूप सीखने के लिए दृष्टिकोण जैसे कि अपेक्षा-अधिकतमकरण कलन विधि (EM), आघूर्णो की विधि और अंध संकेत पृथक्करण प्रविधि (प्रमुख घटक विश्लेषण, स्वतंत्र घटक विश्लेषण, गैर-ऋणात्मक आव्यूह गुणनखंडन, अद्वितीय मान अपघटन) हैं।

आघूर्णो की विधि

बिना पर्यवेक्षित शिक्षण के लिए सांख्यिकीय दृष्टिकोणों में से एक आघूर्ण विधि है। आघूर्णो की विधि में, प्रतिरूप में अज्ञात मापदंड (रुचि के) एक या अधिक यादृच्छिक चर के आघूर्णो से संबंधित होते हैं और इस प्रकार, इन अज्ञात मापदंडों का अनुमान आघूर्णो को देखते हुए लगाया जा सकता है। आघूर्णो का अनुमान सामान्यतः अनुभवजन्य रूप से प्रतिरूपों से लगाया जाता है। मूल आघूर्ण प्रथम और द्वितीय क्रम के आघूर्ण हैं। एक यादृच्छिक सदिश के लिए, पहले क्रम का आघूर्ण माध्य सदिश है और दूसरे क्रम का आघूर्ण सहप्रसरण आव्यूह है (जब माध्य शून्य है)। उच्च क्रम के आघूर्णो को सामान्यतः प्रदिश का उपयोग करके दर्शाया जाता है जो कि बहु-आयामी सरणियों के रूप में उच्च क्रम के आव्यूह का सामान्यीकरण है।

विशेष रूप से, अव्यक्त चर प्रतिरूप के मापदंडों को सीखने में आघूर्णो की विधि को प्रभावी दर्शाया गया है। अव्यक्त चर प्रतिरूप सांख्यिकीय प्रतिरूप हैं जहां देखे गए चर के अतिरिक्त, अव्यक्त चर का एक समुच्चय भी उपस्थित होता है जो नहीं देखा जाता है। यंत्र अधिगम में अव्यक्त चर प्रतिरूप का एक अत्यधिक व्यावहारिक उदाहरण विषय मॉडलिंग है जो प्रपत्र के विषय (अव्यक्त चर) के आधार पर प्रपत्र में शब्द (अवलोकित चर) उत्पन्न करने के लिए एक सांख्यिकीय प्रतिरूप है। विषय मॉडलिंग में, प्रपत्र का विषय परिवर्तित करने पर प्रपत्र में शब्द विभिन्न सांख्यिकीय मापदंडों के अनुसार उत्पन्न होते हैं। यह दर्शाया गया है कि आघूर्णो की विधि (टेंसर अपघटन प्रविधि) कुछ मान्यताओं के अंतर्गत अव्यक्त चर प्रतिरूप के एक बड़े वर्ग के मापदंडों को निरंतर पुनर्प्राप्त करती है।[10]

अपेक्षा-अधिकतमकरण कलन विधि (EM) भी अव्यक्त चर प्रतिरूप अधिगम के लिए सबसे व्यावहारिक तरीकों में से एक है। हालाँकि, यह स्थानीय ऑप्टिमा में फंस सकता है और यह प्रत्याभूति नहीं है कि कलन विधि प्रतिरूप के वास्तविक अज्ञात मापदंडों में परिवर्तित हो जाएगा। इसके विपरीत, आघूर्णो की विधि के लिए, कुछ प्रतिबंधों के अंतर्गत वैश्विक अभिसरण की प्रत्याभूति दी जाती है।

यह भी देखें

- स्वचालित यंत्र अधिगम

- गुच्छ विश्लेषण

- विसंगति संसूचन

- अपेक्षा-अधिकतमीकरण कलन विधि

- प्रजनक स्थलाकृतिक मानचित्र

- मेटा-अधिगम (अभिकलित्र विज्ञान)

- बहुभिन्नरूपी विश्लेषण

- त्रिज्यीय आधार क्रिया जालक्रम

- दुर्बल पर्यवेक्षण

संदर्भ

- ↑ Hinton, G. (2012). "A Practical Guide to Training Restricted Boltzmann Machines" (PDF). Neural Networks: Tricks of the Trade. Lecture Notes in Computer Science. Vol. 7700. Springer. pp. 599–619. doi:10.1007/978-3-642-35289-8_32. ISBN 978-3-642-35289-8.

- ↑ Hinton, Geoffrey (September 2009). "Deep Belief Nets" (video).

- ↑ Buhmann, J.; Kuhnel, H. (1992). "Unsupervised and supervised data clustering with competitive neural networks". [Proceedings 1992] IJCNN International Joint Conference on Neural Networks. Vol. 4. IEEE. pp. 796–801. doi:10.1109/ijcnn.1992.227220. ISBN 0780305590. S2CID 62651220.

- ↑ Comesaña-Campos, Alberto; Bouza-Rodríguez, José Benito (June 2016). "An application of Hebbian learning in the design process decision-making". Journal of Intelligent Manufacturing. 27 (3): 487–506. doi:10.1007/s10845-014-0881-z. ISSN 0956-5515. S2CID 207171436.

- ↑ Carpenter, G.A. & Grossberg, S. (1988). "The ART of adaptive pattern recognition by a self-organizing neural network" (PDF). Computer. 21 (3): 77–88. doi:10.1109/2.33. S2CID 14625094.

- ↑ Roman, Victor (2019-04-21). "Unsupervised Machine Learning: Clustering Analysis". Medium. Retrieved 2019-10-01.

- ↑ Jordan, Michael I.; Bishop, Christopher M. (2004). "7. Intelligent Systems §Neural Networks". In Tucker, Allen B. (ed.). Computer Science Handbook (2nd ed.). Chapman & Hall/CRC Press. doi:10.1201/9780203494455. ISBN 1-58488-360-X.

- ↑ Hastie, Tibshirani & Friedman 2009, pp. 485–586

- ↑ Garbade, Dr Michael J. (2018-09-12). "Understanding K-means Clustering in Machine Learning". Medium (in English). Retrieved 2019-10-31.

- ↑ Anandkumar, Animashree; Ge, Rong; Hsu, Daniel; Kakade, Sham; Telgarsky, Matus (2014). "Tensor Decompositions for Learning Latent Variable Models" (PDF). Journal of Machine Learning Research. 15: 2773–2832. arXiv:1210.7559. Bibcode:2012arXiv1210.7559A.

<ref> tag with name "Hinton99a" defined in <references> is not used in prior text.

अग्रिम पठन

- Bousquet, O.; von Luxburg, U.; Raetsch, G., eds. (2004). Advanced Lectures on Machine Learning. Springer. ISBN 978-3540231226.

- Duda, Richard O.; Hart, Peter E.; Stork, David G. (2001). "Unsupervised Learning and Clustering". Pattern classification (2nd ed.). Wiley. ISBN 0-471-05669-3.

- Hastie, Trevor; Tibshirani, Robert; Friedman, Jerome (2009). "Unsupervised Learning". The Elements of Statistical Learning: Data mining, Inference, and Prediction. Springer. pp. 485–586. doi:10.1007/978-0-387-84858-7_14. ISBN 978-0-387-84857-0.

- Hinton, Geoffrey; Sejnowski, Terrence J., eds. (1999). Unsupervised Learning: Foundations of Neural Computation. MIT Press. ISBN 0-262-58168-X.