उच्च बैंडविड्थ मेमोरी

| कंप्यूटर मेमोरी और डेटा स्टोरेज प्रकार |

|---|

| वाष्पशील |

| गैर-वाष्पशील |

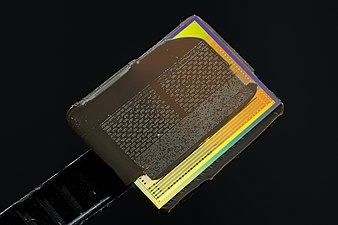

उच्च बैंडविड्थ मेमोरी (HBM) त्रि-आयामी एकीकृत सर्किट के लिए एक उच्च गति वाला स्मृति इंटरफ़ेस है। प्रारंभिक में सैमसंग इलेक्ट्रॉनिक्स, उन्नत माइक्रो डिवाइसेस और SK हाइनिक्स से 3D-स्टैक्ड सिंक्रोनस डायनेमिक रैंडम-एक्सेस मेमोरी (SDRAM) है। इसका उपयोग उच्च-प्रदर्शन ग्राफिक्स त्वरक, नेटवर्क उपकरणों, उच्च-प्रदर्शन डेटासेंटर AI ASICs और FPGAs और कुछ सुपर कंप्यूटरों (जैसे NEC SX-Aurora TSUBASA और Fujitsu A64FX) में किया जाता है।[1] 2013 में SK हाइनिक्स द्वारा पहली HBM मेमोरी चिप का निर्माण किया गया था।[2]और एचबीएम का उपयोग करने वाले पहले डिवाइस 2015 में एएमडी Radeon Rx 300 Series|एएमडी फिजी जीपीयू थे।[3][4]

JEDEC द्वारा अक्टूबर 2013 में एक उद्योग मानक के रूप में उच्च बैंडविड्थ मेमोरी को अपनाया गया है।[5] दूसरी पीढ़ी, HBM2, को जनवरी 2016 में JEDEC द्वारा स्वीकृति प्राप्त हुई।[6]

प्रौद्योगिकी

DDR4 SDRAM या GDDR5 की समानता में अत्यधिक छोटे फॉर्म फैक्टर में कम बिजली का उपयोग करते हुए HBM उच्च बैंडविड्थ (कंप्यूटिंग) प्राप्त करता है।[7] यह आठ डायनेमिक रैंडम-एक्सेस मेमोरी डाई (एकीकृत सर्किट) और एक वैकल्पिक बेस डाई तक ढेर करके प्राप्त किया जाता है जिसमें बफर सर्किटरी और टेस्ट लॉजिक सम्मलित हो सकते हैं।[8] स्टैक अधिकांशतः ग्राफ़िक्स प्रोसेसिंग युनिट या सेंट्रल प्रोसेसिंग यूनिट पर एक सब्सट्रेट के माध्यम से मेमोरी कंट्रोलर से जुड़ा होता है, जैसे कि सिलिकॉन जड़ना ।[9][10] वैकल्पिक रूप से, मेमोरी डाई को सीधे CPU या GPU चिप पर स्टैक किया जा सकता है। स्टैक के भीतर डाई थ्रू-सिलिकॉन वियास (TSVs) और मिक्रोबुप द्वारा लंबवत रूप से जुड़े हुए हैं। एचबीएम तकनीक सैद्धांतिक रूप से समान है किन्तु माइक्रोन प्रौद्योगिकी द्वारा विकसित हाइब्रिड मेमोरी क्यूब (एचएमसी) इंटरफेस के साथ असंगत है।[11]

DDR4 या GDDR5 जैसी अन्य DRAM मेमोरी की समानता में HBM मेमोरी बस बहुत विस्तृत है। चार DRAM का एक HBM स्टैक मर जाता है (4‑Hi) में दो 128 हैं{{nbhyph}कुल 8 चैनलों के लिए प्रति डाई बिट चैनल और कुल मिलाकर 1024 बिट की चौड़ाई। चार के साथ एक ग्राफिक्स कार्ड/जीपीयू 4‑Hi एचबीएम स्टैक में 4096 बिट की चौड़ाई वाली एक मेमोरी बस होगी। इसकी समानता में, GDDR मेमोरी की बस चौड़ाई 32 बिट्स है, जिसमें 512 ग्राफिक्स कार्ड के लिए 16 चैनल हैं।{{nbhyph}बिट मेमोरी इंटरफ़ेस।[12] एचबीएम प्रति पैकेज 4 जीबी तक का समर्थन करता है।

DDR4 या GDDR5 की समानता में मेमोरी से कनेक्शन की बड़ी संख्या के लिए, HBM मेमोरी को GPU (या अन्य प्रोसेसर) से कनेक्ट करने के लिए एक नई विधि की आवश्यकता होती है।[13] एएमडी और एनवीडिया दोनों ने मेमोरी और जीपीयू को जोड़ने के लिए उद्देश्य से निर्मित सिलिकॉन चिप्स का उपयोग किया है, जिसे इंटरपोजर कहा जाता है। इस इंटरपोजर के पास मेमोरी और प्रोसेसर को शारीरिक रूप से बंद करने, कम करने वाले मेमोरी पथों की आवश्यकता का अतिरिक्त लाभ है। चूंकि , मुद्रित सर्किट बोर्ड निर्माण की समानता में अर्धचालक उपकरण निर्माण निर्माण अत्यधिक महंगा है, इससे अंतिम उत्पाद की लागत बढ़ जाती है।

इंटरफ़ेस

HBM DRAM एक वितरित इंटरफ़ेस के साथ होस्ट कंप्यूट डाई से कसकर जुड़ा हुआ है। इंटरफ़ेस स्वतंत्र चैनलों में बांटा गया है। चैनल एक दूसरे से पूरी तरह से स्वतंत्र हैं और जरूरी नहीं कि वे एक दूसरे के समकालिक हों। HBM DRAM हाई-स्पीड, लो-पावर ऑपरेशन को प्राप्त करने के लिए एक वाइड-इंटरफ़ेस आर्किटेक्चर का उपयोग करता है। HBM DRAM 500 मेगाहर्ट्ज विभेदक संकेतन क्लॉक CK_t / CK_c का उपयोग करता है (जहां प्रत्यय _t डिफरेंशियल पेयर के सही या सकारात्मक घटक को दर्शाता है, और _c पूरक को दर्शाता है)। CK_t, CK_c के बढ़ते किनारे पर कमांड पंजीकृत हैं। प्रत्येक चैनल इंटरफ़ेस 128 बनाए रखता है{{nbhyph}बिट डेटा बस डबल डेटा दर (DDR) पर काम कर रही है। HBM 1 GT/s प्रति पिन (1 बिट ट्रांसफर) की स्थानांतरण दरों का समर्थन करता है, जिससे 128 GB/s का समग्र पैकेज बैंडविड्थ प्राप्त होता है।[14]

एचबीएम2

उच्च बैंडविड्थ मेमोरी, HBM2 की दूसरी पीढ़ी भी प्रति स्टैक आठ डाइस तक निर्दिष्ट करती है और 2 GT/s तक पिन स्थानांतरण दरों को दोगुना करती है। 1024 को बनाए रखना‑बिट वाइड एक्सेस, HBM2 प्रति पैकेज 256 GB/s मेमोरी बैंडविड्थ तक पहुंचने में सक्षम है। HBM2 विनिर्देश प्रति पैकेज 8 जीबी तक की अनुमति देता है। HBM2 को आभासी वास्तविकता जैसे प्रदर्शन-संवेदनशील उपभोक्ता अनुप्रयोगों के लिए विशेष रूप से उपयोगी होने की भविष्यवाणी की गई है।[15]

19 जनवरी, 2016 को, SAMSUNG ने प्रति स्टैक 8 GB तक HBM2 के शुरुआती बड़े पैमाने पर उत्पादन की घोषणा की।[16][17] SK हाइनिक्स ने अगस्त 2016 में 4 GB स्टैक की उपलब्धता की भी घोषणा की।[18]

एचबीएम2ई

2018 के अंत में, JEDEC ने HBM2 विनिर्देशों के लिए एक अद्यतन की घोषणा की, जो बैंडविड्थ और क्षमताओं में वृद्धि प्रदान करता है।[19] 307 GB/s प्रति स्टैक (2.5 Tbit/s प्रभावी डेटा दर) अब आधिकारिक विनिर्देश में समर्थित है, चूंकि इस गति से चलने वाले उत्पाद पहले से ही उपलब्ध थे। इसके अतिरिक्त, अद्यतन ने 12 के लिए समर्थन जोड़ा‑हाय स्टैक (12 डेज़) प्रति स्टैक 24 जीबी तक की क्षमता संभव बनाता है।

20 मार्च, 2019 को, सैमसंग ने अपने फ्लैशबोल्ट एचबीएम2ई की घोषणा की, जिसमें आठ डाई प्रति स्टैक, 3.2 जीटी/एस की अंतरण दर, कुल 16 जीबी और 410 जीबी/एस प्रति स्टैक प्रदान करता है।[20]

12 अगस्त, 2019 को SK हाइनिक्स ने अपने HBM2E की घोषणा की, जिसमें प्रति स्टैक आठ डाइस, 3.6 GT/s की ट्रांसफर दर, कुल 16 GB और 460 GB/s प्रति स्टैक प्रदान करता है।[21][22] 2 जुलाई 2020 को SK हाइनिक्स ने घोषणा की कि बड़े पैमाने पर उत्पादन प्रारंभ हो गया है।[23]

एचबीएम3

2020 के अंत में, माइक्रोन टेक्नोलॉजी ने अनावरण किया कि HBM2E मानक को अद्यतन किया जाएगा और इसके साथ ही उन्होंने HBMnext (बाद में इसका नाम बदलकर HBM3) के रूप में ज्ञात अगले मानक का अनावरण किया। यह HBM2 और HBM2E के प्रतिस्थापन से एक बड़ी पीढ़ीगत छलांग थी। यह नया वीआरएएम 2022 की चौथी तिमाही में बाजार में आ गया होगा। जैसा कि नाम से पता चलता है, यह संभवतः एक नई वास्तुकला प्रस्तुत करेगा।

जबकि आर्किटेक्चर को ओवरहाल किया जा सकता है, लीक अद्यतन HBM2E मानक के समान प्रदर्शन की ओर संकेत करते हैं। इस रैम का ज्यादातर डेटा सेंटर जीपीयू में उपयोग होने की संभावना है।[24][25][26][27]

2021 के मध्य में, SK हाइनिक्स ने 5.2Gbit/s I/O स्पीड और 665GB/s प्रति पैकेज की बैंडविड्थ के साथ-साथ 16-उच्च 2.5D और 3D समाधानों के साथ HBM3 मानक के कुछ विनिर्देशों का अनावरण किया।[28][29]

20 अक्टूबर 2021 को, HBM3 के लिए JEDEC मानक को अंतिम रूप दिए जाने से पहले, SK हाइनिक्स यह घोषणा करने वाला पहला मेमोरी विक्रेता था कि उसने HBM3 मेमोरी उपकरणों का विकास पूरा कर लिया है। SK हाइनिक्स के अनुसार, मेमोरी 6.4Gbps/pin जितनी तेज चलेगी, JEDEC-मानक HBM2E की डेटा दर दोगुनी होगी, जो औपचारिक रूप से 3.2Gbps/pin पर सबसे ऊपर है, या SK हाइनिक्स के अपने 3.6Gbps/pin HBM2E से 78% तेज है। . डिवाइस 6.4 GT/s की डेटा अंतरण दर का समर्थन करते हैं और इसलिए एक एकल HBM3 स्टैक 819 GB/s तक की बैंडविड्थ प्रदान कर सकता है। HBM3 के लिए मूल बस की चौड़ाई अपरिवर्तित रहती है, जिसमें मेमोरी का एक स्टैक 1024-बिट चौड़ा होता है। SK हाइनिक्स उनकी मेमोरी को दो क्षमताओं में प्रस्तुत करेगा: 16GB और 24GB, क्रमशः 8-Hi और 12-Hi स्टैक के साथ। ढेर में 8 या 12 16 जीबी डीआरएएम होते हैं जो प्रत्येक 30 माइक्रोन मोटे होते हैं और सिलिकॉन वायस (टीएसवी) के माध्यम से जुड़े होते हैं।[30][31][32]

आनंदटेक के रेयान स्मिथ के अनुसार, SK हाइनिक्स पहली पीढ़ी की HBM3 मेमोरी में उनकी नवीनतम पीढ़ी की HBM2E मेमोरी के समान घनत्व है, जिसका अर्थ है कि डिवाइस विक्रेता जो अपने अगली पीढ़ी के पुर्जों के लिए अपनी कुल मेमोरी क्षमता बढ़ाना चाहते हैं, उन्हें 12 के साथ मेमोरी का उपयोग करने की आवश्यकता होगी। डाइस/लेयर्स, 8 लेयर स्टैक्स से ऊपर जो वे सामान्यतः तब तक उपयोग करते थे।[30] टॉम के हार्डवेयर के एंटोन शिलोव के अनुसार, उच्च-प्रदर्शन कंप्यूट जीपीयू या एफपीजीए सामान्यतः चार या छह एचबीएम स्टैक का उपयोग करते हैं, इसलिए एसके हाइनिक्स के एचबीएम3 24 जीबी स्टैक के साथ वे तदनुसार 3.2 टीबी/एस या 4.9 टीबी/एस मेमोरी बैंडविड्थ प्राप्त करेंगे। उन्होंने यह भी नोट किया कि SK हाइनिक्स के HBM3 चिप्स वर्गाकार हैं, HBM2 और HBM2E चिप्स की तरह आयताकार नहीं हैं।[31]द रजिस्टर के क्रिस मेलर के अनुसार, JEDEC ने अभी तक अपने HBM3 मानक को विकसित नहीं किया है, इसका अर्थ यह हो सकता है कि SK हाइनिक्स को अपने डिजाइन को भविष्य में और तेज करने की आवश्यकता होगी।[32]

JEDEC ने आधिकारिक तौर पर 27 जनवरी, 2022 को HBM3 मानक की घोषणा की।[33] HBM2e के साथ 128 बिट्स के 8 चैनलों से HBM3 के साथ 64 बिट्स के 16 चैनलों तक मेमोरी चैनलों की संख्या दोगुनी हो गई थी। इसलिए, इंटरफ़ेस के डेटा पिनों की कुल संख्या अभी भी 1024 है।[34]

जून 2022 में, SK हाइनिक्स ने घोषणा की कि उन्होंने Nvidia के H100 GPU के साथ उपयोग की जाने वाली उद्योग की पहली HBM3 मेमोरी का बड़े पैमाने पर उत्पादन प्रारंभ कर दिया है, जिसके 2022 की तीसरी तिमाही में आने की उम्मीद है। मेमोरी H100 को 819 GB/s तक मेमोरी बैंडविड्थ प्रदान करेगी। रेफरी>"SK hynix NVIDIA को उद्योग के पहले HBM3 DRAM की आपूर्ति करेगा". SK Hynix. June 8, 2022. Retrieved December 11, 2022.</ref>

अगस्त 2022 में, एनवीडिया ने घोषणा की कि उसका हॉपर एच100 जीपीयू पांच सक्रिय एचबीएम3 साइटों (बोर्ड पर छह में से) के साथ शिप करेगा, जो 80 जीबी रैम और 3 टीबी/एस मेमोरी बैंडविड्थ (16 जीबी और 600 जीबी/एस प्रति साइट) की भेंट करेगा। रेफरी>Robinson, Cliff (August 22, 2022). "NVIDIA H100 हॉपर विवरण HC34 पर है क्योंकि यह अगली पीढ़ी के CPU की प्रतीक्षा कर रहा है". ServeTheHome (in English). Retrieved December 11, 2022.</ref>

एचबीएम-पीआईएम

फरवरी 2021 में, सैमसंग ने प्रोसेसिंग-इन-मेमोरी (पीआईएम) के साथ एचबीएम के विकास की घोषणा की। यह नई मेमोरी डेटा के बड़े पैमाने पर प्रसंस्करण को बढ़ाने के लिए एआई कंप्यूटिंग क्षमताओं को मेमोरी के अंदर लाती है। समानांतर प्रसंस्करण को सक्षम करने और डेटा आंदोलन को कम करने के लिए प्रत्येक मेमोरी बैंक के अंदर एक डीआरएएम-अनुकूलित एआई इंजन रखा गया है। सैमसंग का प्रमाणित है कि यह सिस्टम के प्रदर्शन को दोगुना कर देगा और ऊर्जा की खपत को 70% से अधिक कम कर देगा, जबकि बाकी सिस्टम में किसी भी हार्डवेयर या सॉफ्टवेयर बदलाव की आवश्यकता नहीं होगी।[35]

इतिहास

पृष्ठभूमि

त्रि-आयामी एकीकृत सर्किट | डाइ-स्टैक्ड मेमोरी को प्रारंभ में फ्लैश मेमोरी उद्योग में व्यावसायीकरण किया गया था। तोशीबा ने अप्रैल 2007 में आठ स्टैक्ड डाइज़ के साथ NAND फ्लैश मेमोरी चिप प्रस्तुत की,[36] सितंबर 2007 में हाइनिक्स सेमीकंडक्टर ने 24 स्टैक्ड डाइज़ के साथ NAND फ्लैश चिप प्रस्तुत किया।[37]

3D-स्टैक्ड रैंडम एक्सेस मेमोरी (रैम) थ्रू-सिलिकॉन थ्रू (टीएसवी) तकनीक का उपयोग करके एल्पिडा मेमोरी द्वारा व्यावसायीकरण किया गया, जिसने पहले 8 विकसित किए{{nbsp}सितंबर 2009 में गिबिबाइट गतिशील रैम चिप (चार DDR3 SDRAM डाइस के साथ ढेर) और जून 2011 में इसे जारी किया। 2011 में, SK हाइनिक्स ने 16 प्रस्तुत किए{{nbsp}जीबी डीडीआर3 मेमोरी (40 नैनोमीटर|40nm क्लास) TSV तकनीक का उपयोग करके,[2]सैमसंग इलेक्ट्रॉनिक्स ने 3D-स्टैक्ड 32 प्रस्तुत किया{{nbsp}जीबी डीडीआर3 (32 नैनोमीटर|30nm क्लास) सितंबर में TSV पर आधारित थी, और फिर सैमसंग और माइक्रोन टेक्नोलॉजी ने अक्टूबर में TSV-आधारित हाइब्रिड मेमोरी क्यूब (HMC) तकनीक की घोषणा किया।[38]

JEDEC ने सबसे पहले वाइड IO मेमोरी के लिए JESD229 मानक जारी किया,[39] एचबीएम के पूर्ववर्ती ने कई वर्षों के काम के बाद दिसंबर 2011 में सिंगल डेटा रेट क्लॉकिंग के साथ चार 128 बिट चैनल प्रस्तुत किए। पहला HBM मानक JESD235 अक्टूबर 2013 में अपनाया गया।

विकास

उच्च बैंडविड्थ मेमोरी का विकास 2008 में एएमडी में प्रारंभ हुआ था जिससे लगातार बढ़ती बिजली के उपयोग और कंप्यूटर मेमोरी के फॉर्म फैक्टर की समस्या को हल किया जा सके। अगले कई वर्षों में, एएमडी ने सीनियर एएमडी फेलो ब्रायन ब्लैक के नेतृत्व वाली टीम के साथ डाई-स्टैकिंग समस्याओं को हल करने के लिए प्रक्रियाएं विकसित कीं।[40] एएमडी को एचबीएम के अपने दृष्टिकोण को साकार करने में मदद करने के लिए, उन्होंने मेमोरी उद्योग से भागीदारों को सूचीबद्ध किया, विशेष रूप से कोरियाई कंपनी एसके हाइनिक्स,[40]जिसे 3D-स्टैक्ड मेमोरी के साथ पूर्व अनुभव था,[2][37]साथ ही साथ इंटरपोजर उद्योग (ताइवान की कंपनी यूनाइटेड माइक्रोइलेक्ट्रॉनिक कॉर्पोरेशन) और एकीकृत सर्किट पैकेजिंग उद्योग (अमकोर प्रौद्योगिकी और उन्नत सेमीकंडक्टर इंजीनियरिंग ) के साझेदार हैं।[40]

HBM का विकास 2013 में पूरा हुआ, जब SK हाइनिक्स ने पहली HBM मेमोरी चिप का निर्माण किया।[2] 2010 में एएमडी और SK हाइनिक्स के एक प्रस्ताव के बाद, अक्टूबर 2013 में JEDEC द्वारा HBM को उद्योग मानक JESD235 के रूप में अपनाया गया था।[5]2015 में Icheon, दक्षिण कोरिया में एक हाइनिक्स सुविधा में उच्च मात्रा में निर्माण प्रारंभ हुआ।

HBM का उपयोग करने वाला पहला GPU एएमडी फिजी था जिसे जून 2015 में एएमडी Radeon R9 Fury X को पॉवर देने के लिए जारी किया गया था।[3][41][42]

जनवरी 2016 में, सैमसंग इलेक्ट्रॉनिक्स ने एचबीएम2 का प्रारंभिक बड़े पैमाने पर उत्पादन प्रारंभ किया।[16][17]उसी महीने, HBM2 को JEDEC ने मानक JESD235a के रूप में स्वीकार कर लिया।[6]HBM2 का उपयोग करने वाली पहली GPU चिप Nvidia Tesla P100 है जिसे आधिकारिक तौर पर अप्रैल 2016 में घोषित किया गया था।[43][44]

जून 2016 में, Intel ने HBM के माइक्रोन के संस्करण HCDRAM के 8 स्टैक के साथ Xeon Phi प्रोसेसर का एक परिवार जारी किया। अगस्त 2016 में Hot Chips में, सैमसंग और हाइनिक्स दोनों ने एक नई पीढ़ी की HBM मेमोरी तकनीकों की घोषणा की।[45][46] दोनों कंपनियों ने उच्च प्रदर्शन वाले उत्पादों की घोषणा की, जिनमें घनत्व में वृद्धि, बैंडविड्थ में वृद्धि और बिजली की कम खपत की उम्मीद थी। सैमसंग ने बड़े पैमाने पर बाजारों को लक्षित विकास के अनुसार एचबीएम के कम लागत वाले संस्करण की भी घोषणा की। बफर डाई को हटाना और कम लागत के माध्यम से थ्रू-सिलिकॉन की संख्या को कम करना, चूंकि कम समग्र बैंडविड्थ (200 जीबी/एस) की कीमत पर कमी होती है।

एनवीडिया ने 22 मार्च, 2022 को एनवीडिया हॉपर जीएच100 जीपीयू की घोषणा की, जो एचबीएम3 का उपयोग करने वाला दुनिया का पहला जीपीयू है।[47]

यह भी देखें

- ढेर घूंट

- ईडीआरएएम

- चिप स्टैक मल्टी-चिप मॉड्यूल

- हाइब्रिड मेमोरी क्यूब (HMC): माइक्रोन टेक्नोलॉजी (2011) से स्टैक्ड मेमोरी मानक

संदर्भ

- ↑ ISSCC 2014 Trends Archived 2015-02-06 at the Wayback Machine page 118 "High-Bandwidth DRAM"

- ↑ Jump up to: 2.0 2.1 2.2 2.3 "History: 2010s". SK Hynix. Retrieved 7 March 2023.

- ↑ Jump up to: 3.0 3.1 Smith, Ryan (2 July 2015). "AMD Radeon R9 Fury X समीक्षा". Anandtech. Retrieved 1 August 2016.

{{cite news}}: no-break space character in|title=at position 19 (help) - ↑ Morgan, Timothy Prickett (March 25, 2014). "Future Nvidia 'Pascal' GPUs Pack 3D Memory, Homegrown Interconnect". EnterpriseTech. Retrieved 26 August 2014.

Nvidia will be adopting the High Bandwidth Memory (HBM) variant of stacked DRAM that was developed by AMD and Hynix

- ↑ Jump up to: 5.0 5.1 हाई बैंडविड्थ मेमोरी (HBM) DRAM (JESD235), JEDEC, अक्टूबर 2013

- ↑ Jump up to: 6.0 6.1 "JESD235a: उच्च बैंडविड्थ मेमोरी 2". 2016-01-12.

- ↑ HBM: Memory Solution for Bandwidth-Hungry Processors Archived 2015-04-24 at the Wayback Machine, Joonyoung Kim and Younsu Kim, SK Hynix // Hot Chips 26, August 2014

- ↑ Sohn et.al. (Samsung) (January 2017). "A 1.2 V 20 nm 307 GB/s HBM DRAM With At-Speed Wafer-Level IO Test Scheme and Adaptive Refresh Considering Temperature Distribution". IEEE Journal of Solid-State Circuits. 52 (1): 250–260. Bibcode:2017IJSSC..52..250S. doi:10.1109/JSSC.2016.2602221. S2CID 207783774.

{{cite journal}}: CS1 maint: url-status (link) - ↑ "उच्च बैंडविड्थ मेमोरी के लिए आगे क्या है". 17 December 2019.

- ↑ "Interposers".

- ↑ Where Are DRAM Interfaces Headed? Archived 2018-06-15 at the Wayback Machine // EETimes, 4/18/2014 "The Hybrid Memory Cube (HMC) and a competing technology called High-Bandwidth Memory (HBM) are aimed at computing and networking applications. These approaches stack multiple DRAM chips atop a logic chip."

- ↑ Highlights of the HighBandwidth Memory (HBM) Standard. Mike O’Connor, Sr. Research Scientist, NVidia // The Memory Forum – June 14, 2014

- ↑ Smith, Ryan (19 May 2015). "AMD Dives Deep On High Bandwidth Memory – What Will HBM Bring to AMD?". Anandtech. Retrieved 12 May 2017.

- ↑ "हाई-बैंडविड्थ मेमोरी (HBM)" (PDF). AMD. 2015-01-01. Retrieved 2016-08-10.

- ↑ Valich, Theo (2015-11-16). "NVIDIA Unveils Pascal GPU: 16GB of memory, 1TB/s Bandwidth". VR World. Retrieved 2016-01-24.

- ↑ Jump up to: 16.0 16.1 "Samsung Begins Mass Producing World's Fastest DRAM – Based on Newest High Bandwidth Memory (HBM) Interface". news.samsung.com.

- ↑ Jump up to: 17.0 17.1 "Samsung announces mass production of next-generation HBM2 memory – ExtremeTech". 19 January 2016.

- ↑ Shilov, Anton (1 August 2016). "SK Hynix Adds HBM2 to Catalog". Anandtech. Retrieved 1 August 2016.

- ↑ "जेईडीईसी ने अभूतपूर्व उच्च बैंडविड्थ मेमोरी (एचबीएम) मानक को अद्यतन किया" (Press release). JEDEC. 2018-12-17. Retrieved 2018-12-18.

- ↑ "Samsung Electronics Introduces New High Bandwidth Memory Technology Tailored to Data Centers, Graphic Applications, and AI | Samsung Semiconductor Global Website". www.samsung.com (in English). Retrieved 2019-08-22.

- ↑ "SK Hynix Develops World's Fastest High Bandwidth Memory, HBM2E". www.skhynix.com. August 12, 2019. Retrieved 2019-08-22.

- ↑ "SK Hynix Announces its HBM2E Memory Products, 460 GB/S and 16GB per Stack".

- ↑ "SK hynix Starts Mass-Production of High-Speed DRAM, "HBM2E"". 2 July 2020.

- ↑ "Micron reveals HBMnext, a successor to HBM2e". VideoCardz (in English). August 14, 2020. Retrieved December 11, 2022.

- ↑ Hill, Brandon (August 14, 2020). "Micron Announces HBMnext as Eventual Replacement for HBM2e in High-End GPUs". HotHardware (in English). Retrieved December 11, 2022.

- ↑ Hruska, Joel (August 14, 2020). "Micron Introduces HBMnext, GDDR6X, Confirms RTX 3090". ExtremeTech (in English). Retrieved December 11, 2022.

- ↑ Garreffa, Anthony (August 14, 2020). "Micron unveils HBMnext, the successor to HBM2e for next-next-gen GPUs". TweakTown (in English). Retrieved December 11, 2022.

- ↑ "SK Hynix expects HBM3 memory with 665 GB/S bandwidth".

- ↑ Shilov, Anton (June 9, 2021). "HBM3 to Top 665 GBPS Bandwidth per Chip, SK Hynix Says". Tom's Hardware (in English). Retrieved December 11, 2022.

- ↑ Jump up to: 30.0 30.1 Smith, Ryan (October 20, 2021). "SK Hynix Announces Its First HBM3 Memory: 24GB Stacks, Clocked at up to 6.4Gbps". AnandTech (in English). Retrieved October 22, 2021.

- ↑ Jump up to: 31.0 31.1 Shilov, Anton (October 20, 2021). "SK Hynix Develops HBM3 DRAMs: 24GB at 6.4 GT/s over a 1024-Bit Bus". Tom's Hardware (in English). Retrieved October 22, 2021.

- ↑ Jump up to: 32.0 32.1 Mellor, Chris (October 20, 2021). "SK hynix rolls out 819GB/s HBM3 DRAM". The Register (in English). Retrieved October 24, 2021.

- ↑ "JEDEC Publishes HBM3 Update to High Bandwidth Memory (HBM) Standard". JEDEC (Press release) (in English). Arlington, VA. January 27, 2022. Retrieved December 11, 2022.

- ↑ Prickett Morgan, Timothy (April 6, 2022). "HBM3 रोडमैप अभी शुरू हो रहा है". The Next Platform. Retrieved May 4, 2022.

- ↑ "Samsung Develops Industry's First High Bandwidth Memory with AI Processing Power".

- ↑ "तोशिबा ने मोबाइल उपभोक्ता उत्पादों के लिए उद्योग की उच्चतम क्षमता वाली एंबेडेड नंद फ्लैश मेमोरी का वाणिज्यीकरण किया". Toshiba. April 17, 2007. Archived from the original on November 23, 2010. Retrieved 23 November 2010.

- ↑ Jump up to: 37.0 37.1 "हाइनिक्स ने नंद चिप उद्योग को चौंका दिया". Korea Times. 5 September 2007. Retrieved 8 July 2019.

- ↑ Kada, Morihiro (2015). "Research and Development History of Three-Dimensional Integration Technology". Three-Dimensional Integration of Semiconductors: Processing, Materials, and Applications. Springer. pp. 15–8. ISBN 9783319186757.

- ↑ "WIDE I/O SINGLE DATA RATE (WIDE I/O SDR) standard JESD229" (PDF).

{{cite web}}: CS1 maint: url-status (link) - ↑ Jump up to: 40.0 40.1 40.2 High-Bandwidth Memory (HBM) from AMD: Making Beautiful Memory, AMD

- ↑ Smith, Ryan (19 May 2015). "एएमडी एचबीएम डीप डाइव". Anandtech. Retrieved 1 August 2016.

- ↑ [1] AMD Ushers in a New Era of PC Gaming including World’s First Graphics Family with Revolutionary HBM Technology

- ↑ Smith, Ryan (5 April 2016). "एनवीडिया ने टेस्ला पी100 एक्सेलेरेटर की घोषणा की". Anandtech. Retrieved 1 August 2016.

- ↑ "NVIDIA Tesla P100: The Most Advanced Data Center GPU Ever Built". www.nvidia.com.

- ↑ Smith, Ryan (23 August 2016). "Hot Chips 2016: Memory Vendors Discuss Ideas for Future Memory Tech – DDR5, Cheap HBM & More". Anandtech. Retrieved 23 August 2016.

- ↑ Walton, Mark (23 August 2016). "HBM3: Cheaper, up to 64GB on-package, and terabytes-per-second bandwidth". Ars Technica. Retrieved 23 August 2016.

- ↑ "NVIDIA Announces Hopper Architecture, the Next Generation of Accelerated Computing".

बाहरी संबंध

- High Bandwidth Memory (HBM) DRAM (JESD235), JEDEC, October 2013

- Lee, Dong Uk; Kim, Kyung Whan; Kim, Kwan Weon; Kim, Hongjung; Kim, Ju Young; et al. (9–13 Feb 2014). "A 1.2V 8Gb 8‑channel 128GB/s high-bandwidth memory (HBM) stacked DRAM with effective microbump I/O test methods using 29nm process and TSV". 2014 IEEE International Solid-State Circuits Conference – Digest of Technical Papers. IEEE (published 6 March 2014): 432–433. doi:10.1109/ISSCC.2014.6757501. ISBN 978-1-4799-0920-9. S2CID 40185587.

- HBM vs HBM2 vs GDDR5 vs GDDR5X Memory Comparison