ओवरफिटिंग

| Part of a series on |

| Machine learning and data mining |

|---|

|

गणितीय मॉडलिंग में, ओवरफिटिंग "एक विश्लेषण का उत्पादन है जो डेटा के एक विशेष सेट के बहुत निकट या यथार्थ रूप से समान होता है, और इसलिए अतिरिक्त डेटा के लिए फिट होने में विफल हो सकता है या भविष्य की टिप्पणियों का विश्वसनीय रूप से अनुमान लगा सकता है"।[1] एक ओवरफिटेड मॉडल एक गणितीय मॉडल है जिसमें डेटा द्वारा उचित स्थिरता की तुलना में अधिक पैरामीटर होते हैं।[2] ओवरफिटिंग का संक्षिप्त अज्ञात में कुछ अवशिष्ट भिन्नता (अर्थात्, सांख्यिकीय शोर) को निकालना है जैसे कि भिन्नता अंतर्निहित मॉडल संरचना का प्रतिनिधित्व करती है।[3]: 45

अंडरफिटिंग तब होती है जब एक गणितीय मॉडल डेटा की अंतर्निहित संरचना को पर्याप्त रूप से अधिकृत नहीं कर सकता है। एक अंडर-फिटेड मॉडल एक ऐसा मॉडल है जहां कुछ पैरामीटर या शब्द जो सही संरचना से निर्दिष्ट मॉडल में दिखाई देंगे या लुप्त हो जायेगा।[2] अंडर-फिटिंग तब हो सकती है, उदाहरण के लिए, जब एक रैखिक मॉडल को गैर-रैखिक डेटा में फ़िट किया जाता है। इस तरह के मॉडल में अपर्याप्त पूर्वकथन प्रदर्शित होगा।

ओवर-फिटिंग की संभावना उपस्थित है क्योंकि मॉडल का चयन करने के लिए उपयोग किया जाने वाला मानदंड एक मॉडल की उपयुक्तता का न्याय करने के लिए उपयोग की जाने वाली मानदंड के समान नहीं है। उदाहरण के लिए, प्रशिक्षण डेटा के कुछ सेट पर इसके प्रदर्शन को अधिकतम करके एक मॉडल का चयन किया जा सकता है, और फिर भी इसकी उपयुक्तता को अनदेखे डेटा पर अच्छा प्रदर्शन करने की क्षमता से निर्धारित किया जा सकता है; तब ओवरफिटिंग जब होती है जब एक मॉडल एक प्रवृत्ति से सामान्यीकरण सीखने के अतिरिक्त प्रशिक्षण डेटा को याद करना प्रारंभ करता है।

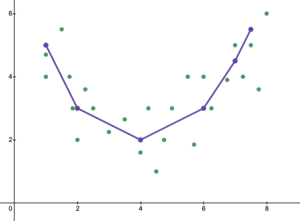

एक अत्यन्त उदाहरण के रूप में, यदि मापदंडों की संख्या टिप्पणियों की संख्या के समान हो या तो उससे अधिक हो, तो एक मॉडल डेटा को पूरी तरह से याद करके प्रशिक्षण डेटा का पूरी तरह से अनुमान लगा सकता है। (उदाहरण के लिए, चित्र 2 देखें।) चूँकि, इस तरह का मॉडल पूर्वकथन करते समय सामान्यतः गंभीर रूप से विफल हो जाएगा।

ओवरफिटिंग की क्षमता न केवल मापदंडों और डेटा की संख्या पर निर्भर करती है, अन्यथा डेटा आकार के साथ मॉडल संरचना की अनुरूपता और डेटा में शोर या त्रुटि के अपेक्षित स्तर की तुलना में मॉडल त्रुटि की परिमाण पर भी निर्भर करती है।[citation needed] यहां तक कि जब फिट किए गए मॉडल में अत्यधिक संख्या में पैरामीटर नहीं होते हैं, तो यह अपेक्षा की जाती है कि फिटिंग के लिए उपयोग किए जाने वाले डेटा सेट की तुलना में फिट किए गए संबंध नए डेटा सेट पर कम अच्छा प्रदर्शन करते हैं (कोई घटना जिसे कभी-कभी संकोचन के रूप में जाना जाता है).[2] विशेष रूप से, निर्धारण के गुणांक का मान मूल डेटा के सापेक्ष सिकुड़ जाएगा।

ओवरफिटिंग की संभावना या मात्रा को कम करने के लिए, कई विधियाँ उपलब्ध हैं (उदाहरण के लिए, मॉडल चयन, क्रॉस-वैलिडेशन (सांख्यिकी) , नियमितीकरण (गणित), जल्दी रोकना, छंटाई (कलन विधि), पूर्व वितरण, या ड्रॉपआउट (न्यूरल) नेटवर्क))। कुछ विधियों का आधार या तो (1) अत्यधिक जटिल मॉडल को स्पष्ट रूप से दंडित करना है या (2) प्रशिक्षण के लिए उपयोग नहीं किए गए डेटा के एक सेट पर इसके प्रदर्शन का मूल्यांकन करके सामान्यीकरण करने की मॉडल की क्षमता का परीक्षण करना है, जिसे विशिष्ट अनदेखे डेटा का अनुमान लगाया जाता है। कि एक मॉडल का सामना करना पड़ेगा।

सांख्यिकीय अनुमान

This section needs expansion. You can help by adding to it. (October 2017) |

सांख्यिकी में, एक सांख्यिकीय मॉडल से एक निष्कर्ष निकाला जाता है, जिसे कुछ प्रक्रिया के माध्यम से चुना गया है। बर्नहैम एंड एंडरसन, मॉडल चयन पर अपने बहुप्रतीक्षित पाठ में, तर्क देते हैं कि ओवरफिटिंग से बचने के लिए, हमें "पारसीमोनी के सिद्धांत" का पालन करना चाहिए।[3] लेखक निम्नलिखित भी बताते हैं।[3]: 32–33

ओवरफिटेड मॉडल & हेलिप; अधिकांश पैरामीटर अनुमानकों में पूर्वाग्रह से मुक्त होते हैं, लेकिन अनुमानित (और वास्तविक) नमूनाकरण भिन्नताएं होती हैं जो अनावश्यक रूप से बड़ी होती हैं (अनुमानकों की यथार्ता खराब होती है, जो कि एक अधिक उदार मॉडल के साथ पूरा किया जा सकता था)। झूठे निरूपण प्रभावों की पहचान की जाती है, और गलत चरों को ओवरफिटेड मॉडल के साथ सम्मिलित किया जाता है। & हेलिप; अंडरफ़िटिंग और ओवरफ़िटिंग की त्रुटियों को ठीक से संतुलित करके एक सर्वश्रेष्ठ अनुमानित मॉडल प्राप्त किया जाता है।

जब विश्लेषण को निर्देशित करने के लिए बहुत कम सिद्धांत उपलब्ध होते हैं, तो ओवरफिटिंग एक गंभीर चिंता का विषय हो सकता है, क्योंकि तब बड़ी संख्या में मॉडल का चयन करने की प्रवृत्ति होती है। पुस्तक मॉडल चयन और मॉडल औसत (2008) इसे इस तरह रखती है।[4]

एक डेटा सेट दिया गया है, आप एक बटन के पुश पर हजारों मॉडल फिट कर सकते हैं, लेकिन आप सर्वश्रेष्ठ कैसे चुनते हैं? इतने सारे उम्मीदवार मॉडल के साथ, ओवरफिटिंग एक वास्तविक खतरा है। क्या बंदर जिसने हैमलेट टाइप किया वास्तव में एक अच्छा लेखक है?

प्रतिगमन

प्रतिगमन विश्लेषण में, ओवरफिटिंग अधिकांश होती है।[5] एक अत्यंत उदाहरण के रूप में, यदि पी डेटा बिंदुओं के साथ एक रेखीय प्रतिगमन में पी चर हैं, तो फिट की गई रेखा प्रत्येक बिंदु के माध्यम से जा सकती है।[6] तार्किक प्रतिगमन या कॉक्स आनुपातिक खतरों के मॉडल के लिए, अंगूठे के विभिन्न नियम हैं (उदाहरण के लिए 5-9,[7] 10[8] और 10-15[9] - प्रति स्वतंत्र चर के 10 अवलोकनों के दिशानिर्देश को दस नियमों में से एक के रूप में जाना जाता है)। प्रतिगमन मॉडल चयन की प्रक्रिया में, यादृच्छिक प्रतिगमन फलन की औसत चुकता त्रुटि को प्रतिगमन फलन के अनुमान में यादृच्छिक शोर, सन्निकटन पूर्वाग्रह और विचरण में विभाजित किया जा सकता है। ओवरफिट मॉडल को दूर करने के लिए अधिकांश बायस-वैरियंस ट्रेडऑफ़ का उपयोग किया जाता है।

व्याख्यात्मक चर के एक बड़े सेट के साथ जिसका वास्तव में निर्भर चर से कोई संबंध नहीं है, कुछ चर सामान्य रूप से सांख्यिकीय रूप से महत्वपूर्ण होने के लिए गलत पाए जाएंगे और इस प्रकार शोधकर्ता उन्हें मॉडल में बनाए रख सकते हैं, जिससे मॉडल ओवरफिट हो जाएगा। इसे फ्रीडमैन के विरोधाभास के रूप में जाना जाता है।

यंत्र प्रशिक्षित

सामान्यतः एक प्रशिक्षित कलन विधि को प्रशिक्षण डेटा के कुछ सेट का उपयोग करके प्रशिक्षित किया जाता है: अनुकरणीय स्थितियाँ जिसके लिए वांछित परिणाम ज्ञात होता है। लक्ष्य यह है कि कलन विधि "सत्यापन डेटा" सिंचित किये जाने पर परिणाम की भविष्यवाणी करने पर भी अच्छा प्रदर्शन करेगा जो इसके प्रशिक्षण के दौरान सामने नहीं आया था।

ओवरफिटिंग उन मॉडलों या प्रक्रियाओं का उपयोग है जो ऑकैम के रेज़र का उल्लंघन करते हैं, उदाहरण के लिए अधिक समायोज्य मापदंडों को सम्मिलित करके जो अंततः विस्तृत हैं, या अंततः विस्तृत की तुलना में अधिक जटिल दृष्टिकोण का उपयोग करके। एक उदाहरण के लिए जहां बहुत अधिक समायोज्य पैरामीटर हैं, एक डेटासेट पर विचार करें जहां प्रशिक्षण डेटा के लिए y दो स्वतंत्र चरों के रैखिक फलन द्वारा पर्याप्त रूप से भविष्यवाणी की जा सकती है। इस तरह के फलन के लिए केवल तीन पैरामीटर (अवरोधन और दो ढलान) की आवश्यकता होती है। इस साधारण फलन को एक नए, अधिक जटिल द्विघात फलन के साथ, या दो से अधिक स्वतंत्र चर पर एक नए, अधिक जटिल रैखिक फलन के साथ बदलना, एक जोखिम वहन करता है: ओकाम के रेजर का अर्थ है कि कोई भी जटिल फलन किसी दिए गए सरल की तुलना में कम संभव है। समारोह। यदि सरल फलन के अतिरिक्त नए, अधिक जटिल फलन का चयन किया जाता है, और यदि जटिलता में वृद्धि को ऑफसेट करने के लिए प्रशिक्षण-डेटा फ़िट में पर्याप्त लाभ नहीं था, तो नया जटिल फलन डेटा से अधिक हो जाता है, और जटिल ओवरफ़िट फलन होगा प्रशिक्षण डेटासेट के बाहर सत्यापन डेटा पर सरल फलन की तुलना में खराब प्रदर्शन की संभावना है, फिर भी जटिल फलन ने प्रशिक्षण डेटासेट पर भी, या संभवतः इससे भी बेहतर प्रदर्शन किया हो।[10]

विभिन्न प्रकार के मॉडलों की तुलना करते समय, प्रत्येक मॉडल में कितने पैरामीटर उपस्थित हैं, इसकी गणना करके जटिलता को पूरी तरह से नहीं मापा जा सकता है; प्रत्येक पैरामीटर की अभिव्यक्ति पर भी विचार किया जाना चाहिए।उदाहरण के लिए, m पैरामीटर वाले न्यूरल नेट (जो वक्रीय संबंधों को ट्रैक कर सकता है) की जटिलता की सीधे n पैरामीटर वाले रिग्रेशन मॉडल से तुलना करना तुच्छ नहीं है।।[10]

ओवरफिटिंग विशेष रूप से उन मामलों में होने की संभावना है जहां सीखने को बहुत लंबा प्रदर्शन किया गया था या जहां प्रशिक्षण के उदाहरण दुर्लभ हैं, जिससे शिक्षार्थी प्रशिक्षण डेटा की बहुत विशिष्ट यादृच्छिक विशेषताओं को समायोजित कर सकते हैं जिनका फलन सन्निकटन से कोई संबंध नहीं है। ओवरफिटिंग की इस प्रक्रिया में, प्रशिक्षण उदाहरणों पर प्रदर्शन अभी भी बढ़ता है जबकि अनदेखे डेटा पर प्रदर्शन खराब हो जाता है।

एक साधारण उदाहरण के रूप में, खुदरा खरीद के एक डेटाबेस पर विचार करें जिसमें खरीदी गई वस्तु, खरीदार और खरीदारी की तारीख और समय सम्मिलित है। एक मॉडल का निर्माण करना आसान है जो अन्य विशेषताओं की भविष्यवाणी करने के लिए खरीद की तिथि और समय का उपयोग करके प्रशिक्षण सेट को पूरी तरह से फिट करेगा, लेकिन यह मॉडल नए डेटा के लिए बिल्कुल सामान्य नहीं होगा, क्योंकि वे पिछले समय फिर कभी नहीं होंगे।

सामान्यतः, एक सीखने के कलन विधि को एक सरल के सापेक्ष ओवरफिट कहा जाता है यदि यह ज्ञात डेटा (पूर्वदृष्टि) को फिट करने में अधिक यथार्थ है लेकिन नए डेटा (दूरदर्शिता) की भविष्यवाणी करने में कम यथार्थ है। कोई भी इस तथ्य से ओवरफिटिंग को सहज रूप से समझ सकता है कि पिछले सभी अनुभवों की जानकारी को दो समूहों में विभाजित किया जा सकता है: वह जानकारी जो भविष्य के लिए प्रासंगिक है, और अप्रासंगिक जानकारी (शोर)। बाकी सब कुछ समान होने के कारण, एक मानदंड का अनुमान लगाना जितना जटिल होता है (अर्थात, इसकी अनिश्चितता उतनी ही अधिक होती है), पूर्व की जानकारी में उतना ही अधिक शोर उपस्थित होता है जिसे अनदेखा करने की आवश्यकता होती है। समस्या यह निर्धारित कर रही है कि किस भाग को अनदेखा करना है। एक प्रशिक्षित कलन विधि जो फिटिंग शोर के जोखिम को कम कर सकता है, उसे रोबस्ट (कंप्यूटर साइंस) मशीन प्रशिक्षित कहा जाता है।

परिणाम

ओवरफिटिंग का सबसे स्पष्ट परिणाम सत्यापन डेटासेट पर खराब प्रदर्शन है। अन्य ऋणात्मक परिणामों में सम्मिलित हैं:[10]

- एक फ़ंक्शन जो ओवरफिटेड है, सर्वोत्तम फ़ंक्शन की तुलना में सत्यापन डेटासेट में प्रत्येक आइटम के बारे में अधिक जानकारी का अनुरोध करने की संभावना है; इस अतिरिक्त अनावश्यक डेटा को इकट्ठा करना महंगा या त्रुटि-प्रवण हो सकता है, खासकर यदि प्रत्येक व्यक्तिगत जानकारी को मानव अवलोकन और मैन्युअल डेटा-प्रविष्टि द्वारा इकट्ठा किया जाना चाहिए।

- एक अधिक जटिल, ओवरफिटेड फलन एक साधारण से कम पोर्टेबल होने की संभावना है। एक अत्यंत पर, एक-चर रैखिक प्रतिगमन इतना पोर्टेबल है कि, यदि आवश्यक हो, तो इसे हाथ से भी किया जा सकता है। दूसरे छोर पर ऐसे मॉडल हैं जिन्हें केवल मूल मॉडलर के संपूर्ण सेटअप को हूबहू डुप्लिकेट करके पुन: प्रस्तुत किया जा सकता है, जिससे पुन: उपयोग या वैज्ञानिक पुनरुत्पादन जटिल हो जाता है।

उपाय

सर्वोत्तम कार्य को सामान्यतः बड़े या पूरी तरह से नए डेटासेट पर सत्यापन की आवश्यकता होती है। हालाँकि, न्यूनतम फैले हुए पेड़ या सहसंबंध के जीवनकाल जैसी विधियाँ हैं जो सहसंबंध गुणांक और समय-श्रृंखला (खिड़की की चौड़ाई) के बीच निर्भरता को लागू करती हैं। जब भी खिड़की की चौड़ाई काफी बड़ी होती है, सहसंबंध गुणांक स्थिर होते हैं और अब खिड़की की चौड़ाई के आकार पर निर्भर नहीं होते हैं। इसलिए, जांच किए गए चर के बीच सहसंबंध के गुणांक की गणना करके एक सहसंबंध मैट्रिक्स बनाया जा सकता है। इस मैट्रिक्स को स्थैतिक रूप से एक जटिल नेटवर्क के रूप में दर्शाया जा सकता है जहां चर के बीच प्रत्यक्ष और अप्रत्यक्ष प्रभावों की कल्पना की जाती है। ड्रॉपआउट नियमितीकरण भी मजबूती में सुधार कर सकता है और इसलिए संभावित रूप से एक परत में इनपुट को हटाकर ओवरफिटिंग को कम कर सकता है।

अंडरफिटिंग

अंडरफिटिंग ओवरफिटिंग का व्युत्क्रम है, जिसका अर्थ है कि सांख्यिकीय मॉडल या मशीन प्रशिक्षित कलन विधि डेटा का यथार्थ रूप से प्रतिनिधित्व करने के लिए बहुत सरल है। अंडरफ़िटिंग का एक संकेत यह है कि वर्तमान मॉडल या उपयोग किए गए कलन विधि में एक उच्च पूर्वाग्रह और निम्न विचरण का पता चला है (ओवरफिटिंग का व्युत्क्रम: निम्न पूर्वाग्रह और उच्च विचरण)। इसे बाईस-वैरिएंस ट्रेडऑफ़ से एकत्र किया जा सकता है जो कि बायस एरर, झगड़ा एरर और अलघुकरणीय एरर के लिए मॉडल या कलन विधि का विश्लेषण करने की विधि है। एक उच्च पूर्वाग्रह और कम विचरण के साथ मॉडल का परिणाम यह है कि यह गलत विधियों से डेटा बिंदुओं का प्रतिनिधित्व करेगा और इस प्रकार अपर्याप्त रूप से भविष्य के डेटा परिणामों की भविष्यवाणी करने में सक्षम होगा (सामान्यीकरण त्रुटि देखें)। चित्र 5 में दिखाया गया है कि रेखीय रेखा दिए गए सभी डेटा बिंदुओं का प्रतिनिधित्व नहीं कर सकती है क्योंकि रेखा बिंदुओं की वक्रता के समान नहीं है। जैसा कि चित्र 6 और चित्र 1 में दिखाया गया है, हम एक परवलय के आकार की रेखा देखने की अपेक्षा करेंगे। जैसा कि पहले उल्लेख किया गया है कि यदि हम विश्लेषण के लिए चित्र 5 का उपयोग करते हैं तो हम परिणामों के विपरीत झूठे भविष्य कहनेवाला परिणाम प्राप्त करेंगे यदि हम चित्र 6 का विश्लेषण करते हैं।

बर्नहैम और एंडरसन निम्नलिखित बताते हैं।[3]: 32

& हेलिप; एक अंडरफिटेड मॉडल डेटा में कुछ महत्वपूर्ण प्रतिकृति योग्य (यानी, अधिकांश अन्य नमूनों में वैचारिक रूप से प्रतिकृति योग्य) संरचना की उपेक्षा करेगा और इस प्रकार उन प्रभावों की पहचान करने में विफल होगा जो वास्तव में डेटा द्वारा समर्थित थे। इस मामले में, पैरामीटर अनुमानकों में पूर्वाग्रह अधिकांश पर्याप्त होता है, और आकृति भिन्नता को कम करके समझा जाता है, दोनों कारकों के परिणामस्वरूप खराब आत्मविश्वास अंतराल कवरेज होता है। अंडरफिटेड मॉडल प्रायोगिक सेटिंग्स में महत्वपूर्ण उपचार प्रभावों को याद करते हैं।

अंडरफिटिंग का समाधान

अंडरफिटिंग को कई विधियों द्वारा हल किया जा सकता है, मॉडल के पैरामीटर को बढ़ाने या अधिक प्रशिक्षण डेटा जोड़ने के लिए एक संभावित विधि हो सकती है। अधिक प्रशिक्षण डेटा जोड़ने से वर्तमान सुविधाओं (फ़ीचर इंजीनियरिंग के रूप में जाना जाता है) से नई सुविधाएँ प्राप्त करके प्राप्त किया जा सकता है। एक अन्य संभावित विधि यह होगी कि वर्तमान सांख्यिकीय मॉडल या मशीन प्रशिक्षित कलन विधि से अलग एक अलग मॉडल की ओर ले जाया जाए जो डेटा का बेहतर प्रतिनिधित्व कर सके।

यह भी देखें

- पूर्वाग्रह-विचरण समझौता

- वक्र फिटिंग

- डेटा ड्रेजिंग

- फीचर चयन

- फीचर इंजीनियरिंग

- फ्रीडमैन का विरोधाभास

- सामान्यीकरण त्रुटि

- स्वस्थ रहने के फायदे

- सहसंबंध का जीवनकाल

- मॉडल चयन

- स्वतंत्रता की शोधकर्ता डिग्री

- ओकाम का उस्तरा

- Helmut_Norpoth#%22Primary_Model%22_for_US_presidential_elections

- वीसी आयाम - बड़े वीसी आयाम का तात्पर्य ओवरफिटिंग के बड़े जोखिम से है

टिप्पणियाँ

- ↑ Definition of "overfitting" at OxfordDictionaries.com: this definition is specifically for statistics.

- ↑ Jump up to: 2.0 2.1 2.2 Everitt B.S., Skrondal A. (2010), Cambridge Dictionary of Statistics, Cambridge University Press.

- ↑ Jump up to: 3.0 3.1 3.2 3.3 Burnham, K. P.; Anderson, D. R. (2002), Model Selection and Multimodel Inference (2nd ed.), Springer-Verlag.

- ↑ Claeskens, G.; Hjort, N.L. (2008), Model Selection and Model Averaging, Cambridge University Press.

- ↑ Harrell, F. E. Jr. (2001), Regression Modeling Strategies, Springer.

- ↑ Martha K. Smith (2014-06-13). "ओवरफिटिंग". University of Texas at Austin. Retrieved 2016-07-31.

- ↑ Vittinghoff, E.; McCulloch, C. E. (2007). "रसद और कॉक्स रिग्रेशन में प्रति चर दस घटनाओं के नियम को शिथिल करना". American Journal of Epidemiology. 165 (6): 710–718. doi:10.1093/aje/kwk052. PMID 17182981.

- ↑ Draper, Norman R.; Smith, Harry (1998). अनुप्रयुक्त प्रतिगमन विश्लेषण (3rd ed.). Wiley. ISBN 978-0471170822.

- ↑ Jim Frost (2015-09-03). "ओवरफिटिंग रिग्रेशन मॉडल का खतरा". Retrieved 2016-07-31.

- ↑ Jump up to: 10.0 10.1 10.2 Hawkins, Douglas M (2004). "ओवरफिटिंग की समस्या". Journal of Chemical Information and Modeling. 44 (1): 1–12. doi:10.1021/ci0342472. PMID 14741005.

संदर्भ

- Leinweber, D. J. (2007). "Stupid data miner tricks". The Journal of Investing. 16: 15–22. doi:10.3905/joi.2007.681820. S2CID 108627390.

- Tetko, I. V.; Livingstone, D. J.; Luik, A. I. (1995). "Neural network studies. 1. Comparison of Overfitting and Overtraining" (PDF). Journal of Chemical Information and Modeling. 35 (5): 826–833. doi:10.1021/ci00027a006.

- Tip 7: Minimize overfitting. Chicco, D. (December 2017). "Ten quick tips for machine learning in computational biology". BioData Mining. 10 (35): 35. doi:10.1186/s13040-017-0155-3. PMC 5721660. PMID 29234465.

अग्रिम पठन

- Christian, Brian; Griffiths, Tom (April 2017), "Chapter 7: Overfitting", Algorithms To Live By: The computer science of human decisions, William Collins, pp. 149–168, ISBN 978-0-00-754799-9

बाहरी संबंध

- Overfitting: when accuracy measure goes wrong – introductory video tutorial

- The Problem of Overfitting Data – Stony Brook University

- What is "overfitting," exactly? – Andrew Gelman blog

- CSE546: Linear Regression Bias / Variance Tradeoff – University of Washington

- Underfitting and Overfitting in machine learning and how to deal with it !!! – Towards Data Science

- What is Underfitting – IBM

- ML | Underfitting and Overfitting – Geeks for Geeks article - Dewang Nautiyal